| Anzahl Gruppen | Anzahl Vergleiche | Signifikanzniveau \(\alpha\) | Maximal signifikanter p-Wert | \(H_0\) fälschlich abgelehnt |

|---|---|---|---|---|

| 2 | 1 | 5% | 0.0500 | 0 |

| 3 | 3 | 14% | 0.0167 | 0 |

| 4 | 6 | 26% | 0.0083 | 0 |

| 5 | 10 | 40% | 0.0050 | 0 |

| 6 | 15 | 54% | 0.0033 | 0 |

| 7 | 21 | 66% | 0.0024 | 1 |

| 8 | 28 | 76% | 0.0018 | 1 |

| 9 | 36 | 84% | 0.0014 | 1 |

| 10 | 45 | 90% | 0.0011 | 2 |

| 11 | 55 | 94% | 0.0009 | 2 |

| 12 | 66 | 97% | 0.0008 | 3 |

44 Der Post-hoc Test

Letzte Änderung am 06. June 2025 um 20:54:30

“Comparison is the thief of joy.” — Theodore Roosevelt

In diesem Kapitel wollen wir uns mit den multiplen Vergleichen (eng. post hoc analysis) oder auch paarweise Gruppenvergleiche genannt beschäftigen. Wir kennen diese multiplen Tests auch unter dem Namen Post-hoc Tests, da wir historisch diese Tests nach einer ANOVA durchgeführt haben. Das heißt, wir wollen statistisch Testen, ob sich verschiedene Gruppen einer Behandlung voneinander unterschieden. Technisch Testen wir dabei, ob sich die Level eines Faktors voneinander unterscheiden. Wir können dabei mehrere Faktoren bzw. Behandlungen berücksichtigen und gleichzeitig Testen. Wenn wir nur einen Faktor betrachten, dann sprechen wir von einem einfaktoriellen Vergleich. Wenn wir zwei Behandlungen betrachten, dann entsprechend von einem zweifaktoriellen Vergleich. Sehr selten haben wir dann noch den Fall vorliegen, dass wir drei Faktoren betrachten wollen. In einer Abschlussarbeit haben wir faktisch keine Versuche wo wir mehr als drei Faktoren in einem Gruppenvergleich berücksichtigen.

{emmeans}!

Dieses Kapitel ist lang und vieles habe ich hier gerechnet, damit du es nicht musst. Wenn du keine Zeit hast, dann springe gleich in den Abschnitt mit dem effektiven Pfad mit {emmeans} und lasse den Rest links und rechts liegen. Wir freuen uns das es den Rest gibt, aber du willst ja fertig werden und nicht staunen, was andere so alles entwickelt haben. Und das ist vollkommen okay!

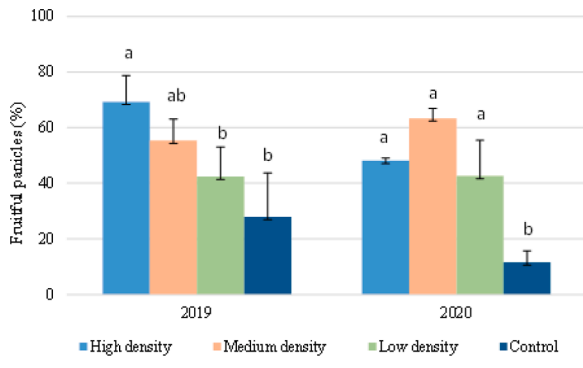

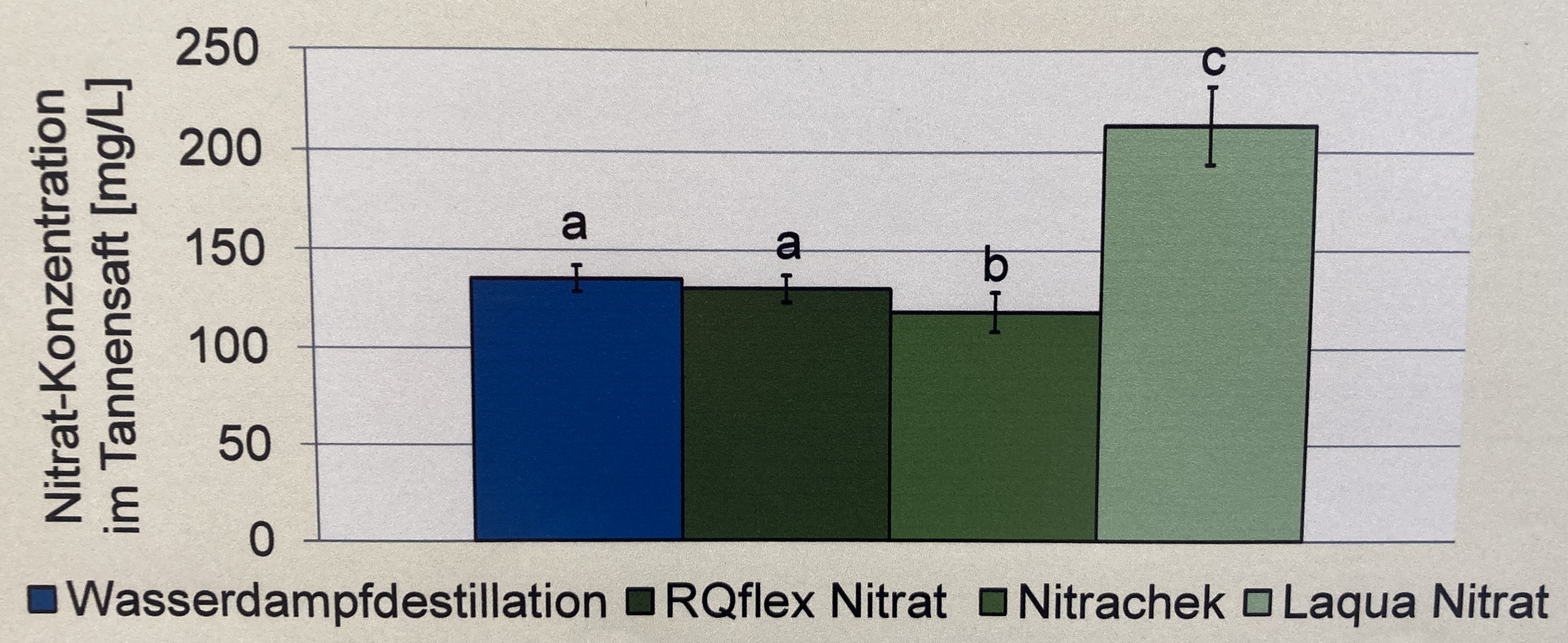

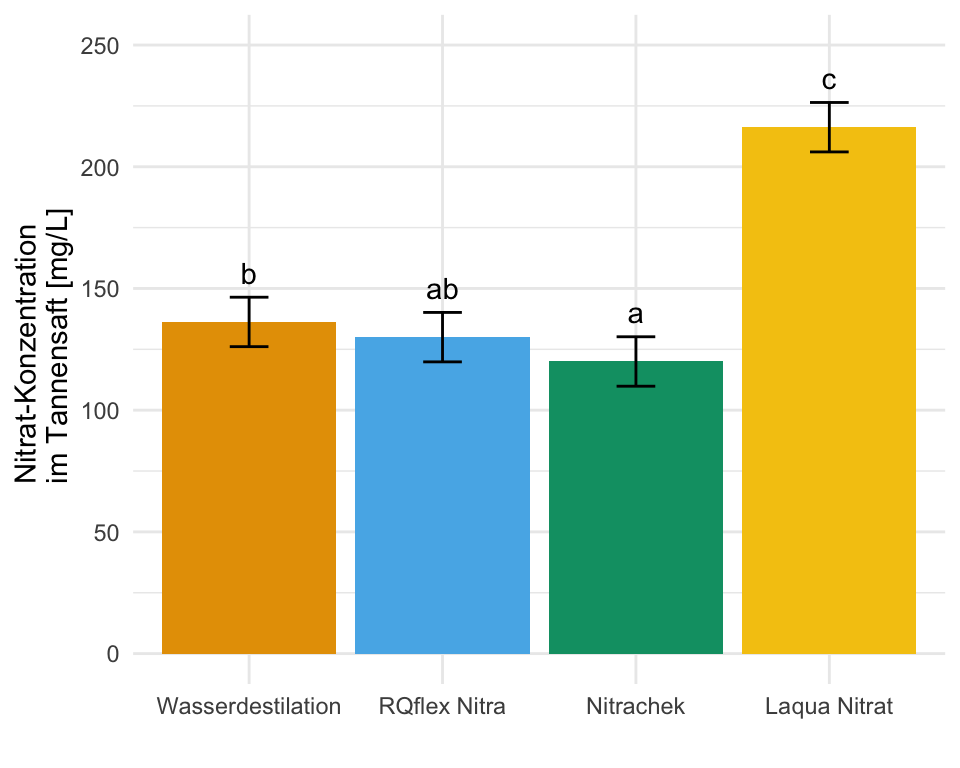

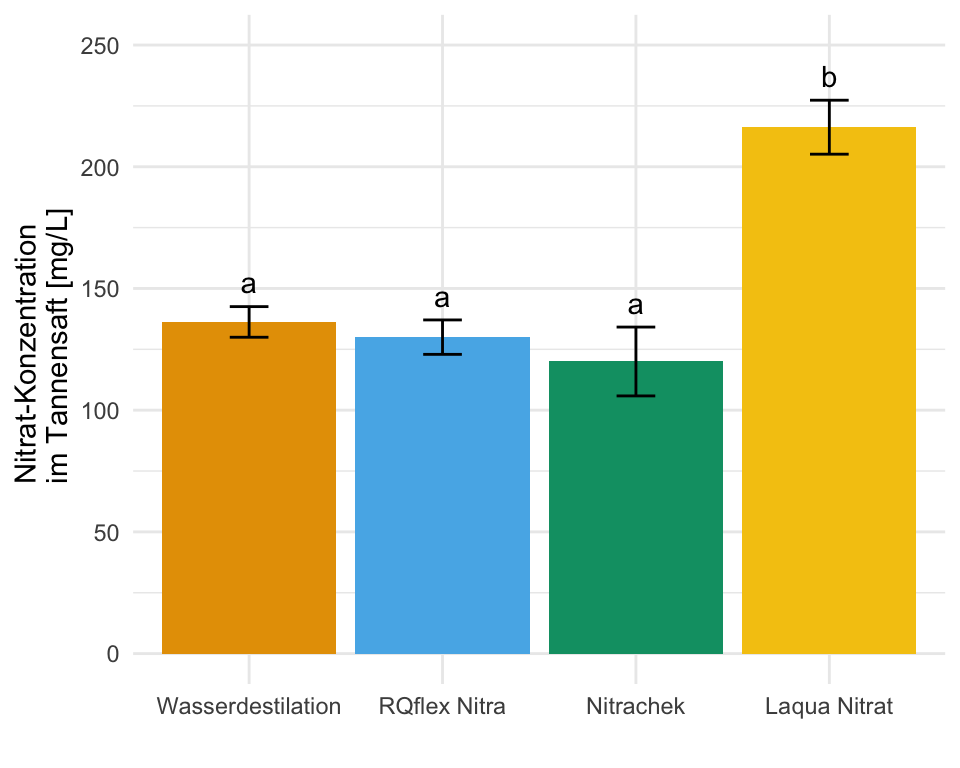

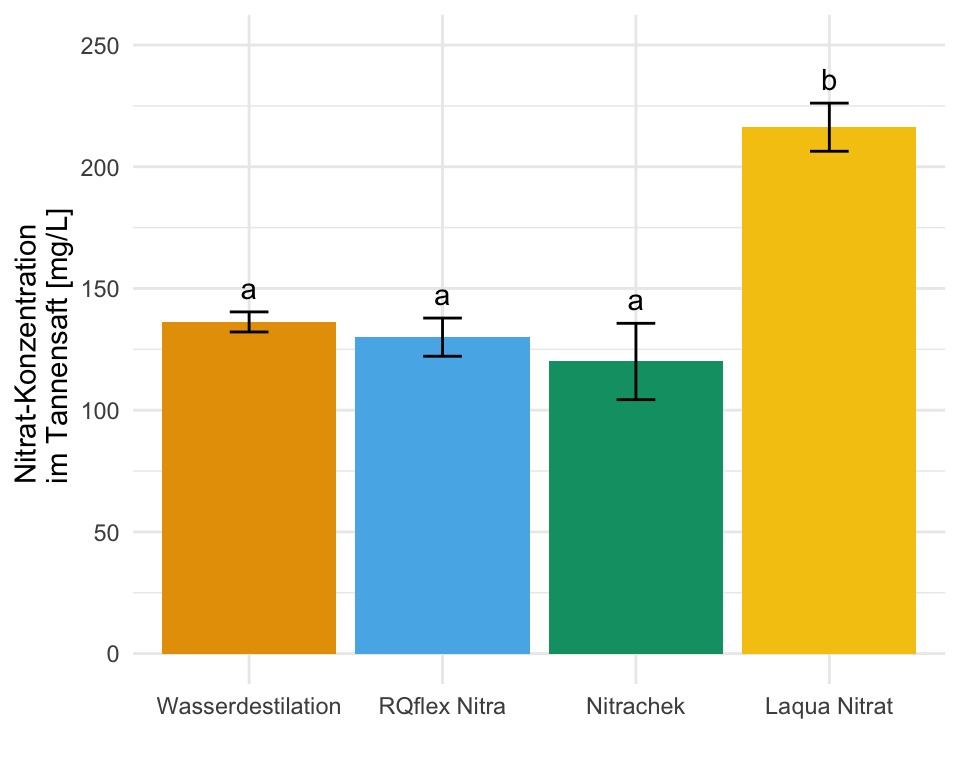

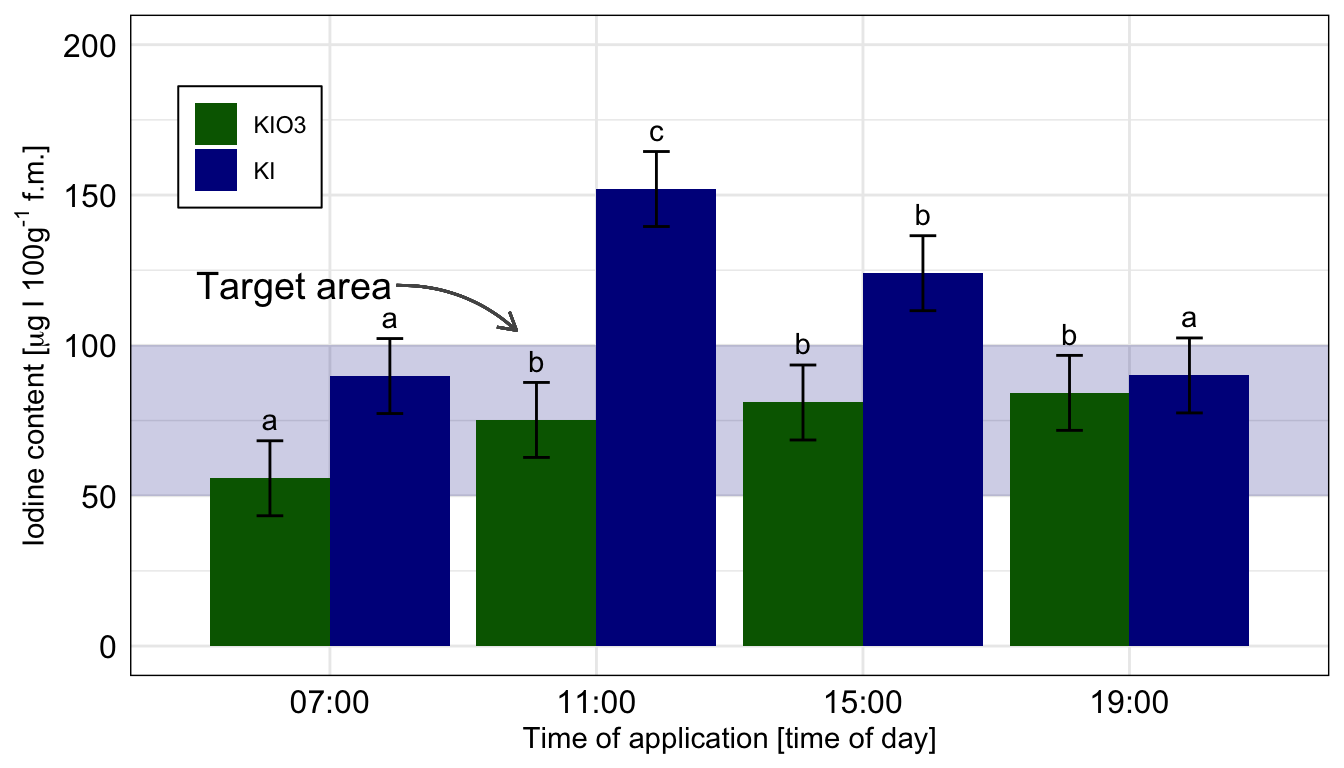

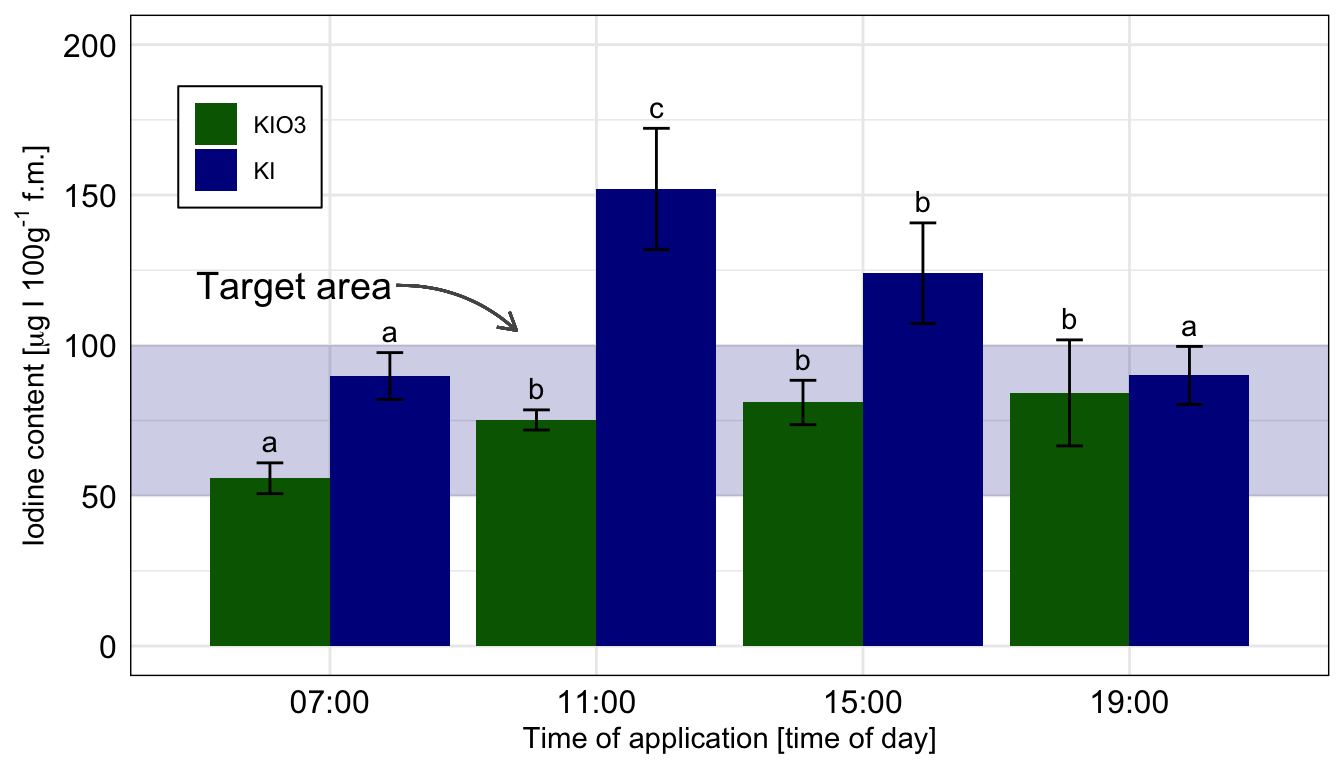

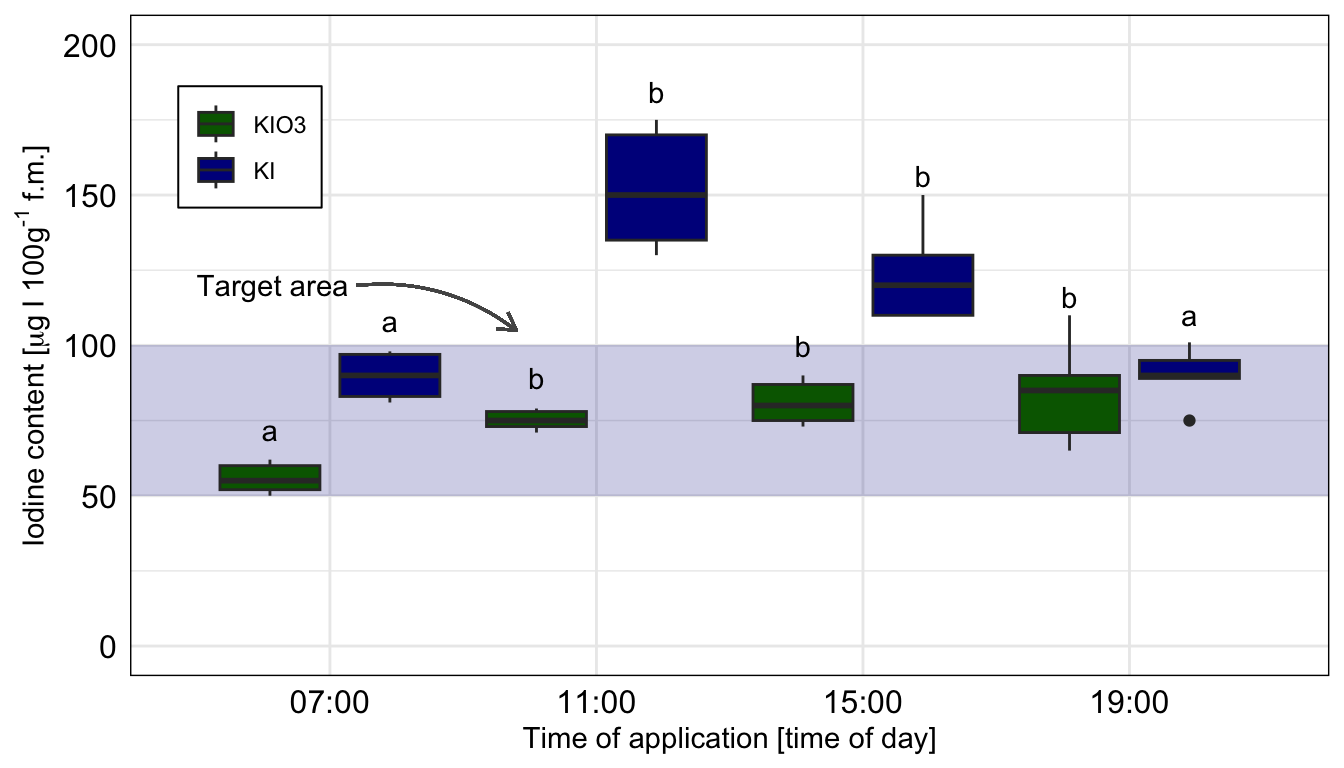

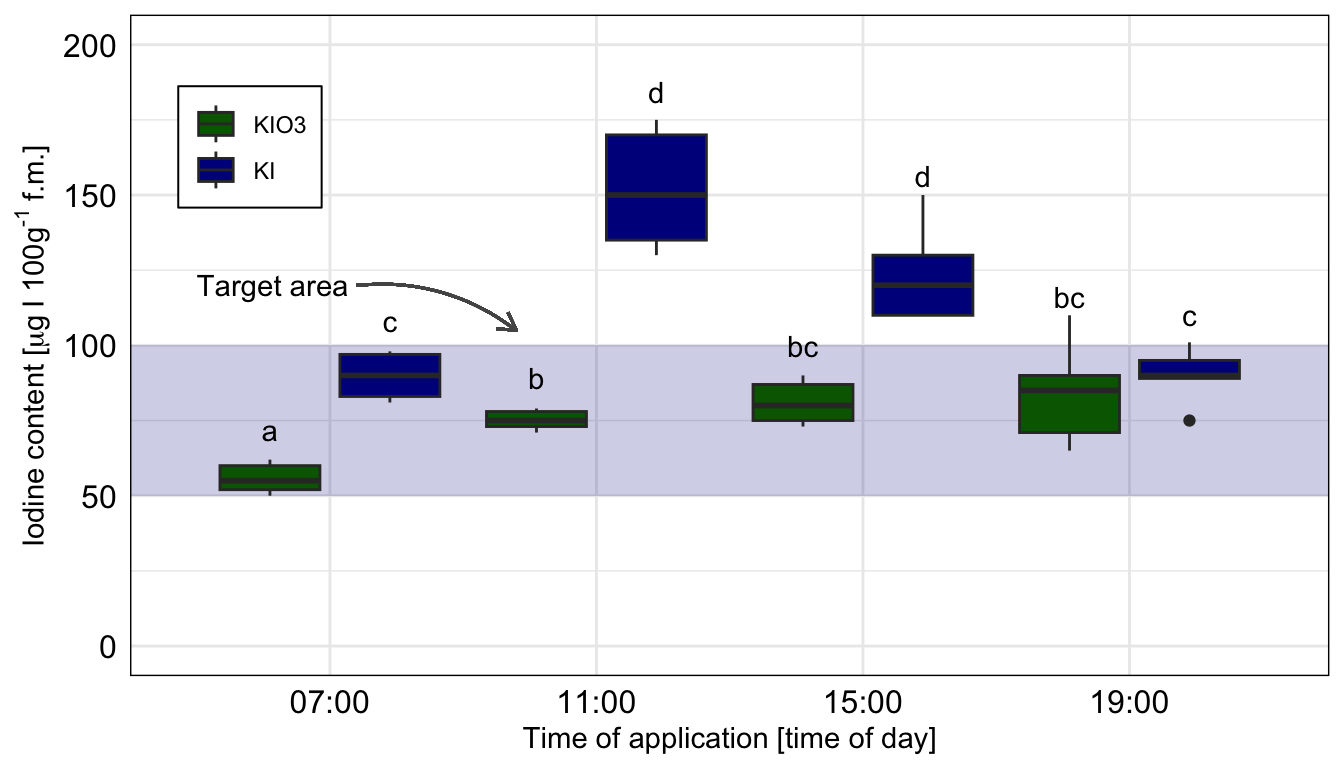

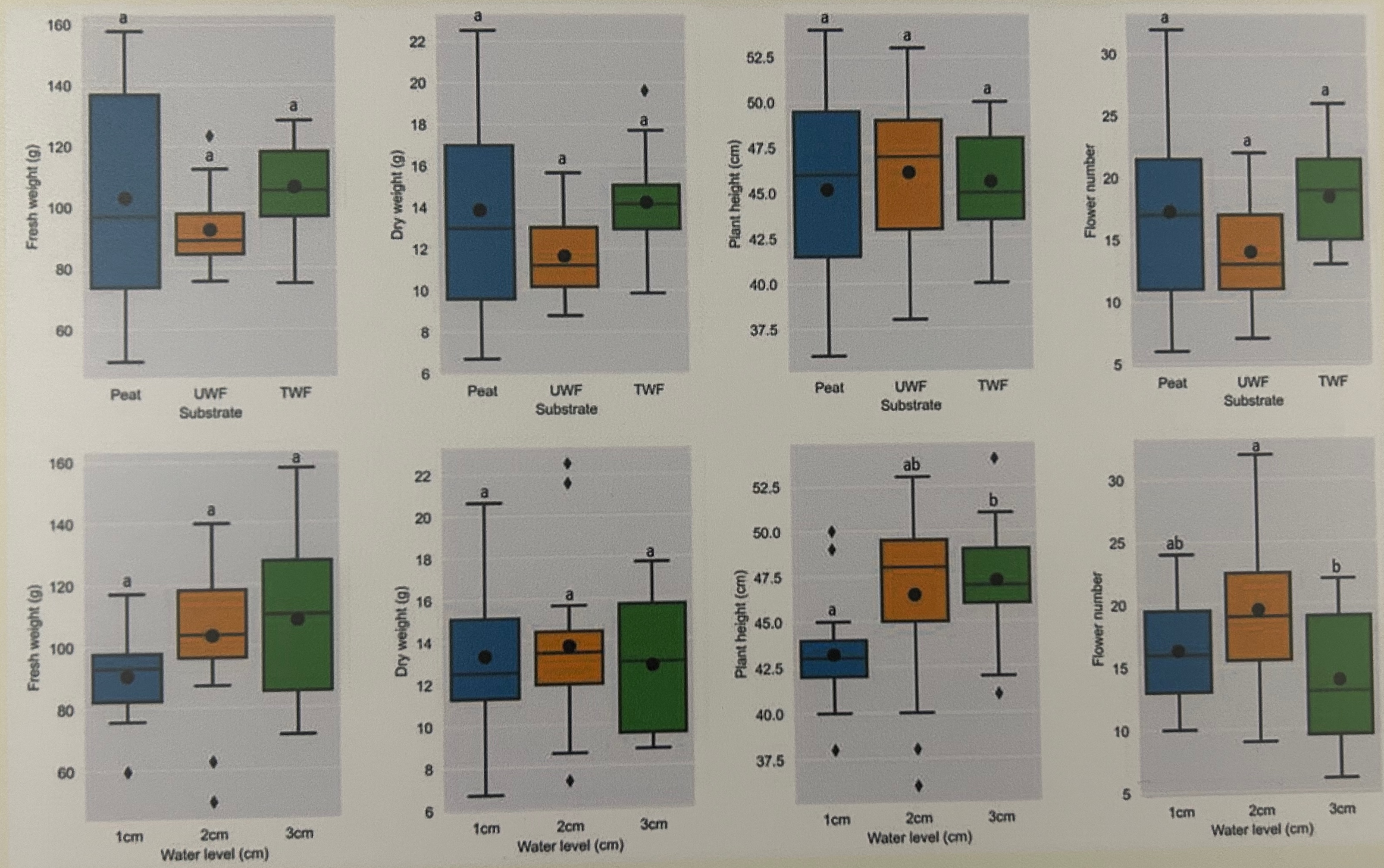

Wo wollen wir also mit unserem Post-hoc Test hin? Betrachten wir dazu einmal eine wissenschaftliche Veröffentlichungen als Beispiele. In der folgenden Abbildung sehen wir ein Säulendigramm aus der wissenschaftlichen Veröffentlichung von Sánchez et al. (2022) mit dem Titel “Hoverfly pollination enhances yield and fruit quality in mango under protected cultivation”. Dargestellt ist der mittlere Anteil an tragenden Rispen (eng. panicles) von Mango unter verschiedenen Ausbringungsdichten von Schwebfliegen (eng. hoverfly).

Wir haben hier ein typisches zweifaktorielles Design vorliegen. Zum einen den Faktor treatment mit den Gruppen High density, medium density, Low density und Control. Der zweite Faktor ist dann das Jahr der Messung mit zwei Jahren. Wir sehen hier die Buchstaben des Compact letter displays über den Mittelwerten als Säulen dargestellt. Das Compact letter display wollen wir dann hier in diesem Kapitel erstellen. Ein weiteres Beispiel findest du in der wissenschaftlichen Veröffentlichung von Salinas et al. (2023) mit dem Titel “Plant Growth, Yield, and Fruit Size Improvements in ‘Alicia’ Papaya Multiplied by Grafting”.

44.1 Theoretischer Hintergrund

In diesem Kapitel werde ich ein paar Engel der Statistik niedergeschlagen oder überfahren. Ich lasse aus Gründen der Didaktik ein paar Sachen weg und dadurch wird einiges leider dann mathematisch unkorrekt. Oder eben das klassische lying-to-children. Ich kann damit leben und nehme es auf mich damit du deine Abschlussarbeit fertig bekommst.

Fangen wir nochmal mit etwas theoretischen Hintergrund an. Das heißt wir schauen uns nochmal die wichtigsten Konzepte vom multiplen Testen einmal an. Wichtig ist hier, dass du eben mehr als zwei Gruppen miteinander vergleichen willst. Teilweise hast du mehr als sieben Gruppen und dann wird es schon eine Menge an Vergleichen. Wenn du alle möglichen vergleiche zwischen allen Gruppen rechnen willst, dann nennt man dies den all-pair Vergleich. Es werden eben alle möglichen Paare an Gruppen verglichen. Beginnen wir also mit der Frage nach der Anzahl an möglichen Vergleichen und was dies für unsere statistische Auswertung bedeutet.

- Wie viel ist den all-pair? Also alle möglichen Vergleiche?

-

Wenn du alle möglichen Mittelwertkombinationen testen willst, dann ist die Formel für die Berechnung der durchzuführenden Vergleiche \(r = m(m-1)/2\). Oder um es einmal in der folgenden Tabelle etwas konkreter darzustellen, werden es sehr schnell sehr viele Vergleiche. Dabei drückst du mit jeder zusätzlichen Behandlungsgruppe das Signifikanzniveau \(\alpha\) weiter runter, da die Anzahl an potenziellen Vergleichen sehr schnell ansteigt. So fällt dann auch der maximal noch signifikante p-Wert schnell ab. Damit brauchst du dann immer stärkere Effekt, wie einen Mittelwertsunterschied, um überhaupt noch was signifikantes aus einem statistischen Test wiedergeben zu bekommen. In der folgenden Tabelle siehst du dann nochmal den Zusammenhang. Ohne Adjustierung des Signifikanzniveaus erhalten wir schon ab sechs Gruppen mindestens einen signifikanten Unterschied auch wenn es gar keinen Unterschied in den Daten gibt. Denke immer daran, das Signifikanzniveau \(\alpha\) gibt an wie groß unsere Fehlerrate an falsch positiven Ergebnissen ist. Also die Nullhypothese mit dem statistischen Test abzulehnen, obwohl wir eigenlich keinen Unterschied vorliegen haben.

Jetzt kommt natürlich die Frage auf, ob ich immer adjustieren muss oder nicht. Wir immer gibt es da keine so richtig klare Antwort drauf. Rubin (2024) diskutiert in der wissenschaftlichen Veröffentlichung Inconsistent multiple testing corrections: The fallacy of using family-based error rates to make inferences about individual hypotheses das wir es auch lassen können mit der Adjustierung. Es gibt Gründe, die p-Werte zu adjustieren und es gibt auch gute Gründe die p-Werte ohne Adjustierung für multiple Vergleiche anzugeben. Hier hilft dann aber die statistische Betrachtung nicht weiter sondern du musst dir den Sachverhalt im Kontext deiner wissenschaftlichen Fragestelllung nochmal genauer anschauen.

- Was bedeutet konservativ und was liberal?

-

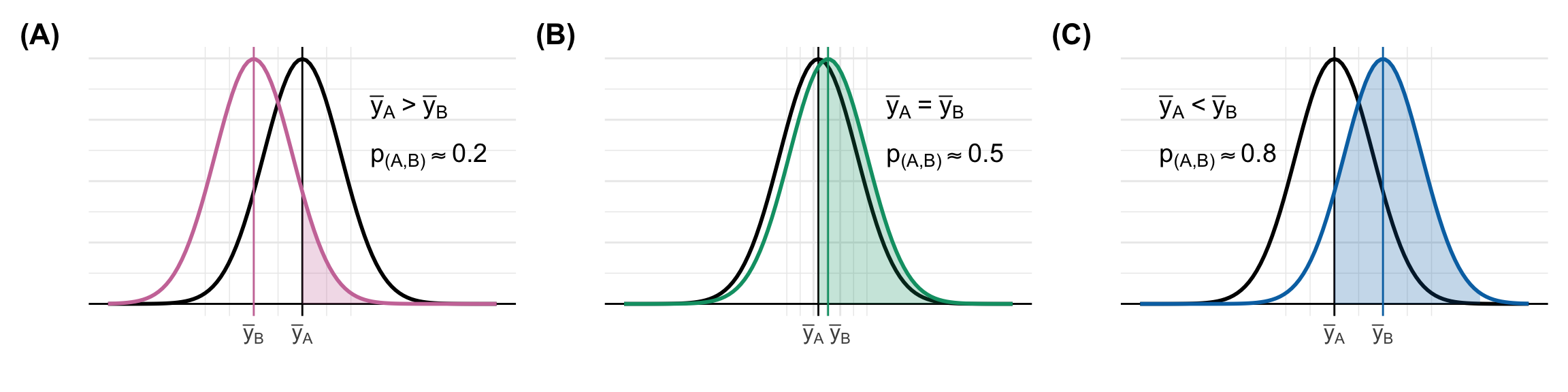

Häufiger schreibe ich mal das ein statistischer Test konservativ wird oder aber eher liberal testet. Das klingt jetzt etwas schräg sind aber bekannte Begriffe in der Fachsprache der Statistik. Es geht hierbei um die Bewertung des globalen Signifikanzniveau über alle Vergleiche hinweg. Wichtig ist, dass wir häufig nicht exakt wissen, wie groß das Signifikanzniveau in deinem speziellen Datenfall ist. Deshalb ist konservativ und liberal eher als Tendenz zu verstehen.

Wenn wir von einem konservativen Test sprechen, dann meinen wir, dass wir weniger signifikante Ergebnisse erwarten werden, als es bei einem Signifikanzniveau von \(\alpha\) gleich 5% zu erwarten wäre. Der Post-hoc Test nutzt nicht die vollen 5% Fehlerrate sondern testet global zu einem niedrigeren Signifikanzniveau. Wenn wir von einem liberalen Test sprechen, dann testen wir zu einem höheren Signifikanzniveau als \(\alpha\) gleich 5%. Wir werden also mehr signifikante Unterschiede finden als wir mit einer globalen Fehlerrate von 5% erwarten würden.

| Globales Signifikanzniveau \(\alpha\) | Bemerkung | |

|---|---|---|

| konservativ | \(\leq 5\%\) | Weniger signifikante Unterschiede |

| liberal | \(\geq 5\%\) | Mehr signifikante Unterschiede |

- Wie viele multiple Tests gibt es eigentlich?

-

Es gibt eine Menge an multiplen Tests oder auch Post-hoc Tests. Ich habe dir hier mal eine kleine Tabelle mitgebracht, die dir vier Post-hoc Tests im Vergleich zeigt. Ich habe die Auswahl etwas willkürlich getroffen, es gibt noch viel mehr Post-hoc Tests als ich in diesem Kapitel vorstelle. Wichtig für dich ist aber, dass es eigentlich auf die Entscheidung zwischen dem Tukey HSD Test oder eben dem R Paket

{emmeans}herausläuft. Ja, es gibt eben noch die anderen Tests, aber diese haben eine eher Nischenanwendung. Darüber hinaus kannst du{emmeans}so konfigurieren, dass du im Prinzip einen besseren Tukey HSD Test für Varianzhomogenität oder aber einen Games Howell Test für Vanrianzheterogenität rechnest ohne die Nachteil der orginalen Implemntierung. Das ist doch toll!

In einer normalen agarwissenschaftlichen Abschlussarbeit mit einem Feldexperiment und zwei Faktoren \(f_1\) und \(f_2\) läuft es eben dann doch auf den Tukey HSD Test oder Games Howell Test heraus. So ist eben die Normalverteilung des Messwertes \(y\) eben ein sehr starkes Kriterium zur Wahl des Tests. Da dann häufig noch die ANOVA vorgeschaltet wird sind wir dann im ANOVA Pfad mit dem Tukey HSD Test. Wichtig ist noch, dass du schauen musst, ob die Varianz in deinen Gruppen \(x\) eher homogen oder heterogen ist. Davon hängt dann die Entschiedung für oder gegen den Tukey HSD Test ab. Wenn dein Messwert \(y\) nicht normalverteilt ist, dann musst du eine anderes Modell rechnen, diese Modelle stelle ich später noch vor. Auch ist die Frage, ob du adjustierte p-Werte möchtest oder nicht. Hier hängt es auch von der Anwendung ab, ob du die Adjustierung für multiple Vergleiche ausstellen kannst.

{emmeans} mit seiner Flexibilität und einfachen Handbarkeit heraus. Die Mindestfallzahl per Gruppe \(n_g\) ist eher als Empfehlung zu verstehen und als untere Grenze. Achtung, teilweise müssen die Optionen aktiv von dir aktiviert werden. Sie dazu auch den Friedhof der Post-ho Tests in diesem Kapitel.

| Tukey HSD | Games Howell | {emmeans} |

{multcomp} |

|

|---|---|---|---|---|

| Verteilung von \(y\) | normalverteilt | normalverteilt | beliebig | beliebig |

| Varianzen der Gruppen \(x\) | homogen | heterogen | beliebig | beliebig |

| Fallzahl per Gruppe \(n_g\) | balanciert; \(n_g \geq 4\) | beliebig; \(n_g \geq 6\) | beliebig; \(n_g \geq 4\) | beliebig; \(n_g \geq 4\) |

| Adjustierte p-Werte | immer | immer | beliebig | beliebig |

| Mögliche Vergleiche | all-pair | all-pair | beliebig | beliebig |

44.2 Genutzte R Pakete

Wir wollen folgende R Pakete in diesem Kapitel nutzen.

R Code [zeigen / verbergen]

pacman::p_load(tidyverse, readxl, knitr, kableExtra, see, nparcomp,

multcomp, emmeans, multcompView, nlme, janitor,

parameters, patchwork, agricolae, broom, rstatix,

DescTools, rcompanion, magrittr, quantreg, effectsize,

conflicted)

conflicts_prefer(dplyr::select)

conflicts_prefer(dplyr::filter)

conflicts_prefer(magrittr::set_names)

conflicts_prefer(effectsize::eta_squared)

cbbPalette <- c("#000000", "#E69F00", "#56B4E9", "#009E73",

"#F0E442", "#0072B2", "#D55E00", "#CC79A7")An der Seite des Kapitels findest du den Link Quellcode anzeigen, über den du Zugang zum gesamten R-Code dieses Kapitels erhältst.

44.3 Daten

Auch brauchen wir hier in diesem Kapitel einfache Datensätze an denen wir eine einfaktorielle und eine zweifaktorielle Analyse nachvollziehen können. Ich habe dir in einem Abschnitt noch ein paar Fallbeispiele in {emmeans} mitgebracht, die dann einen stärkeren agrarwissenschaftlichen Bezug haben. Für den Anfang reichen aber die beiden Beispiele für das Verständnis dieses Kapitels vollkommen aus. Die Visualisierung der Datensätze schauen wir uns dann in dem Abschnitt zur Abschätzung der Varianzhonogenität und Varianzheterogenität nochmal näher an.

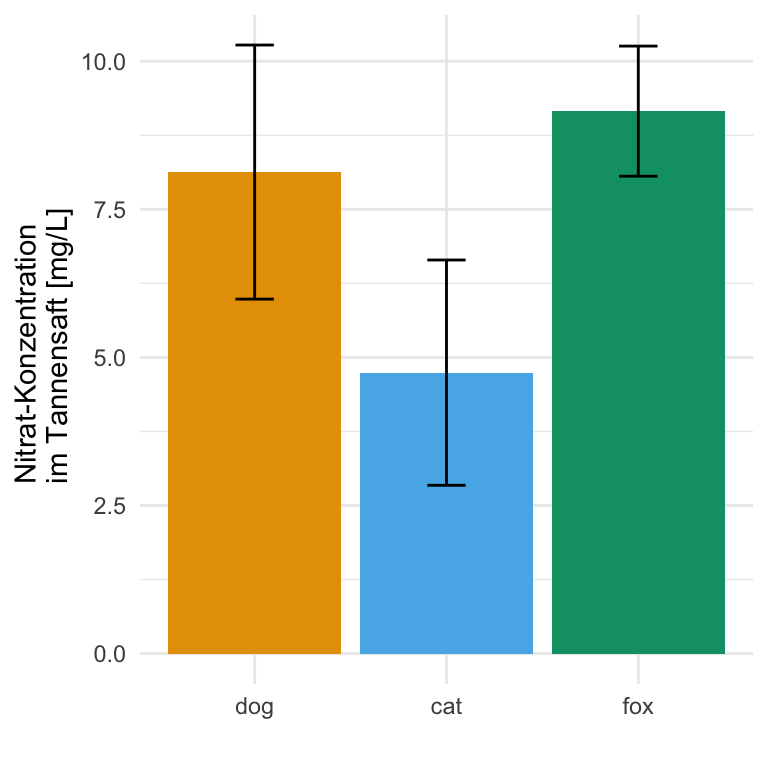

Der erste Datenstaz besteht aus der Sprungweite in [cm] von verschiedenen Tierarten. Dabei ist dann die Sprungllänge unser Messwert \(y\) oder Outcome. Unsere Behandlung sind dann die drei Tierarten Hund, Katze und Fuchs. Wir fragen uns also, die verschiedenen Floharten unterschiedlich weit springen. Ich habe dir einmal die Daten in das Objekt fac1_tbl geladen.

R Code [zeigen / verbergen]

fac1_tbl <- read_xlsx("data/flea_dog_cat_fox.xlsx") |>

select(animal, jump_length) |>

mutate(animal = as_factor(animal))Dann schauen wir uns die Daten einmal in der folgenden Tabelle als Auszug einmal an. Wichtig ist hier nochmal, dass du eben einen Faktor animal mit drei Leveln also Gruppen vorliegen hast. Wir wolen jetzt die drei Tierarten hinsichtlich ihrer Sprungweite in [cm] miteinander vergleichen. Weil wir jetzt mehr als zwei Gruppen vorliegen haben, sprechen wir von einem multiplen Vergleich.

animal vorliegen haben.

| animal | jump_length |

|---|---|

| dog | 5.7 |

| dog | 8.9 |

| dog | 11.8 |

| … | … |

| fox | 10.6 |

| fox | 8.6 |

| fox | 10.3 |

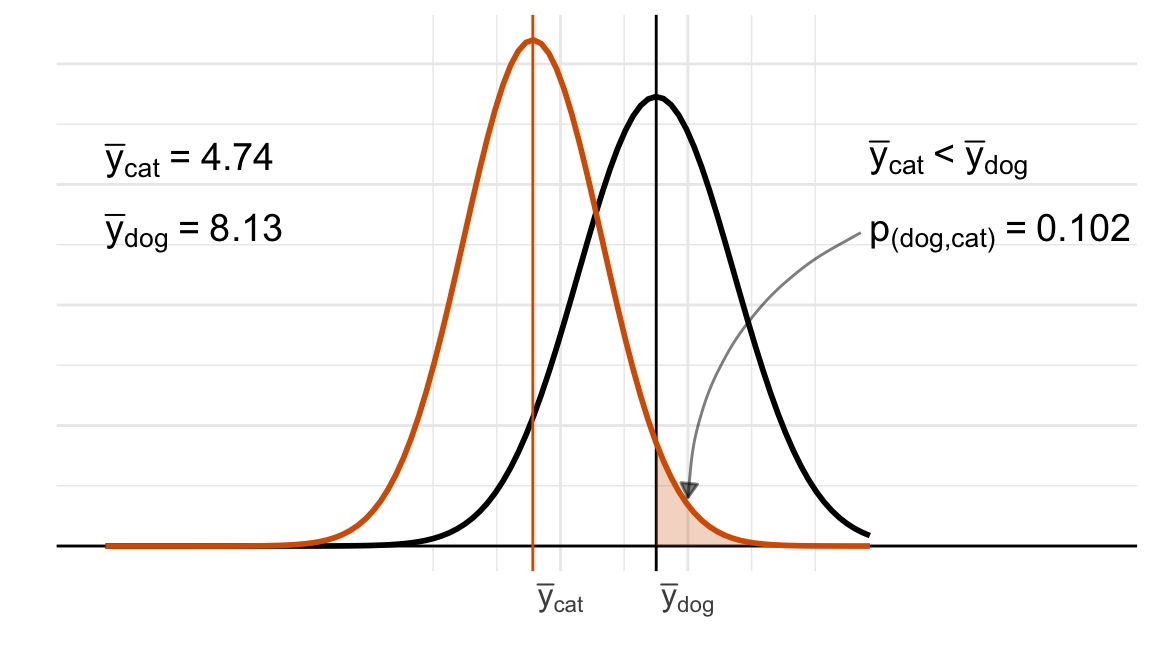

Wir vergleichen natürlich nicht die Sprungweiten in [cm] direkt mitteinandern sondern rechnen natürlich vorher die deskriptive Statistiken wie Mittelwert und Standardabweichung aus. Für die Berechnung des Standardfehlers nutzen wir die Funktion standard_error() aus dem R Paket {parameters}. Am Ende vergleichen wir die mittleren Sprungweiten der Hunde-, Katzen-, und Fuchsflöhe miteinander. Wir können anhand der Mittelwerte schon Tendenzen in den Gruppen sehen.

| animal | Mittelwert | Standardabweichung | SE |

|---|---|---|---|

| dog | 8.13 | 2.14 | 0.81 |

| cat | 4.74 | 1.90 | 0.72 |

| fox | 9.16 | 1.10 | 0.42 |

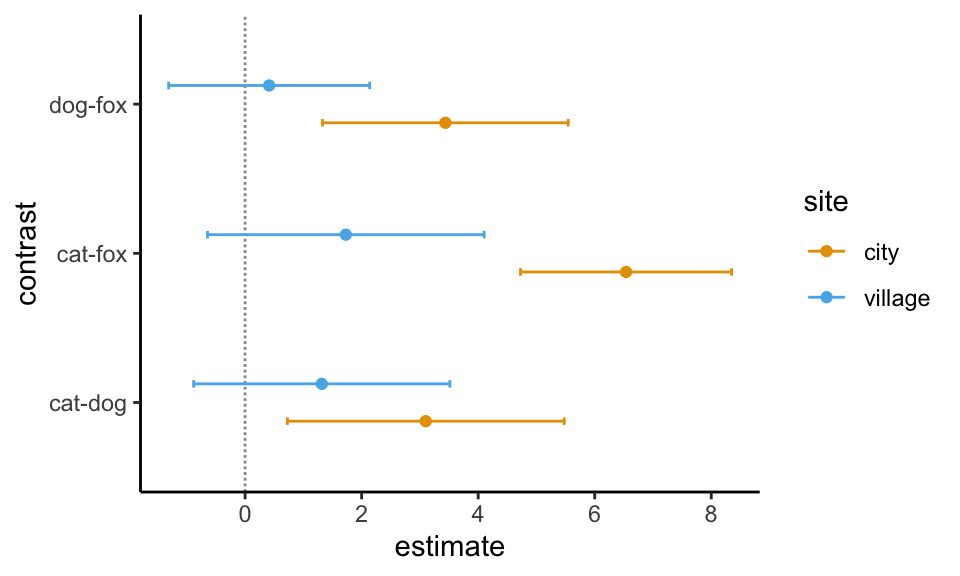

Neben dem einfaktoriellen Datensatz wollen wir uns noch den häufigeren Fall mit zwei Faktoren anschauen. Wir haben also nicht nur die drei Floharten vorliegen und wollen wissen ob diese unterschiedlich weit springen. Darüber hinaus haben wir noch einen zweiten Faktor gewählt. Wir haben die Sprungweiten der Hunde-, Katzen- und Fuchsflöhe nämlich an zwei Messorten, der Stadt und dem Dorf, gemessen. Dadurch haben wir jetzt den Faktor animal und den Faktor site vorliegen. Wiederum fragen wir usn, ob sich die Sprungweite in [cm] der drei Floharten in den beiden Messorten unterscheidet. Im Folgenden lade ich einmal den Datensatz in das Objekt fac2_tbl.

R Code [zeigen / verbergen]

fac2_tbl <- read_xlsx("data/flea_dog_cat_fox_site.xlsx") |>

select(animal, site, jump_length) |>

filter(site %in% c("city", "village")) |>

mutate(animal = as_factor(animal),

site = as_factor(site))Betrachten wir als erstes einen Auszug aus der Datentabelle. Wir haben hier als Messwert oder Outcome \(y\) die Sprungweite jump_length vorliegen. Als ersten Faktor die Variable animal und als zweiten Faktor die Variable site festgelegt.

animal und einen zweiten Faktor mit site vorliegen haben.

| animal | site | jump_length |

|---|---|---|

| cat | city | 12.04 |

| cat | city | 11.98 |

| cat | city | 16.1 |

| … | … | … |

| fox | village | 16.96 |

| fox | village | 13.38 |

| fox | village | 18.38 |

Auch hier schauen wir uns einmal die deskritive Zusammenfassung der Daten an. Hier musst du natürlich beachten welchen Faktor du in welchem verschaltest hast. Klingt jetzt erstmal sperrig, aber es wird vermutlich am Beispiel klarer. Wir haben ja an jedem Messort alle drei Tierarten gemessen. Daher wollen wir natürlich für jeden Messort die Zusammenfassung der drei Tierarten haben. Du kannst das auch andersherum gruppieren, aber für mich macht es sorum mehr Sinn. Für die Berechnung des Standardfehlers nutzen wir die Funktion standard_error() aus dem R Paket {parameters}. Wie du siehst, sind die Mittelwerte unterschiedlich, was auf einen Unterschied zwischen den Floharten im Bezug auf die Sprungweite hindeutet.

| animal | site | Mittelwert | Standardabweichung | SE |

|---|---|---|---|---|

| cat | city | 13.58 | 1.88 | 0.59 |

| cat | village | 15.25 | 2.35 | 0.74 |

| dog | city | 16.68 | 2.26 | 0.71 |

| dog | village | 16.56 | 1.21 | 0.38 |

| fox | city | 20.12 | 1.15 | 0.37 |

| fox | village | 16.98 | 1.73 | 0.55 |

44.4 Modell

Beginnen wir mit der Frage, was ein Modell ist. Ein Modell beschreibt, wie du deine Daten auswerten willst. Zuerst einmal beschreibt es in der formula-Schreibweise, welche Spalten du aus deinem Datensatz auswerten willst. Du musst den Funktionen in R ja mitteilen welche Variablen du analysieren möchtest. In dem nachfolgenden Abschnitt schauen wir uns einmal den Messwert \(y\) näher an und entscheiden dann noch, ob wir in den Gruppen \(x\) eine Varianzhomogenität vorliegen haben oder eher eine Varianzheterogenität finden.

44.4.1 Faktorielle Analyse

Beginnen wir also mit der Festlegung welche Art der Analyse wir rechnen wollen. Wir schauen uns jetzt einmal das einfaktorielle sowie das zweifaktorielle Modell näher an. Du könntest auch mehr als zwei Faktoren auswerten wollen, aber dann musst du einmal in ein anderes Kapitel wechseln. Wir beginnen hier mit dem einfacheren Fall oder auch den häufigsten. Zurst einmal haben wir ein faktorielles Modell vorliegen. Hier einmal die generelle Form mit belieb vielen Faktoren \(f\).

\[ y \sim f_1 + f_2 + ... + f_p + f_1 \times f_2 + ... + f_1 \times f_2 \times f_3 \]

mit

- \(y\) gleich dem Messwert oder Outcome

- \(f_1 + f_2 + ... + f_p\) gleich experimenteller Faktoren

- \(f_1 \times f_2\) gleich einem beispielhaften Interaktionsterm erster Ordnung

- \(f_1 \times f_2 \times f_3\) gleich einem beispielhaften Interaktionsterm zweiter Ordnung

Zusätzlich können noch Interaktionsterme höherer Ordnungen entstehen, aber hier wird es extrem schwierig diese Interaktionsterme dann auch zu interpretieren. Wir werden uns aber in diesem Kapitel auf ein einfaktorielles sowie zweifaktorielles Modell beschränken. Wenn du theoretisch das zweifaktorielle Modell anwenden kannst, dann kannst auch mit mehr Faktoren einen Post-hoc Test rechnen.

Einfaktorielles Modell

Beginnen wir mit dem einfaktoriellen Modell (eng. one-way design). In einem einfaktoriellen Modell haben wir einen Messwert \(y\) sowie einen Faktor mit beliebig vielen Leveln vorliegen. Dabei beschreiben die Level dann die einzelnen Gruppen. In unserem Fall hier haben wir es mit multiplen Vergleichen zu tun, so dass der Faktor natürlich mehr als zwei Level hat.

\[ y \sim f_1 \]

mit

- \(y\) gleich dem Messwert oder Outcome, wie die Sprungweite in [cm] als

jump_length. - \(f_1\) gleich der Behandlung als Faktor mit mehr als zwei Gruppen, wie die Tierart als

animal.

Wir würden dann folgende Schreibweise in R in einem Modell nutzen.

R Code [zeigen / verbergen]

as.formula(jump_length ~ animal)jump_length ~ animalZweifaktorielles Modell

Weit aus häufiger kommt das zweifaktorielle Modell (eng. two-way design) in den Agarwissenschaften vor. Wir haben hier nicht nur den Behandlungsfaktor \(f_1\) sondern eben noch einen zweiten Faktor \(f_2\) vorliegen. Was der zweite Faktor beschreibt, kann von Fragestellung zu Fragestellung sehr unterschiedlich sein. Wenn wir zwei Faktoren vorliegen haben, dann können wir auch die Interaktion zwischen den beiden Faktoren modelliere. Damit wollen wir die Frage beantworten, ob sich jede Faktorkombination gleich verhält oder ob es Unterschiede bei gewissen Faktorkombination gibt. Vielleicht verhalten sich ja Fuchsflöhe in der Stadt ganz anders als im Dorf im Vergleich zu Hunde-, und Katzenflöhen.

\[ y \sim f_1 + f_2 + f_1 \times f_2 \]

mit

- \(y\) gleich dem Messwert oder Outcome, wie die Sprungweite in [cm] als

jump_length. - \(f_1\) gleich der Behandlung als ersten Faktor mit mehr als zwei Gruppen, wie die Tierart als

animal. - \(f_2\) gleich dem zweiten Faktor, wie der Messort als

site. - \(f_1 \times f_2\) gleich dem Interaktionsterm zwischen den beiden Faktoren Tierart und Messort.

Wir würden dann folgende Schreibweise in R in einem Modell nutzen.

R Code [zeigen / verbergen]

as.formula(jump_length ~ animal + site + animal:site)jump_length ~ animal + site + animal:siteMehrfaktorielles Modell

Am Ende können wir dann noch den Fall haben, dass wir noch mehr Faktoren \(z\) in unserem Modell berücksichtigen wollen. Hier wird es dann komplizierter. Wichtig ist hier, dass du meistens auch zwei Faktoren hast, die dich am meisten interessieren und deren Interaktion du berücksichtigen willst. Ich mehr Interaktionen du rechnen willst desto mehr Fallzahl brauchst du, so dass hier meisten nur eine oder zwei Interaktionen funktionieren.

\[ y \sim f_1 + f_2 + f_1 \times f_2 + z_1 + \cdots + z_p \]

mit

- \(y\) gleich dem Messwert oder Outcome, wie die Sprungweite in [cm] als

jump_length. - \(f_1\) gleich der Behandlung als ersten Faktor mit mehr als zwei Gruppen, wie die Tierart als

animal. - \(f_2\) gleich dem zweiten Faktor, wie der Messort als

site. - \(f_1 \times f_2\) gleich dem Interaktionsterm zwischen den beiden Faktoren Tierart und Messort.

- \(z_1 + \cdots + z_p\) als weitere experimentelle Faktoren der Umwelt, Zeit oder anderer Einwirkung auf den Messwert sowie einzelene Messungen von Beobachtungen.

Wir würden dann folgende Schreibweise in R in einem Modell nutzen. Hier habe ich noch beispielhaft die beiden Faktoren Jahreszeit season und Fütterungszustand feeding ergänzt.

R Code [zeigen / verbergen]

as.formula(jump_length ~ animal + site + animal:site + season + feeding)jump_length ~ animal + site + animal:site + season + feedingWenn du ein komplexes, mehrfaktorielles Modell auswerten willst, dann schaue dir den Abschnitt zu Multiple Gruppenvergleiche für gemischte Modelle in dem entsprechenden Kapitel zu linearen gemischten Modellen an.

Ein weitere Möglichkeit ist, dass du einfach über den Faktoren \(z_1 + \cdots + z_p\) mittelst. Du schaust dir also weiterhin nur die beiden Hauptfaktoren \(f_1\) und \(f_2\) an und mittelst für jede Faktorkombination von \(f_1\) und \(f_2\) die Werte für die anderen Faktoren \(z_1 + \cdots + z_p\). Hier verlierst du dann zwar einiges an Informationen, aber dies wird häufig für die einzelnen Pflanzenmessungen je Parzelle gemacht. Du mittelst alle Pflanzen in einer Parzelle und schaust dir die einzelnen Pflanzen als Faktor gar nicht an.

44.4.2 Der Messwert \(y\)

In diesem Kapitel rechne ich alles einmal mit einem normalverteilten Messwert \(y\) durch. Daher ist die Sprungweite jump_length normalverteilt und ich kann daher als Modell die Funktion aov() nutzen. Das Kapitel würde zu groß, wenn ich alle möglichen Verteilungen und deren Funktionen in R hier zeigen würde.

Bevor wir mit dem multiplen Vergleich anfangen können, müssen wir uns Fragen welcher Verteilungsfamilie eigentlich unser Messwert \(y\) folgt. Je nachdem was du misst, musst du eine andere Verteilung modellieren und dann auch eine andere Funktion in R dafür nutzen. Welche statistische Modellierung für das \(y\) soll ich für meinen Gruppenvergleich wählen? Ich habe in den jeweiligen Kapiteln zu den statistischen Modellen die jeweiligen Schritte für die Gruppenvergleiche hinterlegt und beschrieben. Daher kannst du in den Kapiteln einmal schauen, wie dein Messwert dort ausgewertet wird. Du findest dort auch immer ein Beispiel mit entsprechenden Daten. Ich konzentriere mich hier in diesem Kapitel auf einen normalverteilten Messwert \(y\) mit der Sprungweite in [cm].

Normalverteilte Messwerte \(\boldsymbol{y}\)

Beispiel: Frischgewicht, Trockengewicht, Chlorophyllgehalt, Pflanzenhöhe

| freshmatter | drymatter | chlorophyll | height |

|---|---|---|---|

| 8.23 | 1.21 | 45.88 | 24.19 |

| 2.61 | 0.87 | 43.91 | 18.51 |

| 4.81 | 0.34 | 37.44 | 21.74 |

Ich rechne in diesem Kapitel alles einmal auf einem normalverteilten Messwert \(y\) mit der Sprungweite der Floharten durch. Wenn du mehr Informationen zum modellieren brauchst, dann schaue dir den Abschnitt zu Multiple Gruppenvergleiche für normalverteilte Daten gerne einmal an. Das ist eigentlich der Standardfall und vieles in diesem Kapitel dreht sich um normalverteilte Daten.

Die Modellierung in R führen wir im Allgemeinen mit der Funktion lm() durch. Da wir hier meistens erst eine ANOVA gerechnet haben um dann des Post-hoc Test zu rechnen nutze ich direkt die Modellierung mit der Funktion aov().

R Code [zeigen / verbergen]

lm(freshmatter ~ ...)

aov(freshmatter ~ ...)Die genaue Anwendung der Funktionen auf Beispielen findest du dann in den unteren Abschnitten oder aber in dem Kapitel zur Gaussian linearen Regression. Dort gehe ich dann auch näher auf das Modell und der Güte der Modellanpassung ein.

“Soll ich’s wirklich machen oder lass ich’s lieber sein? Jein…” — Fettes Brot, Jein

Häufig kommt jetzt die Frage, ob mein Messwert \(y\) wirklich normalverteilt ist und ich nicht den Messwert auf Normalverteilung testen sollte. Die kurze Antwort lautet nein, da du meistens zu wenig Beobachtungen pro Gruppe vorliegen hast. Die etwas längere liefert Kozak & Piepho (2018) mit dem Artikel What’s normal anyway? Residual plots are more telling than significance tests when checking ANOVA assumptions.

Poissonverteilte Messwerte \(\boldsymbol{y}\) bzw. Zähldaten

Beispiel: Anzahl Insekten, gekeimte Pflanzen, Schädlinge

| Anzahl Blätter | Gekeimte Samen | Anzahl Schädlinge | Verzweigungen |

|---|---|---|---|

| 8 | 18 | 45 | 4 |

| 2 | 10 | 43 | 5 |

| 4 | 22 | 37 | 4 |

Wenn du mehr über die Modellierung von Zähldaten und deren Auswertung wissen willst, dann schaue dir den Abschnitt zu Multiple Gruppenvergleiche für Zähldaten an. Die Modellierung führen wir mit der Funktion glm() durch.

R Code [zeigen / verbergen]

glm(freshmatter ~ ..., family = poission)Die genaue Anwendung der Funktionen auf Beispielen findest du dann in dem Kapitel zur Poisson Regression. Dort gehe ich dann auch näher auf das Modell und der Güte der Modellanpassung ein. Bei Zähldaten gibt es die eine oder andere Besonderheit beim Modellieren.

Ordinalverteilte Messwerte \(\boldsymbol{y}\) bzw. Noten

Beispiel: Bonitur von Rasen, Holstrunk, Bonitur von Wurzelwachstum, Zufriedenheit

| Bonitur von Rasen | Holstrunk | Bonitur von Wurzelwachstum | Zufriedenheit |

|---|---|---|---|

| 8 | 1 | 5 | 6 |

| 8 | 2 | 4 | 6 |

| 1 | 7 | 7 | 9 |

Wenn du Noten vorliegen hast, dann schaue dir den Abschnitt zu Multiple Gruppenvergleiche für Boniturdaten an. Es sei den du bist an der mittleren Note pro Gruppe interessiert und willst die mittleren Noten miteinander vergleichen. Dann kannst du auch ein Modell unter der Annahme einer Normalverteilung mit heterogenen Varianzen rechnen. Die Modellierung führen wir mit der Funktion clm() durch.

R Code [zeigen / verbergen]

clm(freshmatter ~ ...)Die genaue Anwendung der Funktionen auf Beispielen findest du in dem Kapitel zur Multinomiale / Ordinale Regression. Dort gehe ich dann auch näher auf das Modell und der Güte der Modellanpassung ein.

Binomialverteilte Messwerte \(\boldsymbol{y}\) bzw. Anteile

Beispiel: Infektionsstatus, Verstorben, Zielgewicht erreicht, Gekeimt

| Infektionsstatus | Verstorben | Zielgewicht erreicht | Gekeimt |

|---|---|---|---|

| 1 | 1 | 0 | 1 |

| 1 | 1 | 0 | 1 |

| 0 | 0 | 1 | 1 |

Wenn du nur einen Messwert mit der Ausprägung \(0/1\) oder \(ja/nein\) vorliegen hast, dann schaue dir den Abschnitt zu Multiple Gruppenvergleiche für Anteile an. Die Modellierung führen wir mit der Funktion glm() durch.

R Code [zeigen / verbergen]

glm(freshmatter ~ ..., family = binomial)Die genaue Anwendung der Funktionen auf Beispielen findest du dann in den unteren Abschnitten oder aber in dem Kapitel zur Logistische Regression. Dort gehe ich dann auch näher auf das Modell und der Güte der Modellanpassung ein.

Betaverteilte Messwerte \(\boldsymbol{y}\) bzw. Wahrscheinlichkeiten

Beispiel: Anteil infizierte Pflanzen, Jagderfolg, Auftreten Spezies, Erfolg/Misserfolg einer Anwendung

| Anteil infizierte Pflanzen | Jagderfolg | Auftreten Spezies | Erfolg/Misserfolg einer Anwendung |

|---|---|---|---|

| 0.34 | 0.22 | 0.19 | 0.67 |

| 0.29 | 0.78 | 0.11 | 0.71 |

| 0.31 | 0.77 | 0.27 | 0.82 |

Wenn du Prozente oder die Wahrscheinlichkeit für das Eintreten eines Ereignisses oder aber die Rate eines Erfolges an Misserfolgen gemessen hast, dann schaue dir den Abschnitt zu Multiple Gruppenvergleiche für Wahrscheinlichkeiten an. Die Modellierung führen wir mit der Funktion betareg() durch.

R Code [zeigen / verbergen]

betareg(freshmatter ~ ...)Die genaue Anwendung der Funktionen auf Beispielen findest du in dem Kapitel zur Beta Regression. Dort gehe ich dann auch näher auf das Modell und der Güte der Modellanpassung ein. Insbesondere hier gibt es dann einige unschöne Limitierungen wenn du zu nah an der Grenze von \([0,1]\) bist.

44.4.3 Die Faktoren \(f\)

Neben dem Messwert \(y\) müssen wir natürlich auch die Faktoren \(f\) mit dem ersten Faktor \(f_1\) und dem zweiten Faktor \(f_2\) berücksichtigen. Meistens haben wir hier aber einen Hauptfaktor mit den Behandlungsgruppen und dann noch einen zweiten Faktor der uns nicht so ganz interessiert. Das hängt aber von der Fragestellung ab, es kann auch zwei Hauptfaktoren geben. Im Folgenden betrachten wir jedenfalls jeden Faktor getrennt. Wir schauen jetzt einmal, ob sich die Fallzahlen in den Gruppen unterscheiden, wie wir mit der Varianz in den Gruppen umgehen und was schlussendlich als Fehlerbalken dargestellt werden soll.

Balanciert oder unbalanciert

Eine der ersten Fragen an die Gruppen ist, ob wir ein balanciertes Desgin vorliegen haben oder ein unbalanciertes Design. Im Falle eines balancierten Design sind die Fallzahlen in jeder Behandlungsgruppe gleich groß. Du solltest dein Experiment immer so planen, dass die Gruppen immer gleich groß sind. Das macht vieles einfacher. Manachmal kann es passieren, dass du eine Beobachtung verlierst oder aber eine Messung nicht klappt. Dann hast du ein unbalanciertes Design vorliegen. In einem unbalancierten Design ist die Fallzahl in allen Gruppe nicht gleich groß.

- Balanciertes Design

-

Alle Behandlungsgruppen \(1, 2, ..., p\) haben die gleiche Fallzahl \(n_g\) in den Behandlungsgruppen.

- Unbalanciertes Design

-

Die Behandlungsgruppen \(1, 2, ..., p\) haben unterschiedliche Fallzahlen \(n_1, n_2, ..., n_p\) in den Behandlungsgruppen.

Um es gleich vorwegzunehmen das R Paket {emmeans} wurde extra dafür gebaut mit balancierten und im Besonderen mit unbalancierten Daten umzugehen. Eine ANOVA kann prinzipiell auch mit unbalancierten Daten umgehen. Beim Tukey HSD Test und anderen älteren Implementierungen eines Post-hoc Test wird es dann schwieriger.

Wenn du unbedingt balancierte Daten ohne fehlende Werte brauchst, dann kannst du die fehlenden Werte in einer Gruppe durch den Mittelwert der jeweiligen Gruppe ersetzen. Das hat dann nicht so starke Auswirkungen, aber überfährt auch einen statistischen Engel.

Varianzhomogenität und Varianzheterogenität

Kommen wir nun zur Varianzhomogenität oder Varianzhterogenität in den Gruppen des Behandlunsgfaktors. Wir betrachten also meistens nur den wichtigen Faktor \(f_1\) und ignorieren ein wenig den zweiten Faktor. Prinzipiell kannst du natürlich auch den zweiten Faktor anschauen, aber dann werden es immer mehr Gruppen und Faktorkombinationen. Am Ende kommt dann sowieso heraus, dass über alle Gruppen hinweg keine homogenen Varianzen vorliegen. Wenn du mehr lesen willst so gibt es auf der Seite DSFAIR noch einen Artikel zu {emmeans} und der Frage Why are the StdErr all the same?

- Wann liegt vermutlich Varianzheterogenität in deinen experimentellen Faktoren \(f\) vor?

-

Es gibt so ein paar Daumenregeln, die dir helfen abzuschätzen, ob in deinen Gruppen Varianzheterogenität vorliegt. Um es kurz zu machen, vermutlich hast du mindestens leichte Varianzhterogenität in den Daten vorliegen.

- Du hat viele Behandlungsgruppen. Je mehr Gruppen du hast oder eben dann auch Faktorkombinationen, die du testen möchtest, desto wahrscheinlicher wird es, dass mindestens eine Gruppe eine unterschiedliche Varianz hat. Du hast Varianzheterogenität vorliegen.

- Du misst deine Gruppen über die Zeit. Je größer, schwerer oder allgemein höher ein Messwert wird, desto größer wird auch die Varianz. Schaust du dir deine Messwerte über die Zeit an hast du meistens Varianzheterogenität vorliegen.

- Deine Kontrolle ohne Behandlung verhält sich meistens nicht so, wie die Gruppen, die eine Behandlung erhalten haben. Wenn du nichts machst in deiner negativen Kontrolle, dann hast du meistens eine andere Streuung der Messwerte als unter einer Behandlung.

- Diene Behandlungen sind stark unterschiedlich. Wenn deine Behandlungen sich biologisch oder chemisch in der Wirkung unterscheiden, denn werden vermutlich deine Messwerte auch anders streuen. Hier spielt auch die Anwendung der Behandlung und deren Bereitstellung eine Rolle. Wenn was nicht gleich ist, dann wird es vermutlich nicht gleiche Messwerte erzeugen.

- Du hast wenig Fallzahl pro Gruppe oder Faktorkombination. Wenn du wenig Fallzahl in einer Gruppe hast, dann reicht schon eine (zufällige) Messabweichung und schon sind deine Varianzen heterogen.

Gut, jetzt wissen wir, dass du vermutlich Varianzheterogenität in deinen Daten vorliegen hast. Erstmal ist das kein so großes Problem.

- Tut Varianzheterogenität anstatt Varianzhomogenität weh?

-

Nein. Meistens ist die Varianzheterogenität nicht so ausgeprägt, dass du nicht auch eine ANOVA rechnen kannst. Über alle Gruppen hinweg wird dann zwar in einer ANOVA die Varianz gemittelt und es kann dann zu weniger signifikanten Ergebnissen führen, aber so schlimm ist es nicht. Im Post-hoc Test solltest du aber die Varianzheterogenität berücksichtigen, da du ja immer nur zwei Gruppen gleichzeitig betrachtest.

Wie immer kannst du alles natürlich auch statistisch Testen. Das ist dann bei der Varianzhomogenität nicht anders. Mehr dazu dann im Kapitel zum Pre-Test oder Vortest. Hier konzentriere ich mich auf die visuelle Überprüfung, die meistens in einem Setting mit niedriger Fallzahl in den Gruppen vollkommen ausreicht. Die Tests liefern meist eine falsche numerische Sicherheit, die so nicht stimmt.

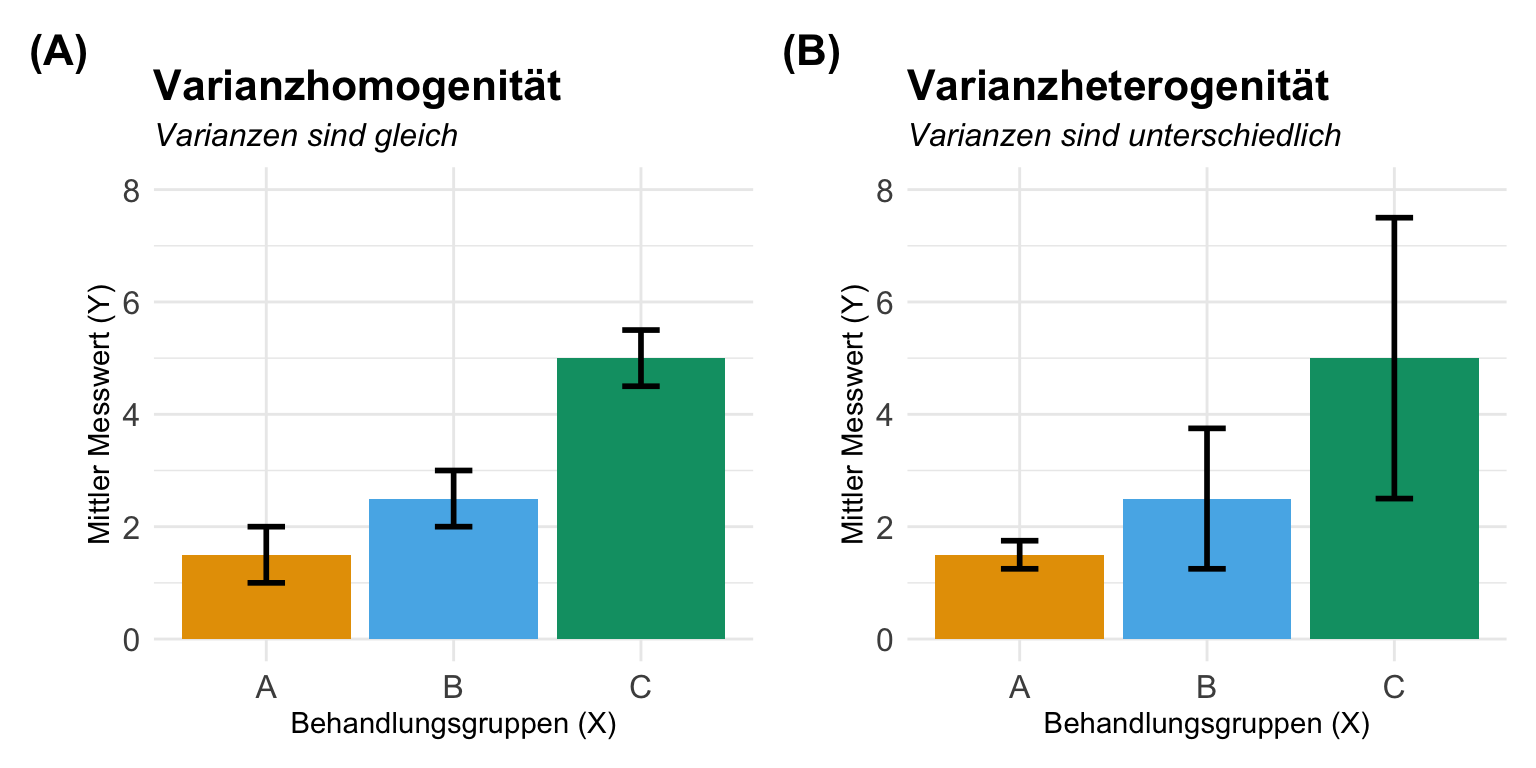

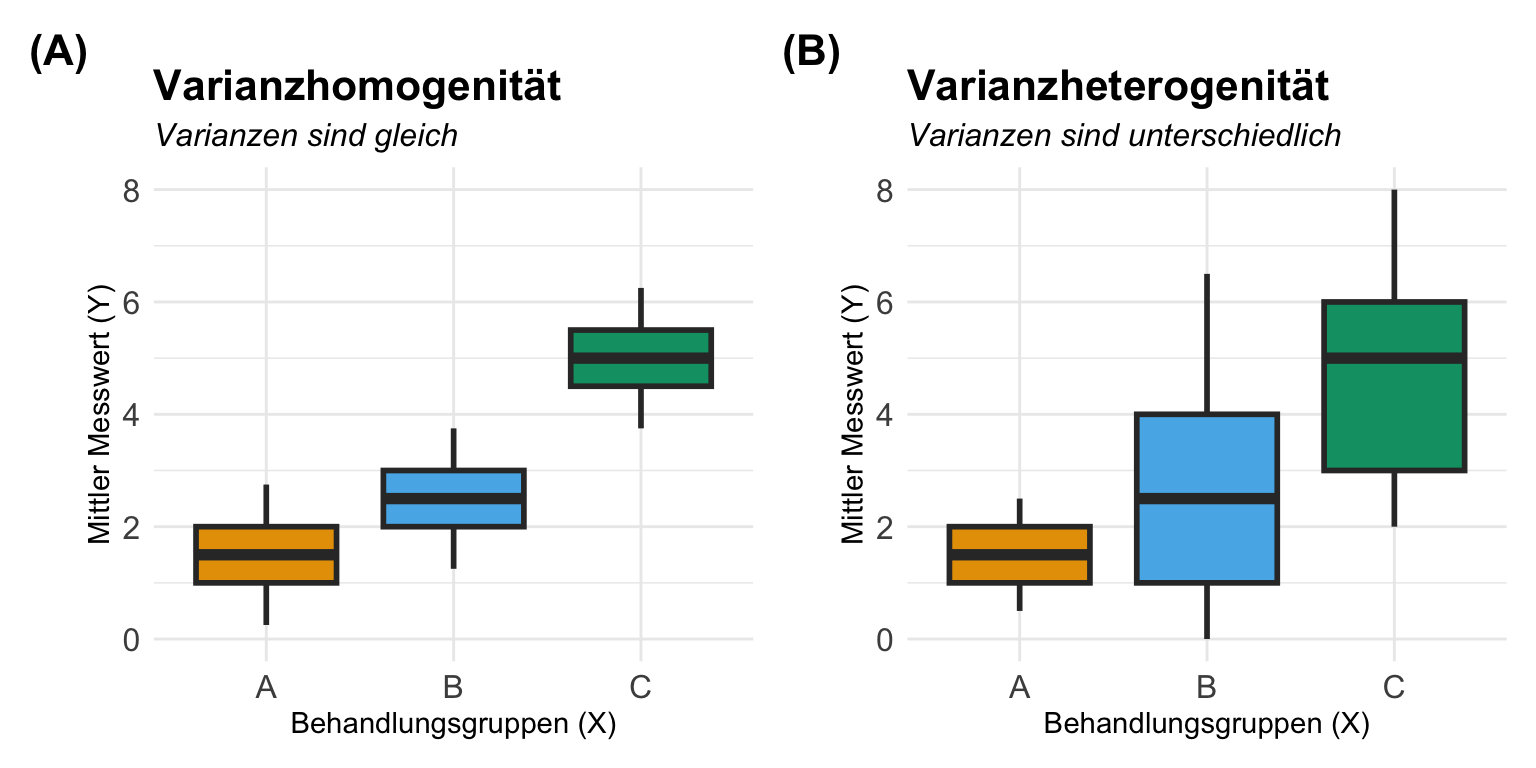

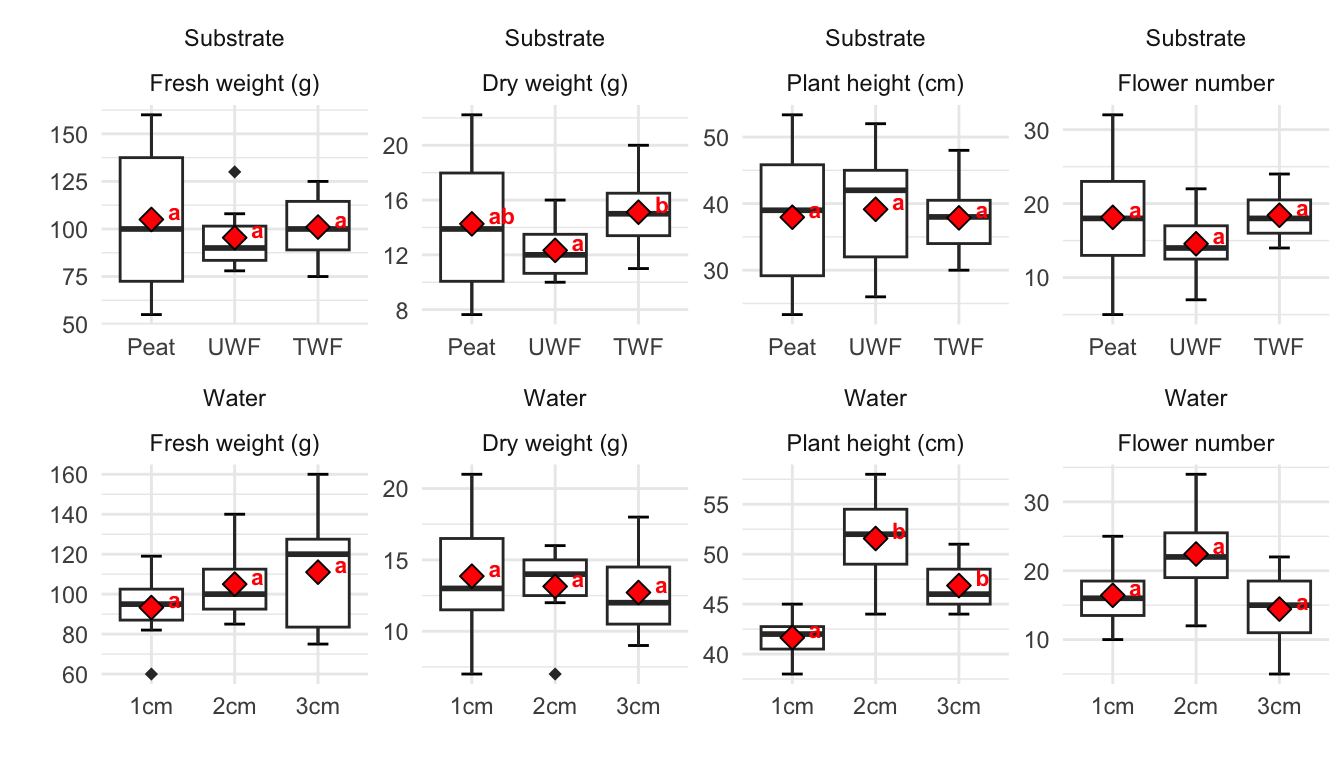

Hier einmal die theoretischen Abbilungen von drei Gruppen mit Varianzhomogenität und Varianzheterogenität. Hier wird schnell klar, dass du mit mehr Behandlungsgruppen kaum die Annahme für Varianzhomogenität aufrecht erhalten kannst. Insbesondere Kontrollen oder Standardbehandlungen haben große oder kleinere Varianzen als der Rest der Behandlungen. Manchaml hat man aber Glück und die Varianzen sind eher homogen.

Wir bauen wir usn jetzt die Barplots oder Säulendiagramme? Entweder direkt aus {ememans}, wie ich dir das weiter unten zum Compact letter display zeige oder eben als Wiederholung des Kapitels zur Visualisierung von Daten. Wir bauen uns also einmal den einfaktoriellen Barplot wie auch den zweifaktoriellen Barplot.

44.4.4 Einfaktorieller Barplot

Für den einfaktoriellen Barplot brauchen wir einmal den Mittelwert und die Standardabweichung der einzelne Floharten.

R Code [zeigen / verbergen]

stat_fac1_tbl <- fac1_tbl |>

group_by(animal) |>

summarise(mean = mean(jump_length),

sd = sd(jump_length))

stat_fac1_tbl# A tibble: 3 × 3

animal mean sd

<fct> <dbl> <dbl>

1 dog 8.13 2.14

2 cat 4.74 1.90

3 fox 9.16 1.10Dann können wir uns auch schon den Barplot mit {ggplot} erstellen. Später willst du dann noch das Compact letter display über den Balken als Mittelwerte ergänzen.

R Code [zeigen / verbergen]

ggplot(data = stat_fac1_tbl,

aes(x = animal, y = mean, fill = animal)) +

theme_minimal() +

geom_bar(stat = "identity") +

geom_errorbar(aes(ymin = mean-sd, ymax = mean+sd),

width = 0.2) +

labs(x = "Flohart", y = "Sprungweite in [cm]") +

theme(legend.position = "none") +

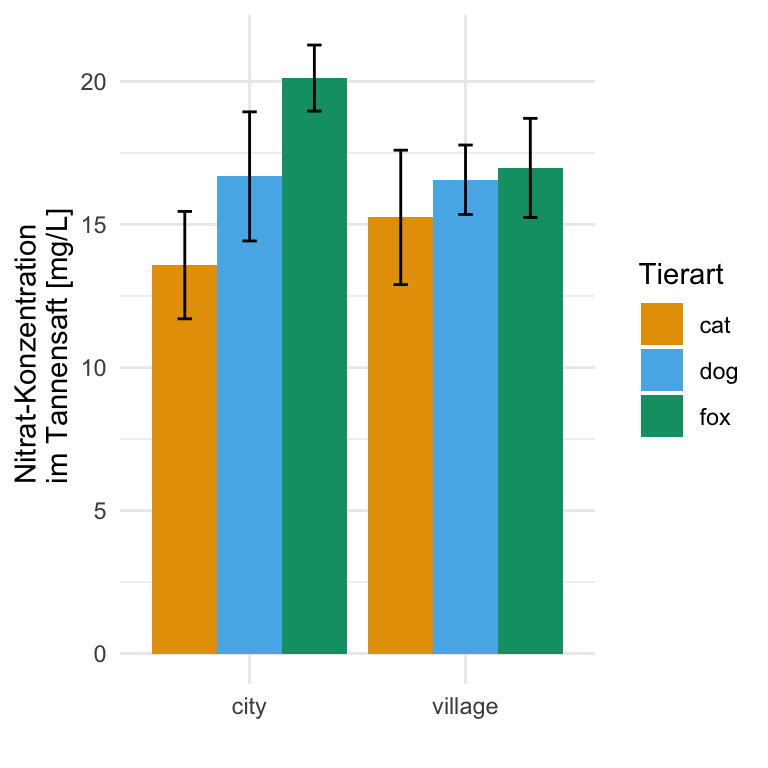

scale_fill_okabeito() 44.4.5 Zweifaktorieller Barplot

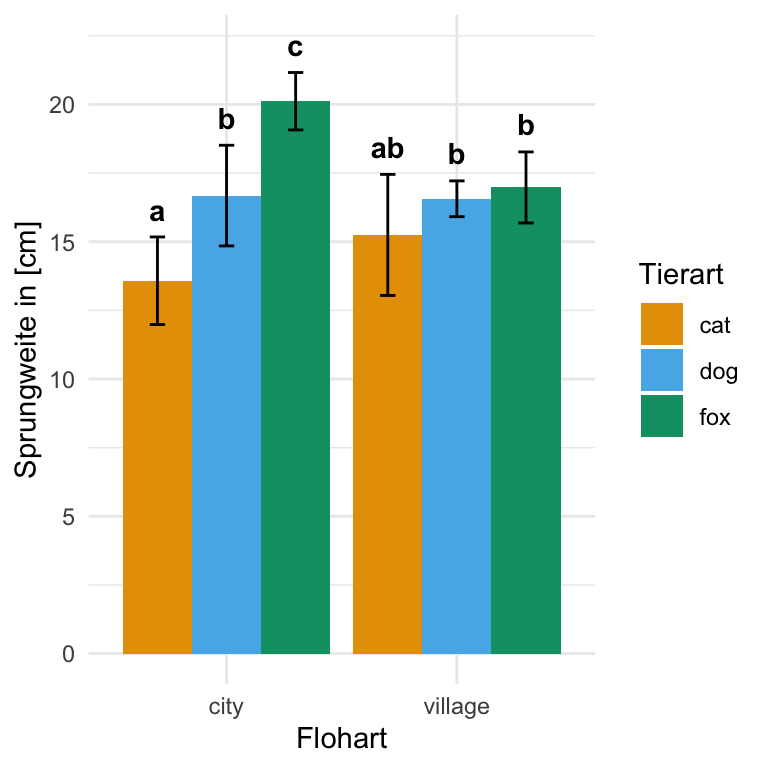

Für den zweifaktoriellen Barplot brauchen wir einmal den Mittelwert und die Standardabweichung der einzelne Floharten getrennt für die beiden Messorte. Das geht natürlich auch umgedreht, also die Messorte für die Floharten. Das kommt dann auf deine Fragestellung an.

R Code [zeigen / verbergen]

stat_fac2_tbl <- fac2_tbl |>

group_by(animal, site) |>

summarise(mean = mean(jump_length),

sd = sd(jump_length))

stat_fac2_tbl# A tibble: 6 × 4

# Groups: animal [3]

animal site mean sd

<fct> <fct> <dbl> <dbl>

1 cat city 13.6 1.88

2 cat village 15.2 2.35

3 dog city 16.7 2.26

4 dog village 16.6 1.21

5 fox city 20.1 1.15

6 fox village 17.0 1.73Und dann können wir auch schon den zweifaktoriellen Barplot in {ggplot} erstellen. Du musst schauen, was du auf die x-Achse legst und was du dann auf die Legende und daher mit fill gruppierst. Damit die Positionen passen, spiele ich hier noch mit der Funktion position_dodge() rum.

R Code [zeigen / verbergen]

ggplot(data = stat_fac2_tbl,

aes(x = site, y = mean, fill = animal)) +

theme_minimal() +

geom_bar(stat = "identity", width = 0.9,

position = position_dodge(0.9)) +

geom_errorbar(aes(ymin = mean-sd, ymax = mean+sd),

width = 0.2,

position = position_dodge(0.9)) +

labs(x = "Flohart", y = "Sprungweite in [cm]", fill = "Tierart") +

scale_fill_okabeito() 44.4.6 Einfaktorieller Boxplot

Das praktische bei den Boxplots ist, dass wir hier nichts mehr vorrechnen müssen, sondern direkt die Boxplots in {ggplot} erstellen können. Ich finde man sieht immer in einem Boxplot besser, ob die Streuung um den Median eher homogen oder eher heterogen ist. Gerne ergänze ich noch den Mittelwert mit der Funktion stat_summary().

R Code [zeigen / verbergen]

ggplot(data = fac1_tbl,

aes(x = animal, y = jump_length, fill = animal)) +

theme_minimal() +

geom_boxplot() +

stat_summary(fun.y = mean, geom = "point",

shape=23, size = 5, fill = "gray50") +

labs(x = "Flohart", y = "Sprungweite in [cm]") +

theme(legend.position = "none") +

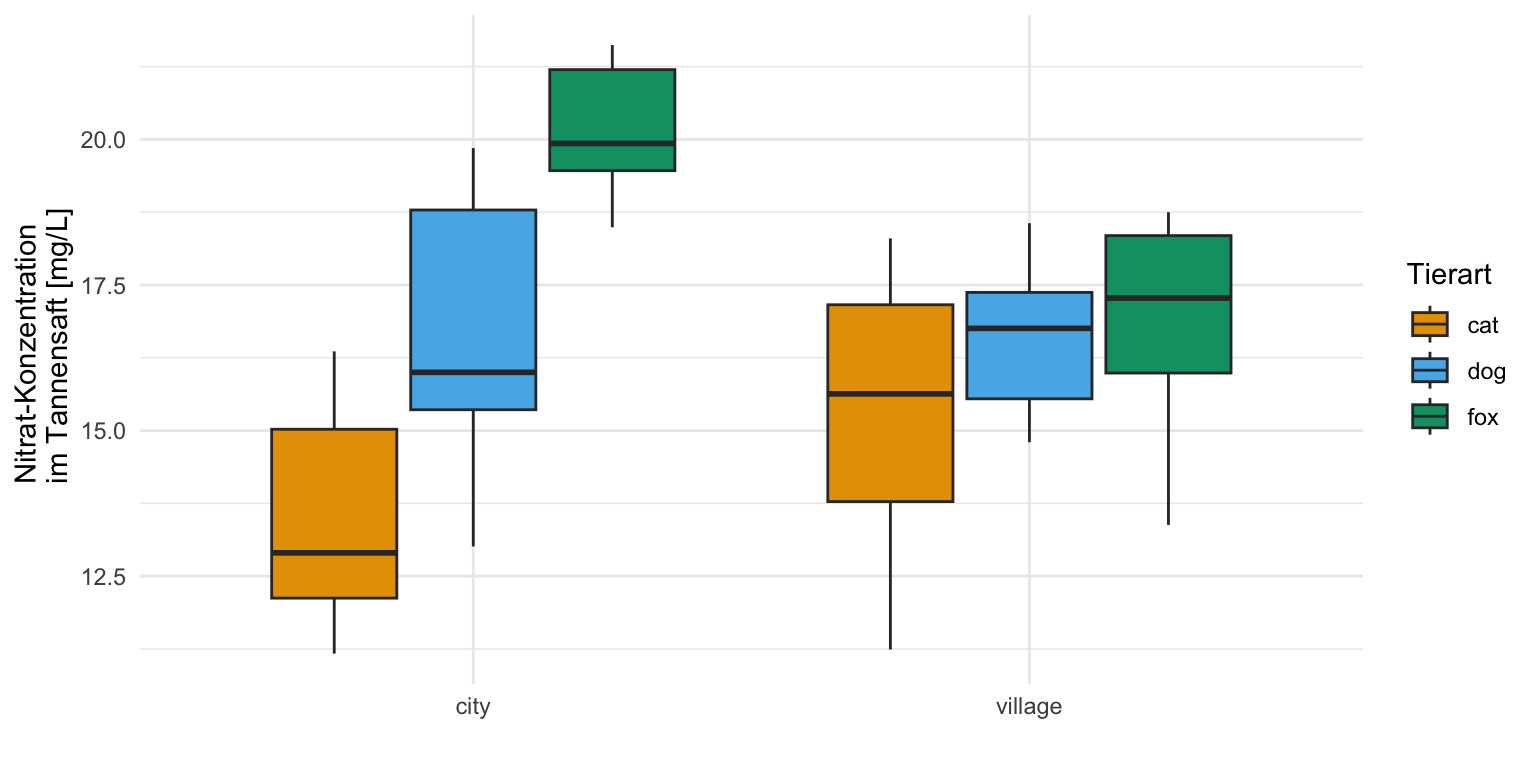

scale_fill_okabeito() 44.4.7 Zweifaktorieller Boxplot

Den zweifaktoriellen Boxplot erstellen wir für die einzelnen Floharten getrennt für die beiden Messorte. Du musst schauen, was du auf die x-Achse legst und was du dann auf die Legende und daher mit fill gruppierst. Gerne ergänze ich noch den Mittelwert mit der Funktion stat_summary(), muss hier aber schauen, dass ich nach dem Faktor animal gruppiere und dann noch mit der Funktion position_dodge() die richtige Position finde.

R Code [zeigen / verbergen]

ggplot(data = fac2_tbl,

aes(x = site, y = jump_length, fill = animal)) +

theme_minimal() +

geom_boxplot() +

stat_summary(fun.y = mean, geom = "point", aes(group = animal),

shape=23, size = 5, fill = "gray50",

position = position_dodge(0.75)) +

labs(x = "Flohart", y = "Sprungweite in [cm]", fill = "Tierart") +

scale_fill_okabeito() Dann habe ich mich doch noch hingesetzt und einmal für dich die Videos gemacht, wie du dann einen Barplot oder eben ein Säulendigramm in Excel erstellst. Daran kannst du natürlich auch überprüfen, ob die Varianzen homogen sind oder nicht. Das ganze macht dann nur als Video Sinn, denn sonst kannst du ja nicht nachvollziehen, was ich geklickt habe.

Hier also erstmal die einfachere Variante mit dem einfaktoriellen Barplot. Beginnen wollen wir wie immer mit der Berechnung der Mittelwerte und der Standardabweichung. Bitte nutze für die Standardabweichung die Funktion STABW.S() in Excel.

Und im Anschluss nochmal das Video für den zweifaktoriellen Barplot. Du hast jetzt eben nicht nur eine Behandlungsgruppe vorliegen sondern zwei Behandlungsgruppen. Dann musst du etwas mehr Arbeit reinstecken um alle Mittelwerte und Standardabweichungen zu berechnen. Bitte nutze auch hier für die Standardabweichung die Funktion STABW.S() in Excel.

Standardfehler oder Standardabweichung

Wenn wir uns jetzt entschieden haben, wie wir die Varianz modellieren wollen, stellt sich häufig die Frage, was wollen wir denn eigentlich in den Säulendiagrammen darstellen. Wie du in dem vorherigen Abschnitt ja schon gesehen hast, zeige ich nicht die Mittelwerte und die Varianz sondern eben die Mittelwerte und die Standardabweichung als Fehlerbalken. Dies ist auch die übliche Darstellung, wenn wir uns einen Barplot anschauen. Ein Barplot stellt den Mittelwert und die Standardabweichung als Fehlerbalken dar. Neben dem der Standardabweichung könntest du auch den Standardfehler als Fehlerbalken wählen. Hier nochmal die Formel für den Standardfehler und die Umstellung nach der Standardabweichung.

\[ SE = \cfrac{s}{\sqrt{n_g}};\; s = SE \cdot \sqrt{n_g} \]

mit

- \(SE\), dem Standardfehler der jeweiligen Gruppe.

- \(s\), der Standardabweichung der jeweiligen Gruppe.

- \(n_g\), der jeweiligen Gruppengröße.

Zu den Fehlerbalken liefert die Publikation Error bars in experimental biology von Cumming et al. (2007) nochmal einen Überblick über Fehlerbalken und welche Fehlerbalken man den nun nutzen sollte. Ich gebe hier nochmal eine kurze Übersicht.

- Der Standardfehler

-

Statistische Tests nutzen den Standardfehler um eine Aussage über die Signifikanz zu treffen. Der Standardfehler bleibt immer im Wertebereich des Messwertes.

- Die Standardabweichung

-

Barplots oder Säulendiagramme nutzen die Standardabweichung als Fehlerbalken um eine Aussage über die Streuung um den Mittelwert zu treffen. In bestimmten Fällen macht es Sinn dennoch den Standardfehler als Fehlerbalken zu nutzen, wenn dein Messwert im Wertebereich, wie eine Boniturnote, begrenzt ist.

Am Ende gibt dazu dann auch eine passend die Publikation von Kozak & Piepho (2020) mit dem Titel Analyzing designed experiments: Should we report standard deviations or standard errors of the mean or standard errors of the difference or what?

44.5 Der effektive Pfad mit {emmeans}

Das tolle an {emmeans} ist die Flexibilität. Du kannst sehr einfach viele Methoden in {emmeans} abdecken. Wenn du die Option für die Adjustierung auf tukey stellst, dann rechnest du faktisch einen besseren Tukey HSD Test. Wenn du dann noch in {emmeans} die Option mit der Varianzheterogenität wählst, rechnest du einen besseren Games Howell Test. Mehr dazu dann am Ende des Abschnitts, wie du die Ergebnisse präsentierst, da musst du dann gar nicht so viel schreiben.

Wenn du ein zweifaktorielles Design mit etwas wenig Fallzahl pro Gruppe vorliegen hast, dann ist {emmeans} die Antwort auf deine Herausforderungen. Darüber hinaus können wir auch sehr einfach Varianzheterogenität modellieren, die Adjustierung für multiple Vergleiche an und ausschalten sowie direkt das Compact letter display erhalten. Das Paket {emmeans} ist damit die effiktive Lösung für einen Gruppenvergleich in den Agarwissenschaften und darüber hinaus. Schauen wir uns also im Folgenden einmal das Paket näher an. Ich verzichte hier auf eine tiefere händische Berechnung sondern konzentriere mich auf die Anwendung der häufigsten Analysefälle.

Ich kann in diesem Abschnitt hier nicht alles erklären und im Detail durchgehen was {emmeans} alles kann. Hier gibt es noch ein Tutorium zu {emmeans} mit dem Titel Getting started with emmeans. Daneben gibt es auch noch die Einführung mit Theorie auf der Seite des R Paktes oder aber auch der Starter unter Quick start guide for emmeans. Wenn du eine allgemeine Übersicht der Themen in {emmeans} brauchst dann hilft dir der Index of vignette topics – emmeans package, Version 1.10.6. Beginnen wir aber wie immer mit den drängensten Fragen. Wie sieht es mit der Varianz, der Adjustierung und der möglichen Vergleiche sowie der Fallzahl in den einzelnen Behandlungsgruppen aus?

- Varianzhomogenität oder Varianzheterogenität

-

Wir können in

{emmeans}eine mögliche Varianzheterogenität modellieren, wenn wir das nicht tun, dann rechnet{emmeans}immer unter der Annahme von Varianzhomogenität. Wenn du nicht für die Varianzheterogenität adjustieren möchtest, dann rechnest du faktisch einen Tukey HSD Test, wenn die Fallzahl in den Gruppen gleich ist. Der Tukey HSD Test rechnet immer mit Varianzhomogenität. In allen Beispielen hier, werde ich aber für Varianzheterogenität adjustieren. Dazu nutze ich dann die Optionvcov. = sandwich::vcovHACimemmeans()Funktionsaufruf. In dem R Paket{sandwich}gibt es eine riesige Anzahl an möglichen Funktionen um für Varianzheterogenität zu adjustieren. Wir nutzen hier die AdjustierungvcovHAC, die in vielen Fällen vollkommen ausreichend ist. - Adjustierung für multiple Vergleiche

-

Das Paket

{emmeans}kann sehr einfach für die Adjustierung von multiplen Vergleichen angepasst werden um adjustierte p-Werte zu erhalten. In der Standardeinstellung nutzt{emmeans}die Quartile aus einem Tukey HSD Test und somit ist{emmeans}gar nicht so weit weg von dem Tukey HSD Test. Ich stelle aber meistens die Adjustierung auf Bonferroni mit der Optionadjust = "bonferroni", da diese Adjustierung etwas eingängiger ist. Das bleibt aber dir überlassen, ob du überhaupt eine Adustierung wählen willst. Mit der Optionadjust = "none"stellst du die Adjustierung für multiple Vergleiche aus. Du erhälst die rohen p-Werte, die manchmal auch nützlich sind. - Mögliche multiple Vergleiche

-

In den folgenden Beispielen rechne ich immer einen

all-pairVergleich. Ich werde also alle Gruppen mit allen anderen Gruppen vergleichen. Ob das jetzt wirklich immer Sinn macht sei dahingestellt. Du kannst abr auch alle Gruppen nur zu eienr Kontrolle vergleichen. Dann müssen wir die Funktioncontrast()anders aufbauen. Wir nutzen dann die Optionmethodsowierefum mitzuteilen welche Behandlungsgruppe die Kontrolle ist. Wir erhalten dann folgenden Funktionsaufrufcontrast(method = "trt.vs.ctrl", ref = "fox"). Die Hilfeseite contrast-methods gibt dir nochmal eine Übersicht was alles in{emmeans}möglich ist. Welche Kontrast dann neben demall-pairnoch passend ist hängt dann sehr von deiner Fragestellung ab. Hier kann ich dann keine allgemeine Aussage zu treffen. - Fallzahl in den einzelnen Behandlungsgruppen

-

Die Stärke von

{emmeans}ist, dass du dir keine Gedanken machen musst, wie die Fallzahlen in deinen einzelnen Behandlungsgruppen sind. Im Idealfall sind die Fallzahlen balanciert, also die hast in jeder Gruppe die gleiche Anzahl an Beobachtungen. Machmal klappt das aber nicht in einem Experiment und dir fehlen irgendow Beobachtungen, dann rechnet dir{emmeans}aber dennoch richtige statistische Maßzahlen aus. Das ist eine wunderbare Eigenschaft von{emmeans}. Wenn alles balanciert ist, dann ist alles super. Wenn du aber unbalancierte Daten hast, musst du dich nicht drum kümmern.

Die Stärke der Berücksichtigung von unbalancierten Gruppengrößen kommt von der Berechngn der marginal effects. Deshalb heißt das Paket ja auch {emmeans} für Estimated Marginal Means. Wenn du dich jetzt fragst, was sind denn diese marginal means dann gibt es darauf hier und jetzt keine kurze Antwort. Dafür verweise ich auf Heiss (2022) und das Onlinetutorium Marginalia: A guide to figuring out what the heck marginal effects, marginal slopes, average marginal effects, marginal effects at the mean, and all these other marginal things are. Heiss erklärt dort sehr schön die Zusammenhänge. Dazu dann noch der Verweis auf die Webseite Model to Meaning von Arel-Bundock et al. (2024) um nochmal tiefer in das Modellieren von Daten einzusteigen.

Wichtig ist aber, du musst marginal effects oder das Konzept dahinter nicht verstanden haben um das R Paket {emmeans} sinnvoll nutzen zu können. Ja, damit überfahren wir wieder einen statistischen Engel, aber so ist es manchmal, wenn wir hier Sachen auf die Straße bringen wollen. Also fangen wir hier jetzt einmal an die einfaktorielle und zweifaktorielle Analyse in {emmeans} zu rechnen und zu interpretieren.

Einfaktorielle Analyse

Beginnen wir mit der einfaktorielle Analyse in dem wir erstmal ein ANOVA Modell rechnen. Wir nehmen hier die Sprungweite in [cm] als unseren Messwert \(y\) und dann die Tierrasse \(f_1\) als Faktor in das Modell. Hier brauchen wir das ANOVA Modell nur zur Berechnung unserer statistischen Maßzahlen. Wir könnten die Interpreation also auch weglassen.

R Code [zeigen / verbergen]

fac1_aov <- aov(jump_length ~ animal, data = fac1_tbl)Ich nutze jetzt das ANOVA Modell gleich für den Aufruf der emmeans() Funktion, die uns die Mittelwerte und die Varianzen in den Gruppen berechnet. Ich wähle hier die Adjustierung für die Varianzheterogenität mit der Option vcov. als Standard. Eiegntlich rechne ich immer unter der Annahme der Varianzheterogenität, da ich nicht viel verliere aber viel falsch machen kann, wenn ich die Heterogenität nicht berücksichtige.

R Code [zeigen / verbergen]

emm_fac1_obj <- fac1_aov |>

emmeans(~ animal, vcov. = sandwich::vcovHAC)

emm_fac1_obj animal emmean SE df lower.CL upper.CL

dog 8.13 0.427 18 7.23 9.03

cat 4.74 0.810 18 3.04 6.44

fox 9.16 0.468 18 8.17 10.14

Confidence level used: 0.95 Wir erhalten also unser {emmeans} Objekt für unsere einfaktorielle Analyse. Darin ist eigentlich alles enthalten was wir jetzt brauchen. Die Mittelwerte der Gruppen sind da und auch die entsprechende Standardfehler der Gruppen. Wenn du die Standardabweichung zurückrechnen willst, dann musst du \(SE \cdot \sqrt{n_g}\) rechnen mit der Gruppengröße \(n_g =7\) in unserem Fall. Denn nun ist ja die Frage, was willst du haben? Ich zeige dir in den folgenden Tabs einmal wie du die p-Werte, das Comapct letter display und die 95% Konfidenzintervalle berechnest.

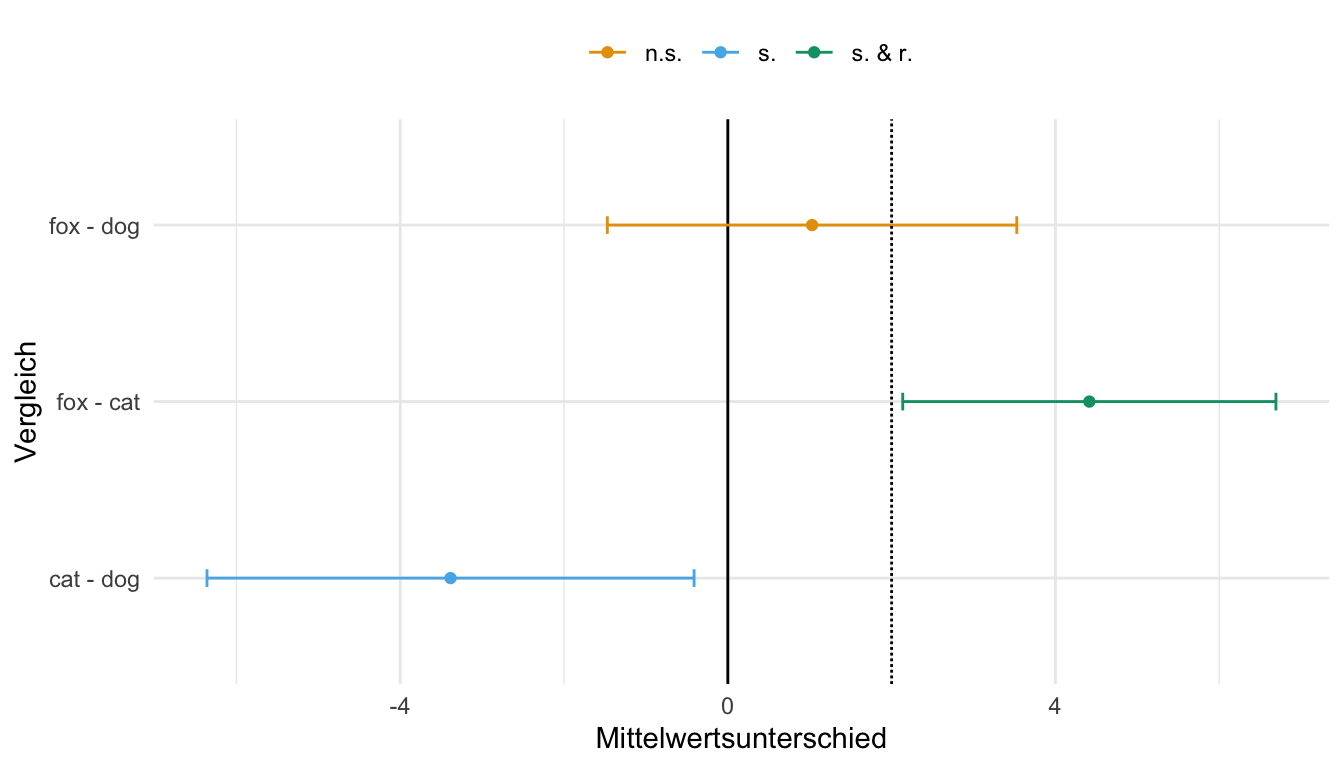

Beginnen wir mit den p-Werten, die jeder braucht. Wir können das emm_fac1_obj Objekt von oben jetzt einfach in die Funktion {contrast} stecken und dann definieren welche Vergleiche gerechnet werden sollen. In den agrarwissenschaftlichen Fächern ist des dann meist ein all-pair Vergleich. Wir vergleichen alles mit allem. Am Ende wähle ich onch die Adjustierung für multiple Vergleiche nach Bonferroni.

R Code [zeigen / verbergen]

emm_contrast_fac1_obj <- emm_fac1_obj |>

contrast(method = "pairwise", adjust = "bonferroni")

emm_contrast_fac1_obj contrast estimate SE df t.ratio p.value

dog - cat 3.39 0.904 18 3.744 0.0045

dog - fox -1.03 0.635 18 -1.620 0.3678

cat - fox -4.41 0.997 18 -4.425 0.0010

P value adjustment: bonferroni method for 3 tests Wir sehen, dass wir die Vergleiche für die einzelnen Floharten für die Sprunglänge erhalten. Der estimate ist der Effekt und damit die Differenz der Mittelwerte für die Sprungweite in [cm] für den jeweiligen Verleiche. Dann sehen wir in der Spalte SE noch, dass wir richtig für Varianzhterogenität adjustiert haben, da der Vergleich dog - cat nur \(2/3\) der Varianz der beiden anderen Vergleiche zeigt. Wir sehen dann am Ende, dass die Vergleiche dog - cat und cat - fox signifikant unterschiedlich sind. Die p-Werte liegen unter dem Signifikanzniveau von 5%.

Jetzt ist es manchmal so, dass du die Mittelwerte, die Differenz der Mittelwerte und die p-Werte haben möchtest. Das kannst du ganz einfach durch die Funktion pwpm() erreichen. Hier gibt es dann natürlich nur die paarweisen Vergleiche.

R Code [zeigen / verbergen]

emm_contrast_fac1_obj |>

pwpm(adjust = "bonferroni") dog - cat dog - fox cat - fox

dog - cat [ 3.39] 0.0010 0.0012

dog - fox 4.41 [-1.03] 0.0045

cat - fox 7.80 3.39 [-4.41]

Row and column labels: contrast

Upper triangle: P values adjust = "bonferroni"

Diagonal: [Estimates] (estimate)

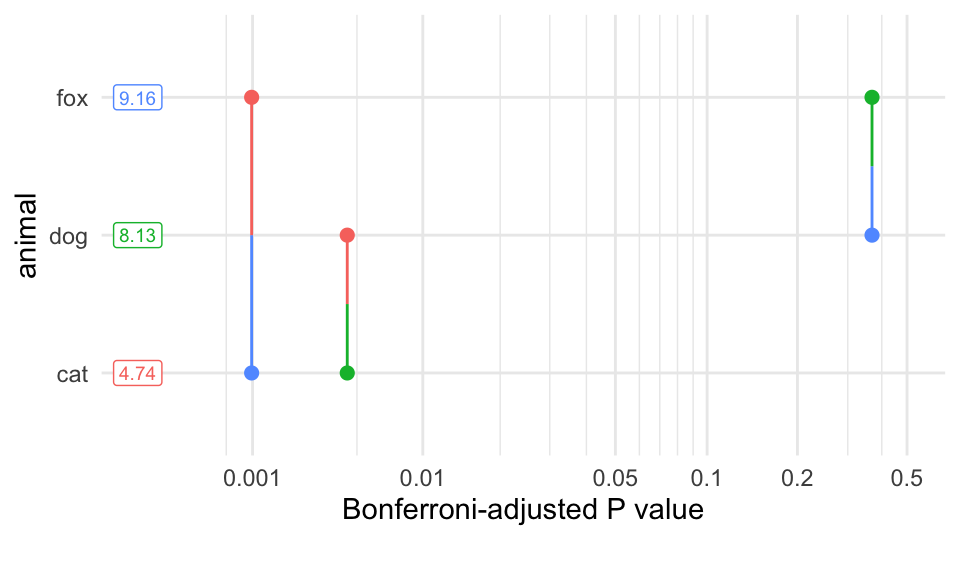

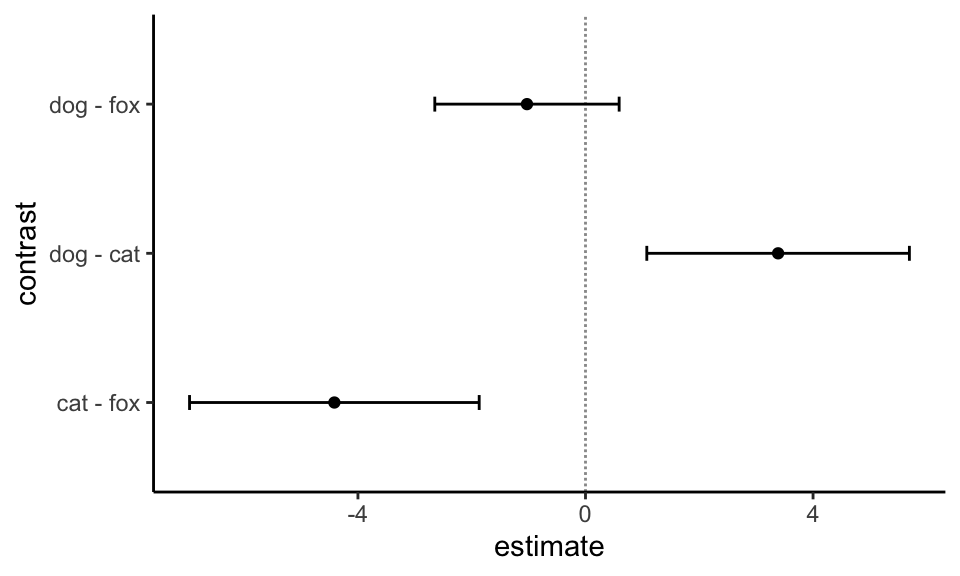

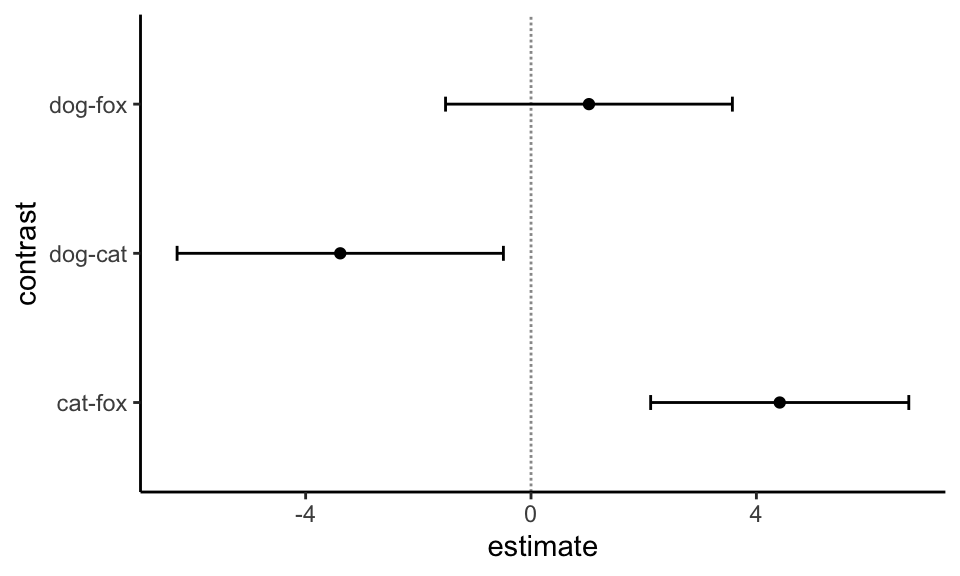

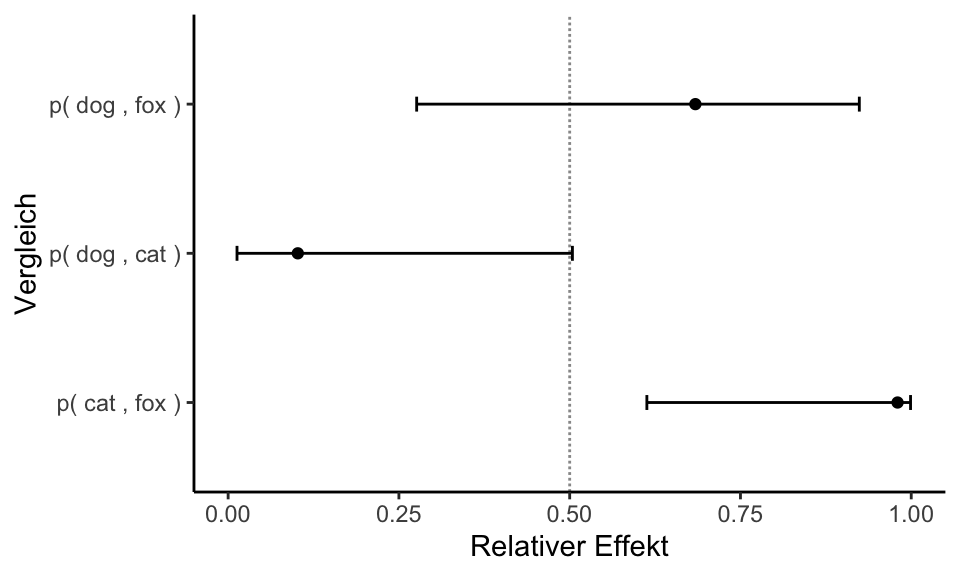

Lower triangle: Comparisons (estimate) earlier vs. laterAm Ende gibt es in {emmeans} noch den paarweisen p-Wert Plot, der die p-Werte einmal auf der x-Achse visualisiert. Da siehst du dann nochmal die Ordnung der Signifikanz über die gesamten Vergleiche. Die Abbildung finde ich persönlich manchmal interessant und manchmal wenig aussagekräftig. Kommt immer auf den Fall an.

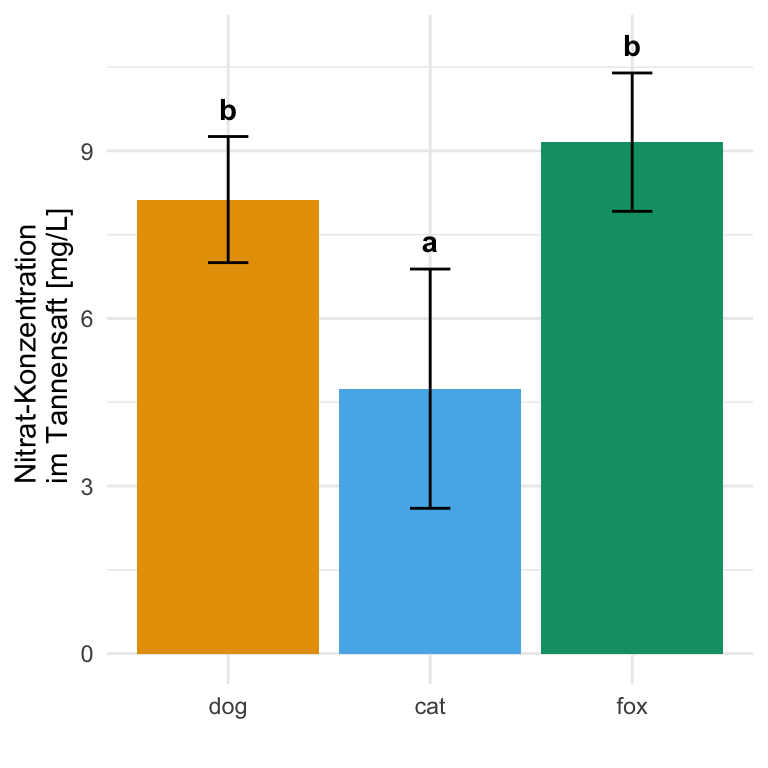

Nachdem wir in dem vorherigen Tab die p-Werte berechnet haben, könen wir jetzt einmal das Compact letter display erstellen. Hier hat das R Paket {emmeans} eine eigene Funktion mit cld(). Die Funktion nimmt das Objekt emm_fac1_obj und berechnet darauf das nach Bonferroni adjustierte Compact letter display.

R Code [zeigen / verbergen]

emm_cld_fac1_obj <- emm_fac1_obj |>

cld(Letters = letters, adjust = "bonferroni")

emm_cld_fac1_obj animal emmean SE df lower.CL upper.CL .group

cat 4.74 0.810 18 2.61 6.88 a

dog 8.13 0.427 18 7.00 9.25 b

fox 9.16 0.468 18 7.92 10.39 b

Confidence level used: 0.95

Conf-level adjustment: bonferroni method for 3 estimates

P value adjustment: bonferroni method for 3 tests

significance level used: alpha = 0.05

NOTE: If two or more means share the same grouping symbol,

then we cannot show them to be different.

But we also did not show them to be the same. Der größte Vorteil von {emmeans} ist jetzt, dass wir die Ausgabe des Compact letter displays direkt nutzen können um unseren Barplot zu zeichnen. Wir müssen nur einmal die Werte der Standardfehler mit der Wurzel der Gruppenfallzahl multiplizieren um auf die Standardabweichung zu kommen. Wenn du möchtest, kannst du auch den Standardfehler als Fehlerbalken nutzen, musst es nur Angeben. Da wir hier sieben Flöhe je Tierart gemessen haben, multiplizieren wir den Standardfehler mit der Wurzel von 7 um auf die Standardabweichung zu kommen. Dann entferne ich noch die Leerzeichen in der Spalte .group mit der Funktion str_trim() und ich kann den Barplot erstellen.

R Code [zeigen / verbergen]

emm_cld_fac1_obj |>

mutate(.group = str_trim(.group),

sd = SE * sqrt(7)) |>

ggplot(aes(x = animal, y = emmean, fill = animal)) +

theme_minimal() +

geom_bar(stat = "identity") +

geom_errorbar(aes(ymin = emmean-sd, ymax = emmean+sd),

width = 0.2) +

labs(x = "Flohart", y = "Sprungweite in [cm]") +

theme(legend.position = "none") +

scale_fill_okabeito() +

geom_text(aes(label = .group, y = emmean + sd + 0.5),

fontface = 2)Am Ende können wir dann auch aus den paarweisen Vergleichen die 95% Konfidenzintervalle berechnen. Hier nutzen wir dann die Funktion tidy() aus dem Paket {broom} um uns die 95% Konfidenzintervalle sauber wiedergeben zu lassen. Du kannst noch die Kontraste auf revpairwise stellen, wenn die Vergleiche umdrehen willst.

R Code [zeigen / verbergen]

emm_ci_fac1_obj <- emm_fac1_obj |>

contrast(method = "pairwise", adjust = "bonferroni") |>

tidy(conf.int = TRUE) |>

select(contrast, estimate, adj.p.value, conf.low, conf.high)

emm_ci_fac1_obj# A tibble: 3 × 5

contrast estimate adj.p.value conf.low conf.high

<chr> <dbl> <dbl> <dbl> <dbl>

1 dog - cat 3.39 0.00446 0.999 5.77

2 dog - fox -1.03 0.368 -2.70 0.647

3 cat - fox -4.41 0.000980 -7.05 -1.78 Die Stärke eines 95% Konfidenzintervalls ist ja die Signifikanz mit der Relevanz zu verbinden. Daher setze ich jetzt mal die Relevanzschwelle relevance_lvl auf \(>0.75cm\). Wenn also Floharten im Mittel sich mindestens um \(0.75cm\) unterscheiden, dann ist der Vergleich relevant. Das habe ich jetzt einfach so entschieden. Wir schauen hier dann auf größer/gleich, was auch mehr Sinn macht. Theoretisch kannst du auch in beide Richtungen die Relevanz definieren, aber in der Anwendung ist es eher selten, dass uns beide Richtungen interessieren.

R Code [zeigen / verbergen]

relevance_lvl <- 0.75In der folgenden Abbildung siehst du einmal die 95% Konfidenzintervalle für alle paarweisen Vergleiche. Ich habe am Anfang nochmal eine Regel mit case_when() erstellt, nachder ich dann die 95% Konfidenzintervall nach der Signifikanz und Relevanz einfärbe. Das ist ja die Stärke der 95% Konfidenzintervalle und dann sollte man die auch Nutzen. Wo du die Relevanzschwelle legst, ist dann dir selber überlassen. Das hängt von deiner wissenschaftlichen Fragestellung ab.

R Code [zeigen / verbergen]

emm_ci_fac1_obj |>

mutate(sig_lgl = case_when(between(rep(0, n()), conf.low, conf.high) ~ "n.s.",

relevance_lvl < conf.low ~ "s. & r.",

.default = "s.")) |>

ggplot(aes(contrast, y = estimate,

ymin = conf.low, ymax = conf.high, color = sig_lgl)) +

theme_minimal() +

geom_hline(yintercept = 0) +

geom_errorbar(width = 0.1) +

geom_hline(yintercept = relevance_lvl, linetype = "11",

color = "#009E73") +

geom_point() +

coord_flip() +

scale_color_okabeito() +

labs(x = "Vergleich", y = "Mittelwertsunterschied", color = "") +

theme(legend.position = "top")Zweifaktorielle Analyse

Nachdem wir uns die einfaktorielle Analyse angeschaut haben, kommen wir jetzt du der eigentlich interessanten Analyse. Wir wollen nämlich jetzt mal zwei Faktoren in einer zweifaktoriellen Analyse auswerten. Meistens haben wir nicht nur einen Faktor vorliegen sondern minestens zwei. Daher hier einmal das MOdell für unsere Sprungweite in [cm] für den Faktor animal mit den drei Floharten sowie dem Faktor site und den zwei Messorten Stadt und Dorf. Ich ahbe hier absichtlich den zweiten Faktor nur auf zwei Level begrenz, sonst werden die Ausgaben der Funktionen so groß. Später können deine Faktoren natürlich mehr Level oder Gruppen haben. Wir rechnen also einmal eine ANOVA um uns die statistsichen Maßzahlen als ein Modell wiedergeben zu lassen.

R Code [zeigen / verbergen]

fac2_aov <- aov(jump_length ~ animal + site + animal:site, data = fac2_tbl)Wenn wir zwei Faktoren vorliegen haben, dann müssen wir entscheiden, wie wir die zwei Faktoren auswerten wollen. Hierbei kommen wir um den Begriff nested (deu. verschachtelt, nicht gebräuchlich) herum. In der folgenden Abbildung habe ich das Konzept einmal dargestellt. In unserem Fall ist der Faktor animal in dem zweiten Faktor site genested. Alle Floharten wurden an allen Messorten gemessen.

flowchart LR

A(animal):::factor --- B(((nested))) --> C(site):::factor

classDef factor fill:#56B4E9,stroke:#333,stroke-width:0.75px

animal nested im Faktor site.

Damit gilt dann auch, dass jeder Messort alle Floharten enthält und die Floharten damit innerhalb eines Messortes randomsiert wurden. Ich habe dir das nochmal etwas anders dargestellt. Es ist wichtig sich den Zusammenhang klar zu machen, damit du später die Auswertung für deine wissenschaftliche Fragestellung richtig machst. Ich zeige dir hier jetzt einen Weg und du musst dann entscheiden, ob der bei dir auch so passt.

\[ \underbrace{\mbox{Messorte}}_{f_2} \xrightarrow[]{beinhaltet\; alle} \overbrace{\mbox{Floharten}}^{f_1} \]

Wir müssen uns jetzt entscheiden wie wir die beiden Faktoren \(f_1\) mit animal und \(f_2\) mit site auswerten wollen. Wir können den Faktor animal getrennt (eng. separate) für jedes Level des Faktors site vergleichen oder wir vergleichen alle Faktorkombinationen gemeinsam (eng. combined). Welcher Fakotr das bei dir dann in deiner Auswertung ist, kann ich natürlich nicht sagen. Aber meistens ist es dann klarer wenn du mit der Auswertung beginnst und dir die Ergebnisse versuchst zu interpretieren. Im Folgenden zeige ich dir einmal wie du die separierte und kombinierte Analyse in {emmeans} rechnest.

Wenn du den ersten Faktor animal separiert also getrennt für den zweiten Faktor site rechnen willst, dann nutzt du den Separator | um die getrennte Analyse zu rechnen. Du siehst, dass die Mittelwerte für die Floharten getrennt für die Messorte berechnet werden. Wiederum entscheide ich mich hier für die Adjustierung für die Varianzheterogenität.

R Code [zeigen / verbergen]

emm_fac2_separate_obj <- fac2_aov |>

emmeans(~ animal | site, vcov. = sandwich::vcovHAC)

emm_fac2_separate_objsite = city:

animal emmean SE df lower.CL upper.CL

cat 13.6 0.603 54 12.4 14.8

dog 16.7 0.693 54 15.3 18.1

fox 20.1 0.395 54 19.3 20.9

site = village:

animal emmean SE df lower.CL upper.CL

cat 15.2 0.834 54 13.6 16.9

dog 16.6 0.246 54 16.1 17.1

fox 17.0 0.489 54 16.0 18.0

Confidence level used: 0.95 Wenn du den ersten Faktor animal mit allen Kombinationen des zweiten Faktors site berechnen willst, dann nutzt du den Kombinator * um die kombinierte Analyse zu rechnen. Du siehst, dass die Mittelwerte für die Floharten für jeden Messort berechnet wird und die Ausgabe am Ende zusammengefasst wird. Wiederum entscheide ich mich hier für die Adjustierung für die Varianzheterogenität.

R Code [zeigen / verbergen]

emm_fac2_combinded_obj <- fac2_aov |>

emmeans(~ animal * site, vcov. = sandwich::vcovHAC)

emm_fac2_combinded_obj animal site emmean SE df lower.CL upper.CL

cat city 13.6 0.603 54 12.4 14.8

dog city 16.7 0.693 54 15.3 18.1

fox city 20.1 0.395 54 19.3 20.9

cat village 15.2 0.834 54 13.6 16.9

dog village 16.6 0.246 54 16.1 17.1

fox village 17.0 0.489 54 16.0 18.0

Confidence level used: 0.95 Wir erhalten also unser {emmeans} Objekt für unsere zweifaktorielle Analyse. Darin ist eigentlich alles enthalten was wir jetzt brauchen. Denn nun ist ja die Frage, was willst du haben? Ich zeige dir in den folgenden Tabs einmal wie du die p-Werte, das Comapct letter display und die 95% Konfidenzintervalle für die getrennte Analyse nach den zweiten Faktor berechnest. Deshalb erst überlegen, wie du die beiden Faktoren \(f_1\) und \(f_2\) auswerten willst. Je nachdem du dich dann entscheidest, kommen natürlich andere Egebnisse heraus.

Beginnen wir wieder die p-Werte für unseren Vergleich der Floharten für die mittleren Sprungweiten zu berechnen. Wir nutzen hierzu wieder die Funktion contrast() wie auch schon im einfaktoriellen Fall. Das ist jetzt auch so eine Stärke von {emmeans}, wenn wir das Modell hinkriegen, dann können wir auch mehr Faktoren beliebig ergänzen. Mir gefällt hier nicht die Reihenfolge in den Vergleichen. Statt cat - dog möchte ich lieber den Kontrast dog - cat. Daher wähle ich als Methode revpairwise und drehe damit einmal meine Vergleiche.

R Code [zeigen / verbergen]

emm_contrast_fac2_separate_obj <- emm_fac2_separate_obj |>

contrast(method = "revpairwise", adjust = "bonferroni")

emm_contrast_fac2_separate_objsite = city:

contrast estimate SE df t.ratio p.value

dog - cat 3.101 0.919 54 3.376 0.0041

fox - cat 6.538 0.721 54 9.070 <.0001

fox - dog 3.437 0.798 54 4.310 0.0002

site = village:

contrast estimate SE df t.ratio p.value

dog - cat 1.316 0.869 54 1.514 0.4076

fox - cat 1.729 0.967 54 1.789 0.2377

fox - dog 0.413 0.547 54 0.755 1.0000

P value adjustment: bonferroni method for 3 tests Jetzt erhalten wir für den zweiten Faktor site die Vergleiche der Sprungweiten der Hunde- und Katzenflöhe einmal wiedergegeben. Dabei sehen wir, dass sich die mittleren Sprungweiten signifikant in der Stadt unterscheiden, jedoch nicht auf dem Dorf. Die p-Werte in den Vergleichen in der Stadt sind alle unter dem Signifikanzniveau \(\alpha\) gleich 5%. Wir können hier also die Nullhypothese ablehnen, dass die Mitelwerte für den jeweiligen Vergleich gleich sind.

Jetzt können wir uns auch die Vergleiche als eine Matrix getrennt für den Faktor site anzeigen lassen. Hier ist es natürlich praktisch, dass wir gleich die Mittelwerte sowie die mittleren Differenzen als auch die p-Werte in einer Ausgabe vorliegen haben.

R Code [zeigen / verbergen]

emm_contrast_fac2_separate_obj |>

pwpm(adjust = "bonferroni")

site = city

dog - cat fox - cat fox - dog

dog - cat [3.10] 0.0002 1.0000

fox - cat -3.437 [6.54] 0.0041

fox - dog -0.336 3.101 [3.44]

site = village

dog - cat fox - cat fox - dog

dog - cat [1.316] 1.0000 1.0000

fox - cat -0.413 [1.729] 0.4076

fox - dog 0.903 1.316 [0.413]

Row and column labels: contrast

Upper triangle: P values adjust = "bonferroni"

Diagonal: [Estimates] (estimate)

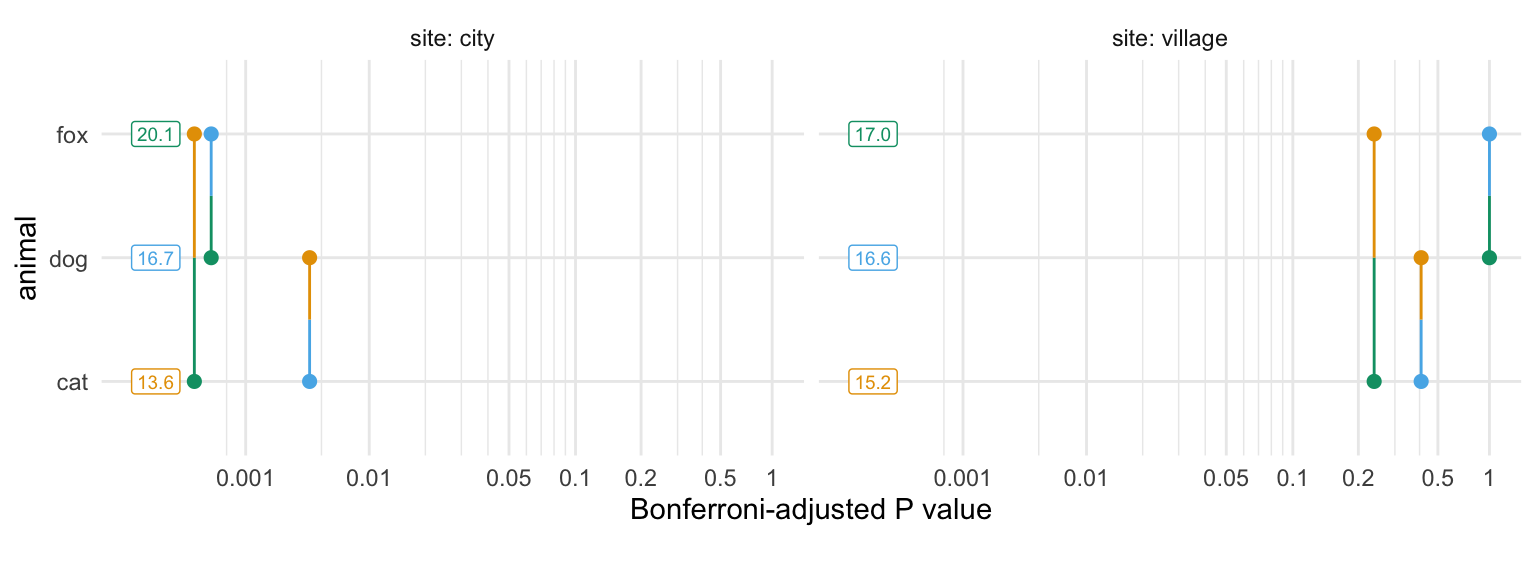

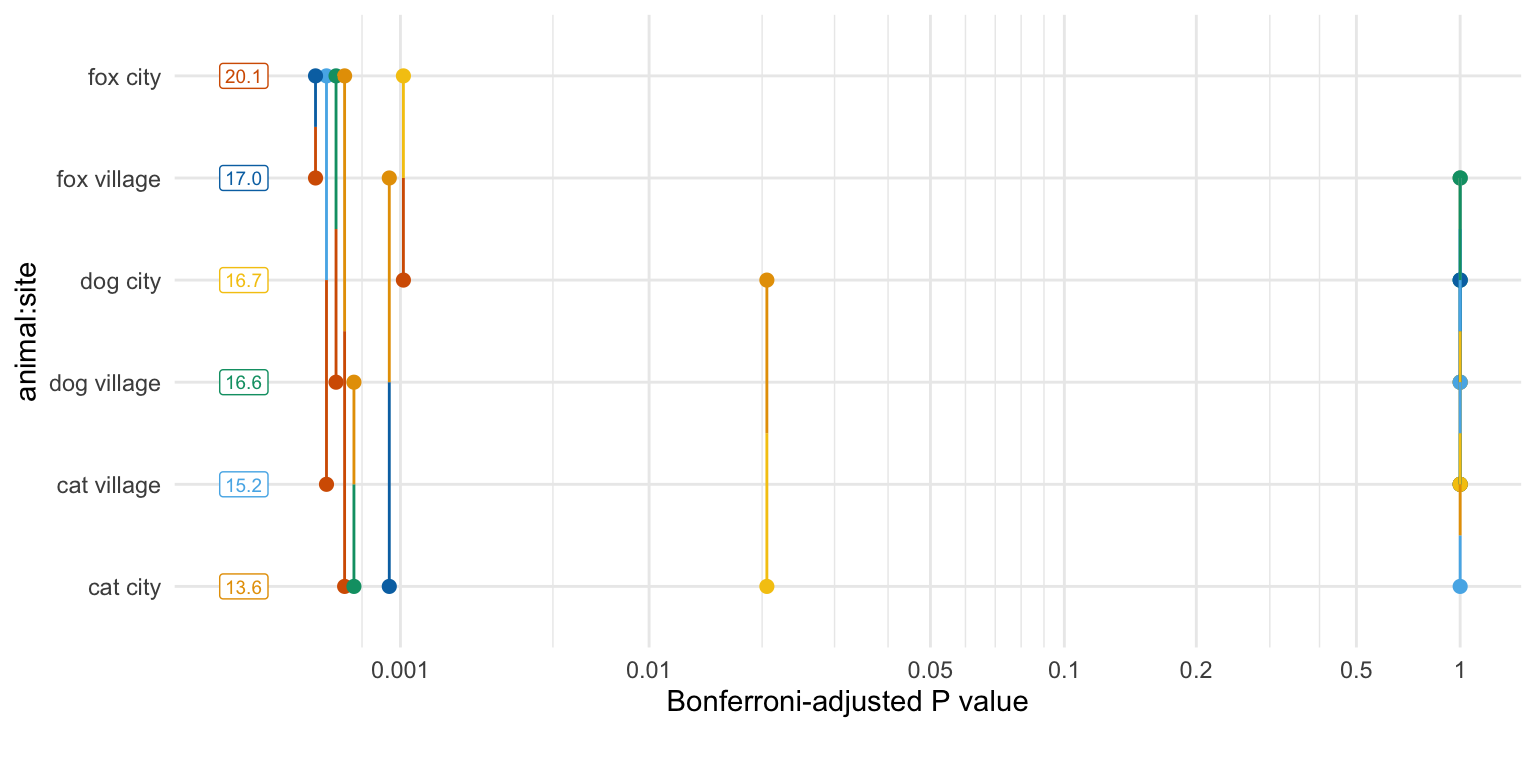

Lower triangle: Comparisons (estimate) earlier vs. laterIm einfaktoriellen Fall fand ich den paarweisen p-Wert Plot nicht so richtig informativ. Wenn du dir aber zwei Faktoren anschaust, dann kann man da schon mehr erkennen. Bilden die p-Werte in dem einen Level des zweiten Faktors ein anderes Muster als in einem anderen Level des Faktors? Hier sehen wir sehr schön, dass wir in der Stadt sehr kleine p-Werte erhalten aber auf dem Land im Dorf sehr große p-Werte. Das zeigt nochmal sehr deutlich, wie sich der erste Faktor animal in den Leveln des zweiten Faktor site unterscheidet.

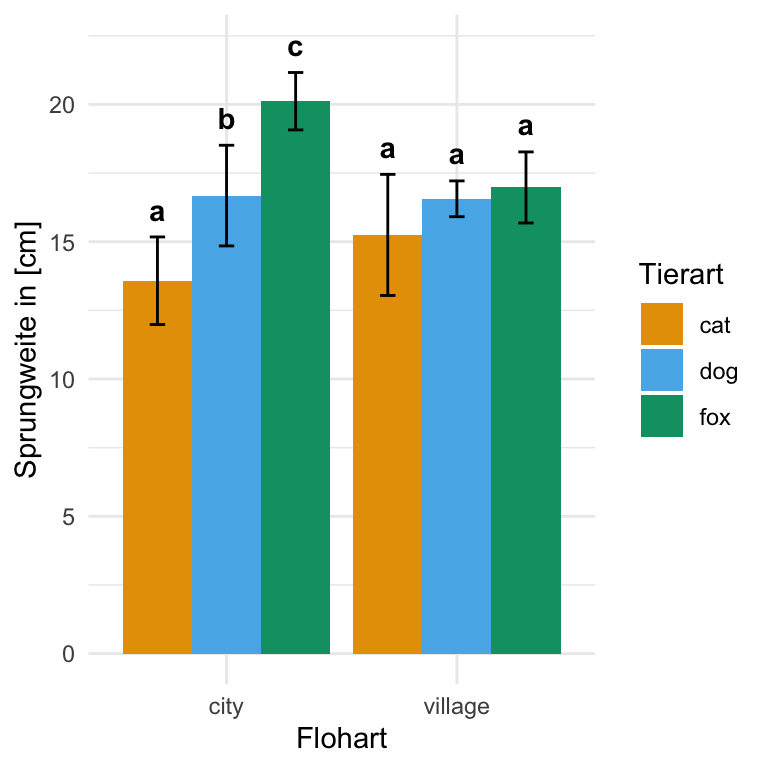

Nachdem wir in dem vorherigen Tab die p-Werte berechnet haben, könen wir jetzt einmal das Compact letter display erstellen. Hier hat das R Paket {emmeans} eine eigene Funktion mit cld(). Die Funktion nimmt das Objekt emm_fac2_separate_obj und berechnet darauf das nach Bonferroni adjustierte Compact letter display.

R Code [zeigen / verbergen]

emm_cld_fac2_separate_obj <- emm_fac2_separate_obj |>

cld(Letters = letters, adjust = "bonferroni")

emm_cld_fac2_separate_objsite = city:

animal emmean SE df lower.CL upper.CL .group

cat 13.6 0.603 54 12.1 15.1 a

dog 16.7 0.693 54 15.0 18.4 b

fox 20.1 0.395 54 19.1 21.1 c

site = village:

animal emmean SE df lower.CL upper.CL .group

cat 15.2 0.834 54 13.2 17.3 a

dog 16.6 0.246 54 16.0 17.2 a

fox 17.0 0.489 54 15.8 18.2 a

Confidence level used: 0.95

Conf-level adjustment: bonferroni method for 3 estimates

P value adjustment: bonferroni method for 3 tests

significance level used: alpha = 0.05

NOTE: If two or more means share the same grouping symbol,

then we cannot show them to be different.

But we also did not show them to be the same. Auch hier ist der große Vorteil von {emmeans}, dass wir die Ausgabe des Compact letter displays direkt nutzen können um unseren Barplot zu zeichnen. Wir müssen nur einmal die Werte der Standardfehler mit der Wurzel der Gruppenfallzahl multiplizieren um auf die Standardabweichung zu kommen. Da wir hier sieben Flöhe je Tierart gemessen haben, multiplizieren wir den Standardfehler mit der Wurzel von 7 um auf die Standardabweichung zu kommen. Dann entferne ich noch die Leerzeichen in der Spalte .group mit der Funktion str_trim() und ich kann den Barplot erstellen. Wichtig ist hier, dass wir uns die beiden Messorte city und village voneinander getrennt betrachten. Daher haben wir im Dorf auch den Buchstaben a wie auch in der Stadt, obwohl es klare Unterschiede gibt. Wenn du alle Barplots kombiniert ein Compact letter displays haben willst, dann schaue in der Analyse weiter unten nach.

R Code [zeigen / verbergen]

emm_cld_fac2_separate_obj |>

mutate(.group = str_trim(.group),

sd = SE * sqrt(7)) |>

ggplot(aes(x = site, y = emmean, fill = animal)) +

theme_minimal() +

geom_bar(stat = "identity", width = 0.9,

position = position_dodge(0.9)) +

geom_errorbar(aes(ymin = emmean-sd, ymax = emmean+sd),

width = 0.2,

position = position_dodge(0.9)) +

labs(x = "Flohart",

y = "Sprungweite in [cm]",

fill = "Tierart") +

scale_fill_okabeito() +

geom_text(aes(label = .group, y = emmean + sd + 1),

fontface = 2, position = position_dodge(0.9))Am Ende können wir dann auch aus den paarweisen Vergleichen die 95% Konfidenzintervalle berechnen. Hier nutzen wir dann die Funktion tidy() aus dem Paket {broom} um uns die 95% Konfidenzintervalle sauber wiedergeben zu lassen. Ich habe hier einmal die Kontraste auf revpairwise gestellt um die Vergleiche wie bei den p-Werten zu drehen.

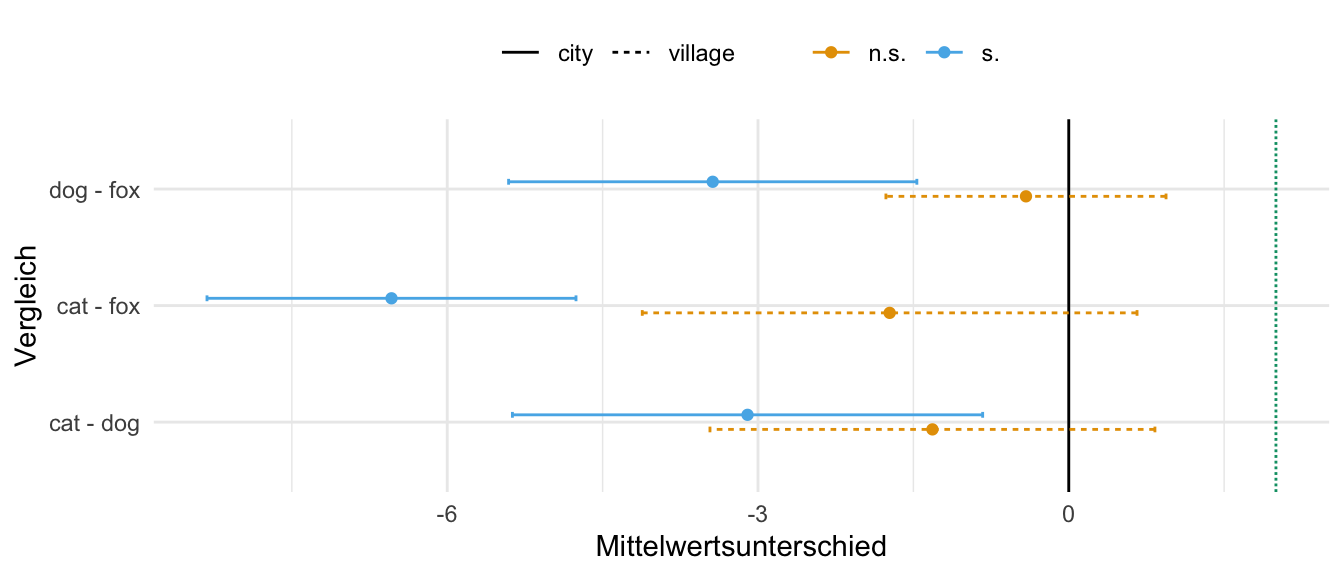

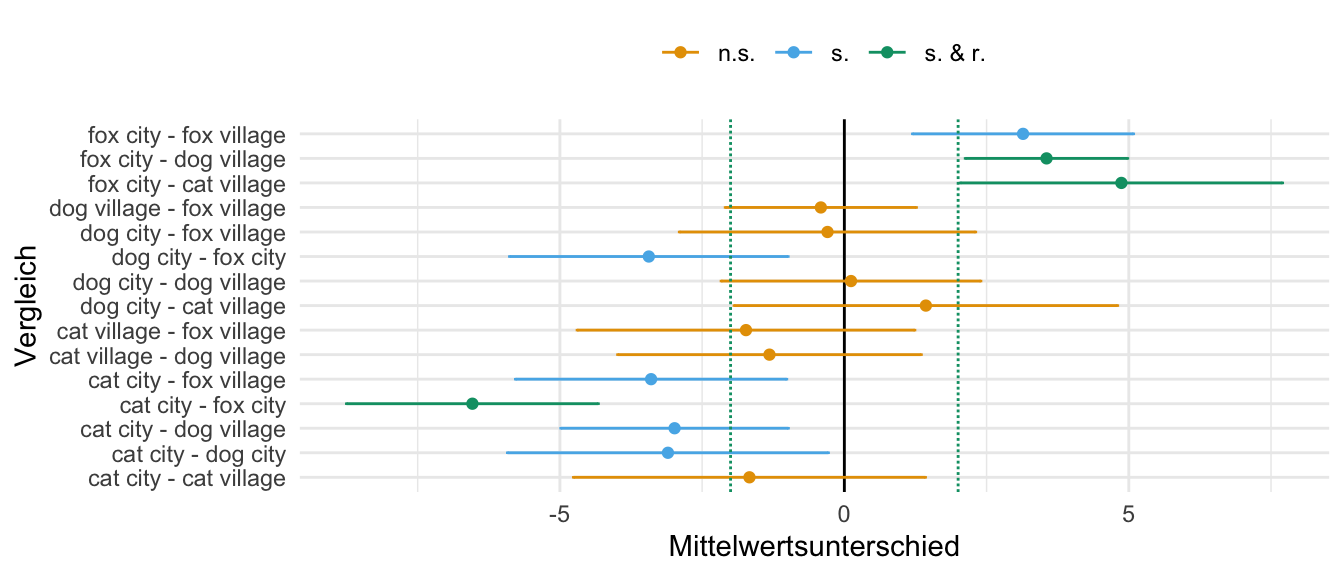

R Code [zeigen / verbergen]

emm_ci_fac2_separate_obj <- emm_fac2_separate_obj |>

contrast(method = "pairwise", adjust = "bonferroni") |>

tidy(conf.int = TRUE) |>

select(contrast, site, estimate, conf.low, conf.high) Die Stärke eines 95% Konfidenzintervalls ist ja die Signifikanz mit der Relevanz zu verbinden. Daher setze ich jetzt mal die Relevanzschwelle relevance_lvl auf \(>2cm\). Wenn also Floharten im Mittel sich mindestens um \(2cm\) unterscheiden, dann ist der Vergleich relevant. Das habe ich jetzt einfach so entschieden. Wir schauen hier dann auf größer/gleich, was auch mehr Sinn macht. Theoretisch kannst du auch in beide Richtungen die Relevanz definieren, aber in der Anwendung ist es eher selten, dass uns beide Richtungen interessieren.

R Code [zeigen / verbergen]

relevance_lvl <- 2In der folgenden Abbildung siehst du einmal die 95% Konfidenzintervalle für alle paarweisen Vergleiche. Ich habe am Anfang nochmal eine Regel mit case_when() erstellt, nachder ich dann die 95% Konfidenzintervall nach der Signifikanz und Relevanz einfärbe. Das ist ja die Stärke der 95% Konfidenzintervalle und dann sollte man die auch Nutzen. Wo du die Relevanzschwelle legst, ist dann dir selber überlassen. Das hängt von deiner wissenschaftlichen Fragestellung ab. Beachte, dass ich hier noch die Linienart ändern musste um die Messorte mit einzeichnen zu können. Wir haben am Ende nur einen relevanten und signifikanten Vergleich. Nämlich den Vergleich der Fuchsflöhe zu den Katzenflöhen in der Stadt.

R Code [zeigen / verbergen]

emm_ci_fac2_separate_obj |>

mutate(sig_lgl = case_when(between(rep(0, n()), conf.low, conf.high) ~ "n.s.",

relevance_lvl < conf.low ~ "s. & r.",

.default = "s.")) |>

ggplot(aes(contrast, y = estimate,

ymin = conf.low, ymax = conf.high,

color = sig_lgl, linetype = site)) +

theme_minimal() +

geom_hline(yintercept = 0) +

geom_errorbar(width = 0.1, position = position_dodge(0.25)) +

geom_hline(yintercept = relevance_lvl, linetype = "11",

color = "#009E73") +

geom_point(position = position_dodge(0.25)) +

coord_flip() +

scale_color_okabeito() +

labs(x = "Vergleich", y = "Mittelwertsunterschied",

color = "", linetype = "") +

theme(legend.position = "top")Eben gerade haben wir das {emmeans} Objekt für unsere zweifaktorielle Analyse für die getrennte Analyse über den zweiten Faktor genutzt. Jetzt zeige ich dir in den folgenden Tabs einmal wie du die p-Werte, das Comapct letter display und die 95% Konfidenzintervalle für die kombinierte Analyse über die beiden Faktoren \(f_1\) und \(f_2\) berechnest. Das heißt, wir wollen jetzt nicht mehr getrennt die Floharten über die Messorte anschauen, sondern die Interaktionen zwischen den Floharten und Messorten analysieren. Daher werden wir jetzt ein paar mehr Vergleiche rechnen als eben gerade im obigen Fall der getrennten Analyse.

Beginnen wir wieder die p-Werte für unseren Vergleich der Floharten für die mittleren Sprungweiten zu berechnen. Wir nutzen hierzu wieder die Funktion contrast() wie auch schon im einfaktoriellen Fall. Das ist jetzt auch so eine Stärke von {emmeans}, wenn wir das Modell hinkriegen, dann können wir auch mehr Faktoren beliebig ergänzen.

R Code [zeigen / verbergen]

emm_contrast_fac2_combined_obj <- emm_fac2_combinded_obj |>

contrast(method = "pairwise", adjust = "bonferroni")

emm_contrast_fac2_combined_obj contrast estimate SE df t.ratio p.value

cat city - dog city -3.101 0.919 54 -3.376 0.0206

cat city - fox city -6.538 0.721 54 -9.070 <.0001

cat city - cat village -1.668 1.010 54 -1.655 1.0000

cat city - dog village -2.984 0.651 54 -4.581 0.0004

cat city - fox village -3.397 0.776 54 -4.375 0.0008

dog city - fox city -3.437 0.798 54 -4.310 0.0010

dog city - cat village 1.433 1.100 54 1.305 1.0000

dog city - dog village 0.117 0.743 54 0.157 1.0000

dog city - fox village -0.296 0.848 54 -0.349 1.0000

fox city - cat village 4.870 0.922 54 5.279 <.0001

fox city - dog village 3.554 0.465 54 7.639 <.0001

fox city - fox village 3.141 0.633 54 4.964 0.0001

cat village - dog village -1.316 0.869 54 -1.514 1.0000

cat village - fox village -1.729 0.967 54 -1.789 1.0000

dog village - fox village -0.413 0.547 54 -0.755 1.0000

P value adjustment: bonferroni method for 15 tests Das sind eine Menge an Vergleichen. Daher ist es jetzt erstmal die Frage was hier eigentlich wie signifkant ist. Wiederum sieht man dann doch hier, das das Compact letter display gar nicht so schlecht ist um eine Übersicht zu kriegen. Hier ist es dann doch sehr unübersichtlich, welcher Vergleich nun wie signifikant ist. Vorallem lässt sich schwer ein übergeordnetes Muster erkennen.

Jetzt können wir uns auch die Vergleiche als eine Matrix anzeigen lassen. Hier ist es natürlich praktisch, dass wir gleich die Mittelwerte sowie die mittleren Differenzen als auch die p-Werte in einer Ausgabe vorliegen haben. Darüber hinaus sortiert die Matrix auch die vergleiche einmal sinnvoll und wir können viel besser sehen, welche Vergleiche signifikant sind. So lässt sich auch einfacher die Frage beantworten, ob wir Floharten oder Orte haben, wo alles signifikant ist oder die Signifikanz eher zufällig über die Vergleiche verteilt ist.

R Code [zeigen / verbergen]

emm_fac2_combinded_obj |>

pwpm(adjust = "bonferroni") cat city dog city fox city cat village dog village fox village

cat city [13.6] 0.0206 <.0001 1.0000 0.0004 0.0008

dog city -3.101 [16.7] 0.0010 1.0000 1.0000 1.0000

fox city -6.538 -3.437 [20.1] <.0001 <.0001 0.0001

cat village -1.668 1.433 4.870 [15.2] 1.0000 1.0000

dog village -2.984 0.117 3.554 -1.316 [16.6] 1.0000

fox village -3.397 -0.296 3.141 -1.729 -0.413 [17.0]

Row and column labels: animal:site

Upper triangle: P values adjust = "bonferroni"

Diagonal: [Estimates] (emmean)

Lower triangle: Comparisons (estimate) earlier vs. laterDen paarweisen p-Wert Plot finde ich dann mit so vielen vergleichen dann schon wieder nicht so informativ. Wir haben eben sehr viele signifikante Unterschiede. Dann liegen auchs ehr viele Linien an der linken Seite und es ist schwer zu lesen, was wir hier vorliegen haben. Eventuell müsste man nochmal animal * site in dem emmeans() Aufruf auf site * animal drehen und schauen, ob dann die Ordnung der Vergleiche auf der y-Achse etwas besser ist. Aber das ändert auch nichts and er Anzahl an Vergleichen. Jede Abbildung hat dann so seine Grenzen.

Nachdem wir in dem vorherigen Tab die p-Werte berechnet haben, könen wir jetzt einmal das Compact letter display erstellen. Hier hat das R Paket {emmeans} eine eigene Funktion mit cld(). Die Funktion nimmt das Objekt emm_fac2_combindedobj und berechnet darauf das nach Bonferroni adjustierte Compact letter display.

R Code [zeigen / verbergen]

emm_cld_fac2_combined_obj <- emm_fac2_combinded_obj |>

cld(Letters = letters, adjust = "bonferroni")

emm_cld_fac2_combined_obj animal site emmean SE df lower.CL upper.CL .group

cat city 13.6 0.603 54 11.9 15.2 a

cat village 15.2 0.834 54 13.0 17.5 ab

dog village 16.6 0.246 54 15.9 17.2 b

dog city 16.7 0.693 54 14.8 18.6 b

fox village 17.0 0.489 54 15.6 18.3 b

fox city 20.1 0.395 54 19.0 21.2 c

Confidence level used: 0.95

Conf-level adjustment: bonferroni method for 6 estimates

P value adjustment: bonferroni method for 15 tests

significance level used: alpha = 0.05

NOTE: If two or more means share the same grouping symbol,

then we cannot show them to be different.

But we also did not show them to be the same. Der große Vorteil von {emmeans} ist, dass wir die Ausgabe des Compact letter displays direkt nutzen können um unseren Barplot zu zeichnen. Wir müssen nur einmal die Werte der Standardfehler mit der Wurzel der Gruppenfallzahl multiplizieren um auf die Standardabweichung zu kommen. Da wir hier sieben Flöhe je Tierart gemessen haben, multiplizieren wir den Standardfehler mit der Wurzel von 7 um auf die Standardabweichung zu kommen. Dann entferne ich noch die Leerzeichen in der Spalte .group mit der Funktion str_trim() und ich kann den Barplot erstellen.

R Code [zeigen / verbergen]

emm_cld_fac2_combined_obj |>

mutate(.group = str_trim(.group),

sd = SE * sqrt(7)) |>

ggplot(aes(x = site, y = emmean, fill = animal)) +

theme_minimal() +

geom_bar(stat = "identity", width = 0.9,

position = position_dodge(0.9)) +

geom_errorbar(aes(ymin = emmean-sd, ymax = emmean+sd),

width = 0.2,

position = position_dodge(0.9)) +

labs(x = "Flohart",

y = "Sprungweite in [cm]",

fill = "Tierart") +

scale_fill_okabeito() +

geom_text(aes(label = .group, y = emmean + sd + 1),

fontface = 2, position = position_dodge(0.9))Am Ende können wir dann auch aus den paarweisen Vergleichen die 95% Konfidenzintervalle berechnen. Hier nutzen wir dann die Funktion tidy() aus dem Paket {broom} um uns die 95% Konfidenzintervalle sauber wiedergeben zu lassen. Ich habe hier einmal die Kontraste auf revpairwise gestellt um die Vergleiche wie bei den p-Werten zu drehen.

R Code [zeigen / verbergen]

emm_ci_fac2_combined_obj <- emm_fac2_combinded_obj |>

contrast(method = "pairwise", adjust = "bonferroni") |>

tidy(conf.int = TRUE) |>

select(contrast, estimate, conf.low, conf.high) Die Stärke eines 95% Konfidenzintervalls ist ja die Signifikanz mit der Relevanz zu verbinden. Weil wir jetzt hier so viele paarweise Vergleiche haben, macht es dann doch Sinn die Relevanzschwelle in beide Richtungen zu definieren. Daher setze ich jetzt mal die Relevanzschwelle relevance_lvl auf \(<2cm\) und \(>2cm\). Wenn also Floharten im Mittel sich mindestens um \(\pm 2cm\) unterscheiden, dann ist der Vergleich relevant. Das habe ich jetzt einfach so entschieden.

R Code [zeigen / verbergen]

relevance_lvl <- c(-2, 2)In der folgenden Abbildung siehst du einmal die 95% Konfidenzintervalle für alle paarweisen Vergleiche. Ich habe am Anfang nochmal eine Regel mit case_when() erstellt, nachder ich dann die 95% Konfidenzintervall nach der Signifikanz und Relevanz einfärbe. Hier ist es dann etwas komplexer, weil ich eben beide Richtungen berücksichtigen will. Wo du die Relevanzschwelle legst, ist dann dir selber überlassen. Das hängt von deiner wissenschaftlichen Fragestellung ab. Wir haben dann drei signifikante und relevante Vergleiche am Ende. In allen drei Fällen ist jeweils der Fuchs in der Stadt enthalten. Wobei in zwei Vergleichen der Unterschied zum Dorf signifikant sowie relevant ist und in einem Vergleich zum Stadtkatzenfloh. Spannendes Ergebnis in diesem Fall.

R Code [zeigen / verbergen]

emm_ci_fac2_combined_obj |>

mutate(sig_lgl = case_when(between(rep(0, n()), conf.low, conf.high) ~ "n.s.",

relevance_lvl[2] < conf.low |

relevance_lvl[1] > conf.high ~ "s. & r.",

.default = "s.")) |>

ggplot(aes(contrast, y = estimate,

ymin = conf.low, ymax = conf.high, color = sig_lgl)) +

theme_minimal() +

geom_hline(yintercept = 0) +

geom_errorbar(width = 0.1) +

geom_hline(yintercept = c(relevance_lvl), linetype = "11",

color = "#009E73") +

geom_point() +

coord_flip() +

scale_color_okabeito() +

labs(x = "Vergleich", y = "Mittelwertsunterschied", color = "") +

theme(legend.position = "top")Weitere möglichen Analysen