54 Marginal effect models

Letzte Änderung am 31. October 2025 um 20:31:26

“Life is difficult.” — Morgan Scott Peck, The Road Less Traveled

Lange habe ich gebraucht um mich dazu durchzuringen das Kapitel zu den Marginal effect models (deu. marginale Effektmodelle, ungebräuchlich) zu schreiben.1 Ich werde hier bei dem englischen Begriff bleiben, den deutschen Begriff habe ich eher selten gehört und daher sind es für mich Marginal effect models. Insbesondere da der Begriff “marginal” auch sehr an gering oder minderwertig erinnert. Damit haben aber die Marginal effect models nicht im geringsten zu tun. Die Modelle sind sehr mächtig und können uns helfen wichtige Fragen an unsere Daten zu beantworten. Insbesondere die Dualität der beiden Pakete {emmeans} für experimentelle Daten und {marginaleffects} für beobachtete Daten ist spannend und möchte ich hier nochmal genauer betrachten. Neben diesen beiden Ecksteinen gibt es noch andere Pakete und ich werde auch hier einmal in die Pakete reinschauen.

Anfangen kann ich aber nicht ohne Heiss (2022) mit seinem Blogpost Marginalia: A guide to figuring out what the heck marginal effects, marginal slopes, average marginal effects, marginal effects at the mean, and all these other marginal things are zu erwähnen. Vieles entlehnt sich direkt oder indirekt an seine Ausführungen. Wie immer habe ich etwas angepasst, wenn ich der Meinung war, dass es noch besser zu verstehen ist. Teilweise entfalten die Marginal effect models ihre wahre Kraft erst bei den nicht linearen Zusammenhängen und der Interpretation von Generalized Additive Models und somit der nicht linearen Regression. Fangen wir also an Marginal effect models zu zerforschen und arbeiten uns dann voran.. Beginnen wollen wir aber mit einem allgemeinen Hintergrund bevor wir uns dann nochmal tiefer mit den Marginal effect models beschäftigen.

Sprachlicher Hintergrund

“In statistics courses taught by statisticians we don’t use independent variable because we use independent on to mean stochastic independence. Instead we say predictor or covariate (either). And, similarly, we don’t say”dependent variable” either. We say response.” — User berf auf r/AskStatistics

Wenn wir uns mit dem statistischen Modellieren beschäftigen wollen, dann brauchen wir auch Worte um über das Thema reden zu können. Statistik wird in vielen Bereichen der Wissenschaft verwendet und in jedem Bereich nennen wir dann auch Dinge anders, die eigentlich gleich sind. Daher werde ich mir es hier herausnehmen und auch die Dinge so benennen, wie ich sie für didaktisch sinnvoll finde. Wir wollen hier was verstehen und lernen, somit brauchen wir auch eine klare Sprache.

“Jeder nennt in der Statistik sein Y und X wie er möchte. Da ich hier nicht nur von Y und X schreiben will, führe ich eben die Worte ein, die ich nutzen will. Damit sind die Worte dann auch richtig, da der Kontext definiert ist. Andere mögen es dann anders machen. Ich mache es eben dann so. Danke.” — Jochen Kruppa-Scheetz, meiner bescheidener Meinung nach.

In dem folgenden Kasten erkläre ich nochmal den Gebrauch meiner Begriffe im statistischen Testen. Es ist wichtig, dass wir hier uns klar verstehen. Zum einen ist es angenehmer auch mal ein Wort für ein Symbol zu schreiben. Auf der anderen Seite möchte ich aber auch, dass du dann das Wort richtig einem Konzept im statistischen Modellieren zuordnen kannst. Deshalb einmal hier meine persönliche und didaktische Zusammenstellung meiner Wort im statistischen Modellieren. Du kannst dann immer zu dem Kasten zurückgehen, wenn wir mal ein Wort nicht mehr ganz klar ist. Die fetten Begriffe sind die üblichen in den folgenden Kapiteln. Die anderen Worte werden immer mal wieder in der Literatur genutzt.

“Die Grenzen meiner Sprache bedeuten die Grenzen meiner Welt.” — Ludwig Wittgenstein

Hier kommt einmal die Tabelle mit den wichtigsten Begriffen im statistischen Modellieren und wie ich die Worte benutzen werde. Damit wir uns verstehen und du was lernen kannst. In anderen Büchern und Quellen findest du teilweise die Worte in einem anderen Sinnzusammenhang. Das ist gut so dort. Bei mir ist es anders.

| Symbol | Deutsch | Englisch | |

|---|---|---|---|

| LHS | \(Y\) / \(y\) | Messwert / Endpunkt / Outcome / Abhängige Variable | response / outcome / endpoint / dependent variable |

| RHS | \(X\) / \(x\) | Einflussvariable / Erklärende Variable / Fester Effekt / Unabhängige Variable | risk factor / explanatory / fixed effect / independent variable |

| RHS | \(Z\) / \(z\) | Zufälliger Effekt | random effect |

| \(X\) ist kontinuierlich | \(c_1\) | Kovariate 1 | covariate 1 |

| \(X\) ist kategorial | \(f_A\) | Faktor \(A\) mit Level \(A.1\) bis \(A.j\) | factor \(A\) with levels \(A.1\) to \(A.j\) |

Am Ende möchte ich nochmal darauf hinweisen, dass wirklich häufig von der abhängigen Variable (eng. dependent variable) als Messwert und unabhängigen Variablen (eng. independent variable) für die Einflussvariablen gesprochen wird. Aus meiner Erfahrung bringt die Begriffe jeder ununterbrochen durcheinander. Deshalb einfach nicht diese Worte nutzen.

54.1 Allgemeiner Hintergrund

“Statistics is all about lines, and lines have slopes, or derivatives. These slopes represent the marginal changes in an outcome. As you move an independent/explanatory variable, what happens to the dependent/outcome variable?” — Heiss (2022)

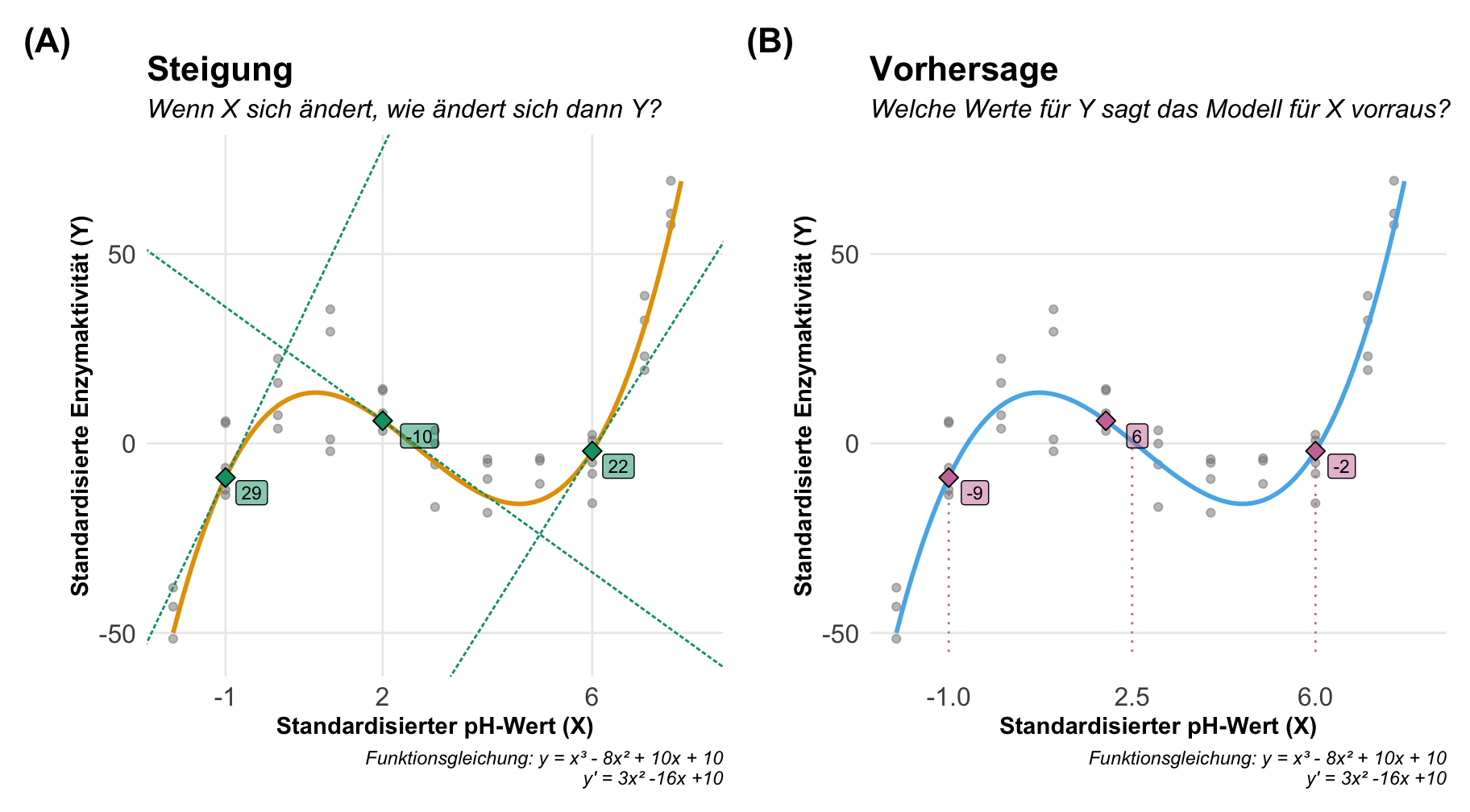

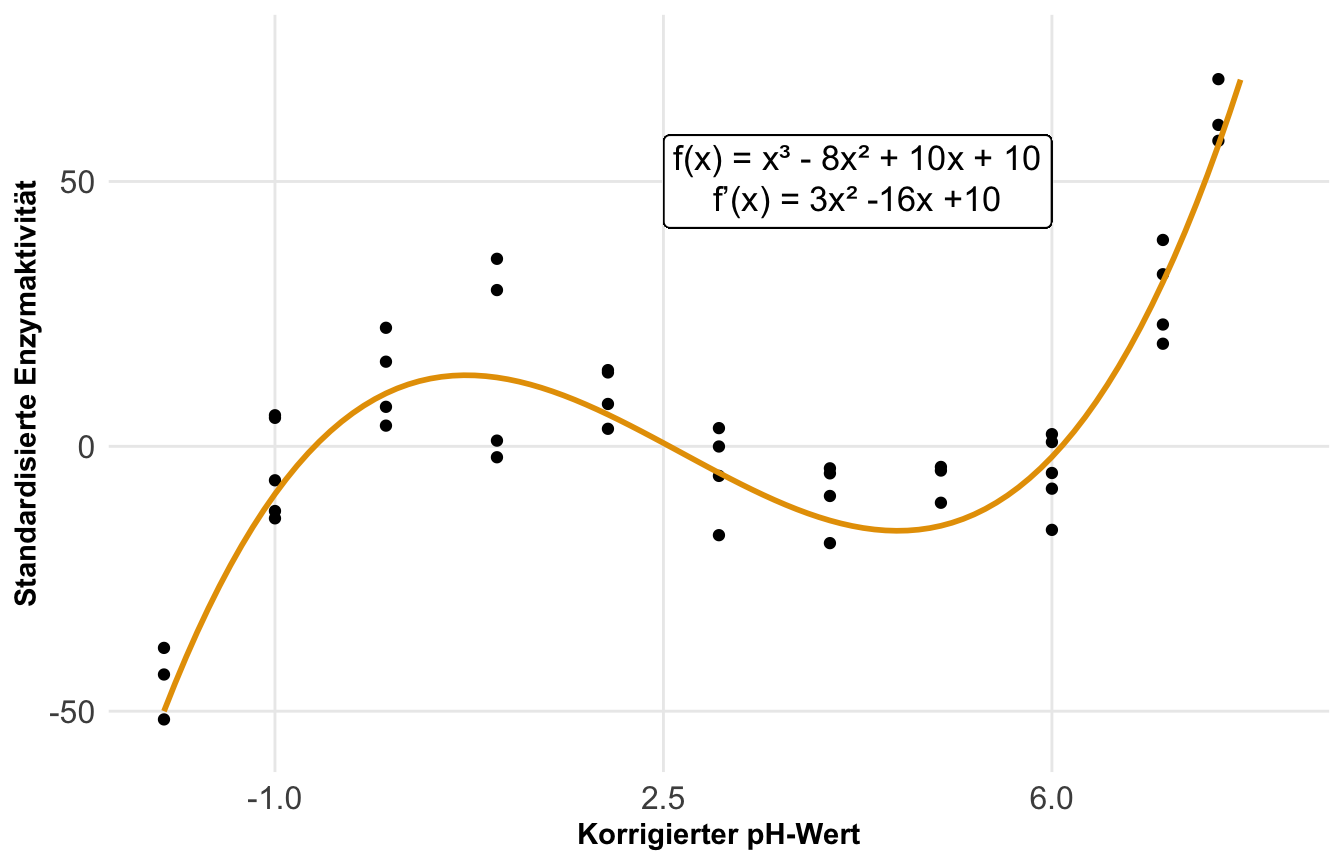

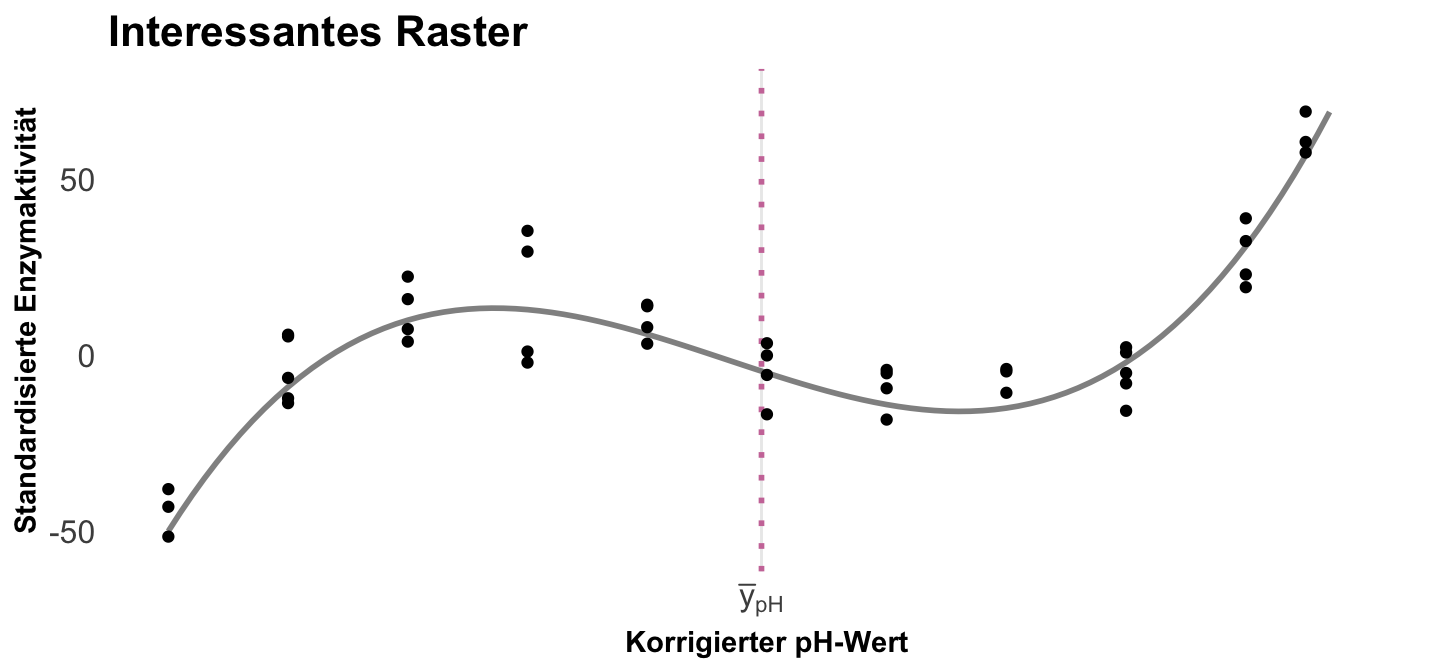

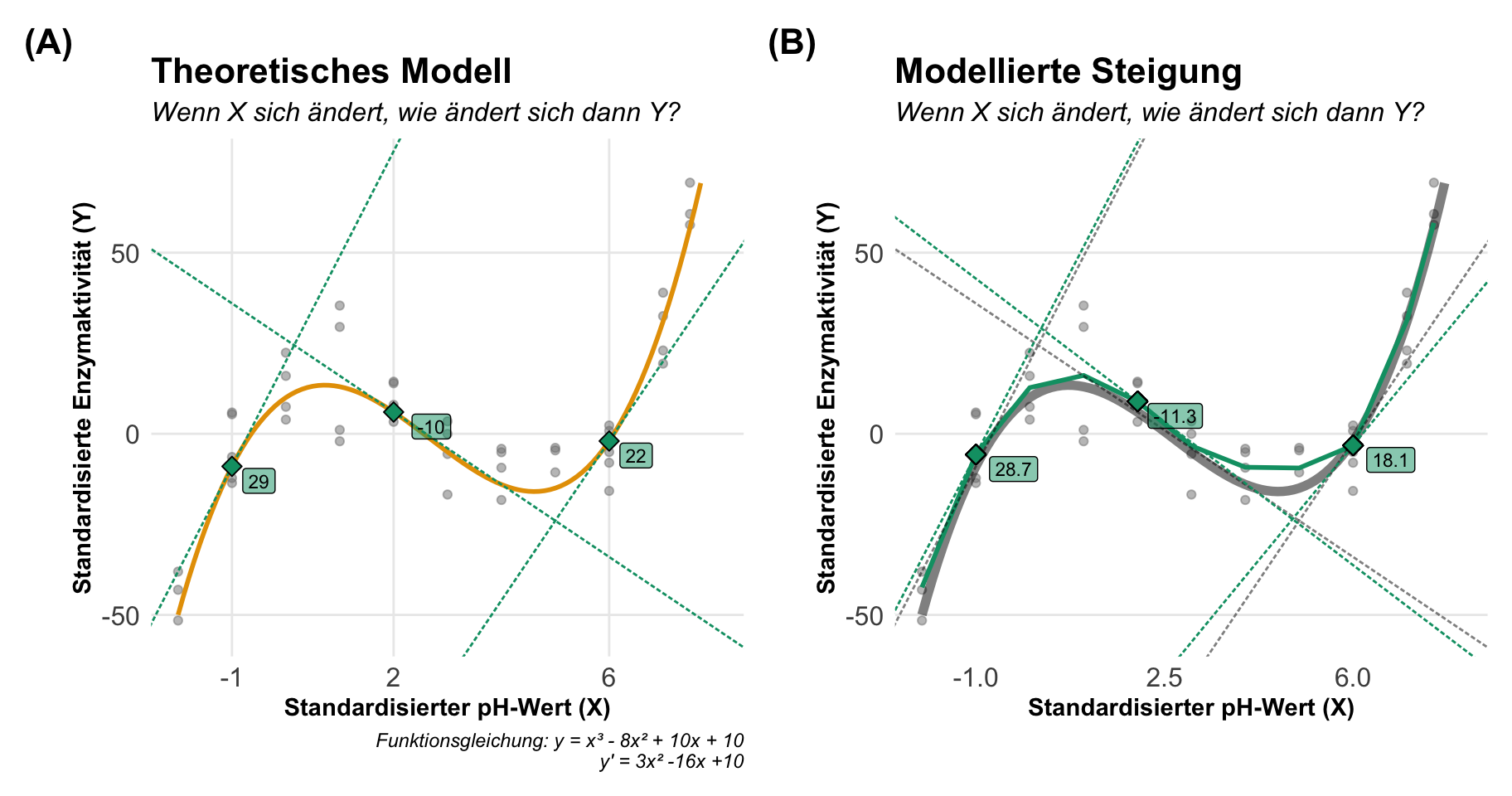

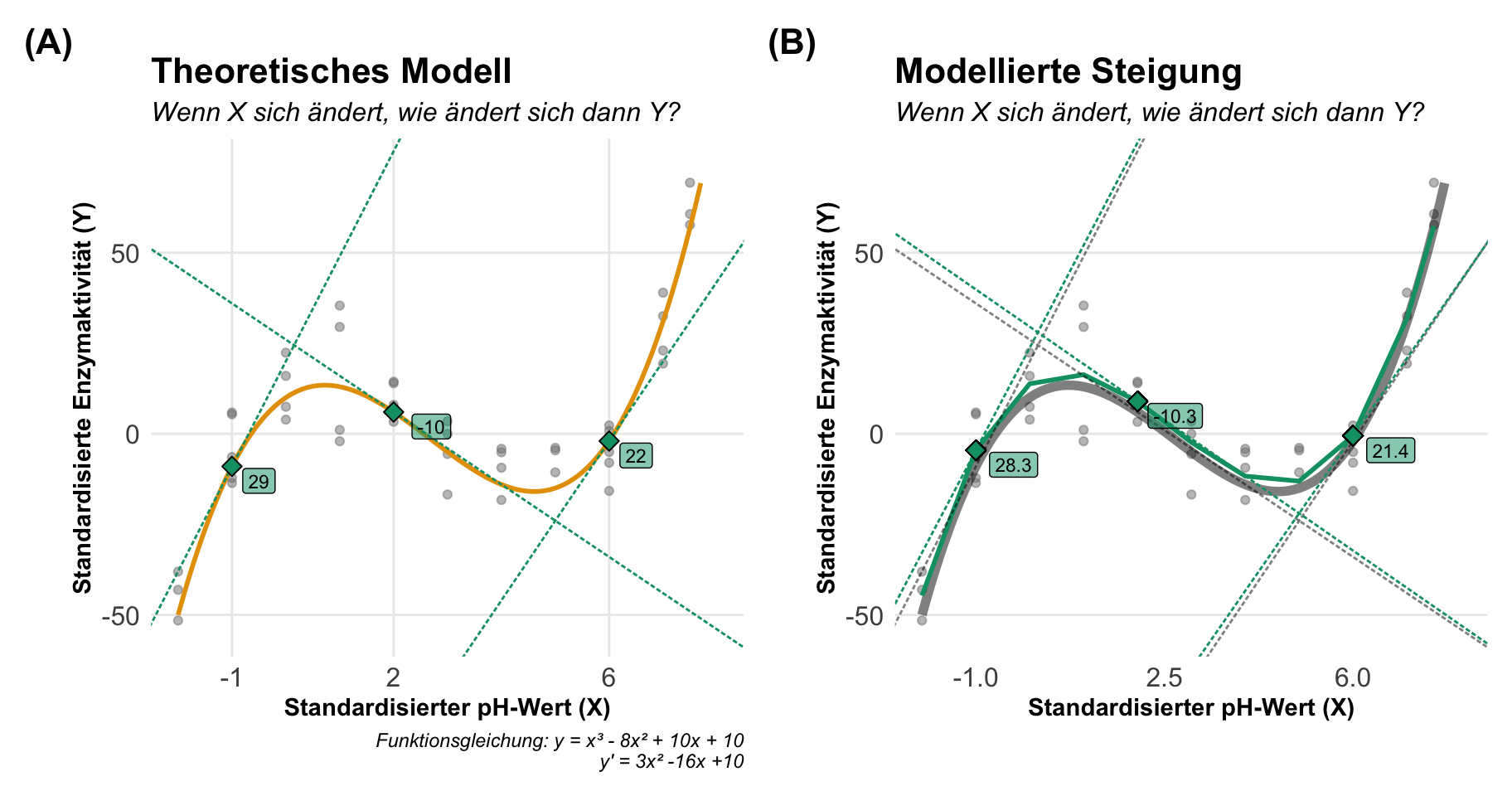

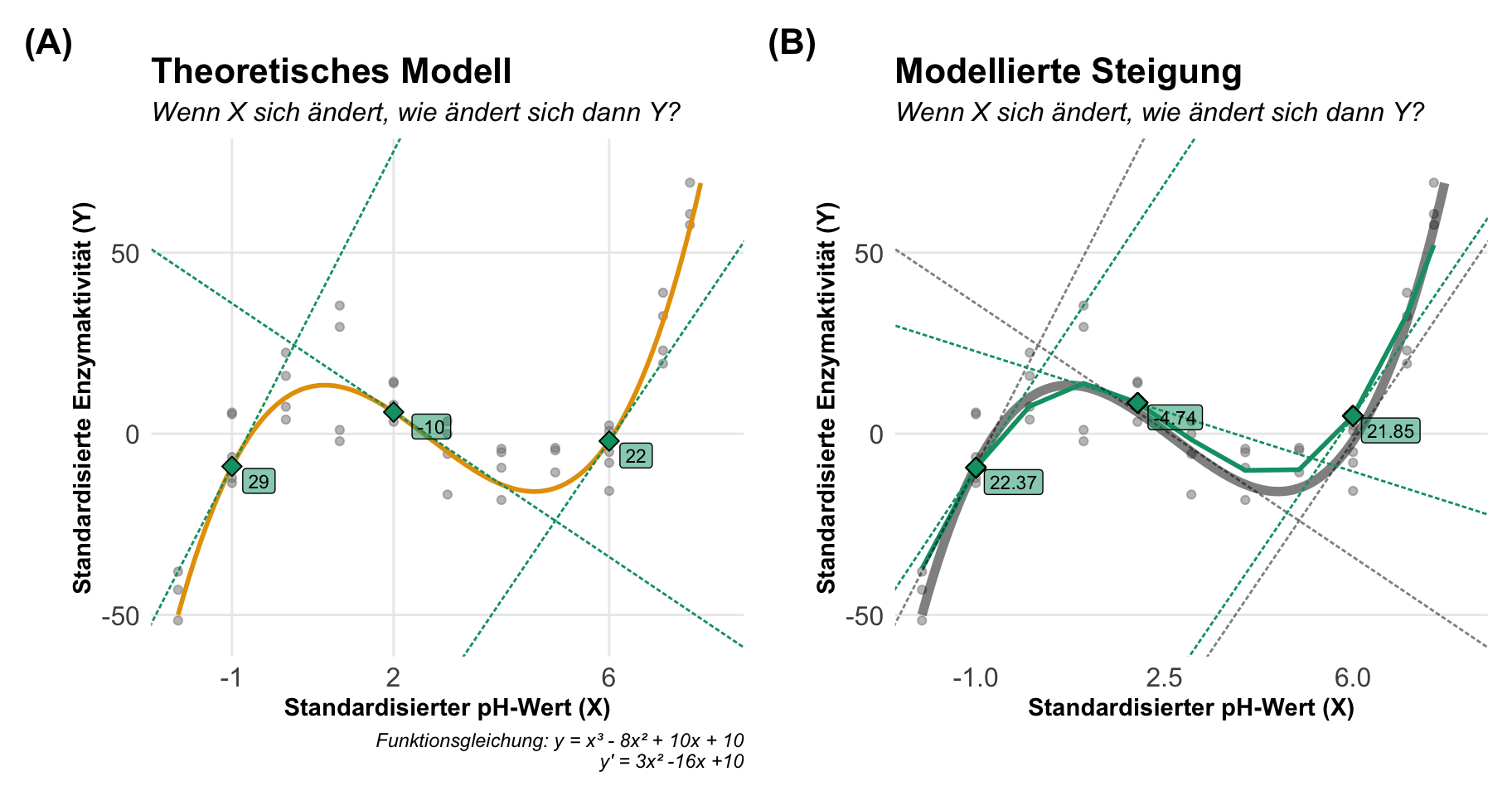

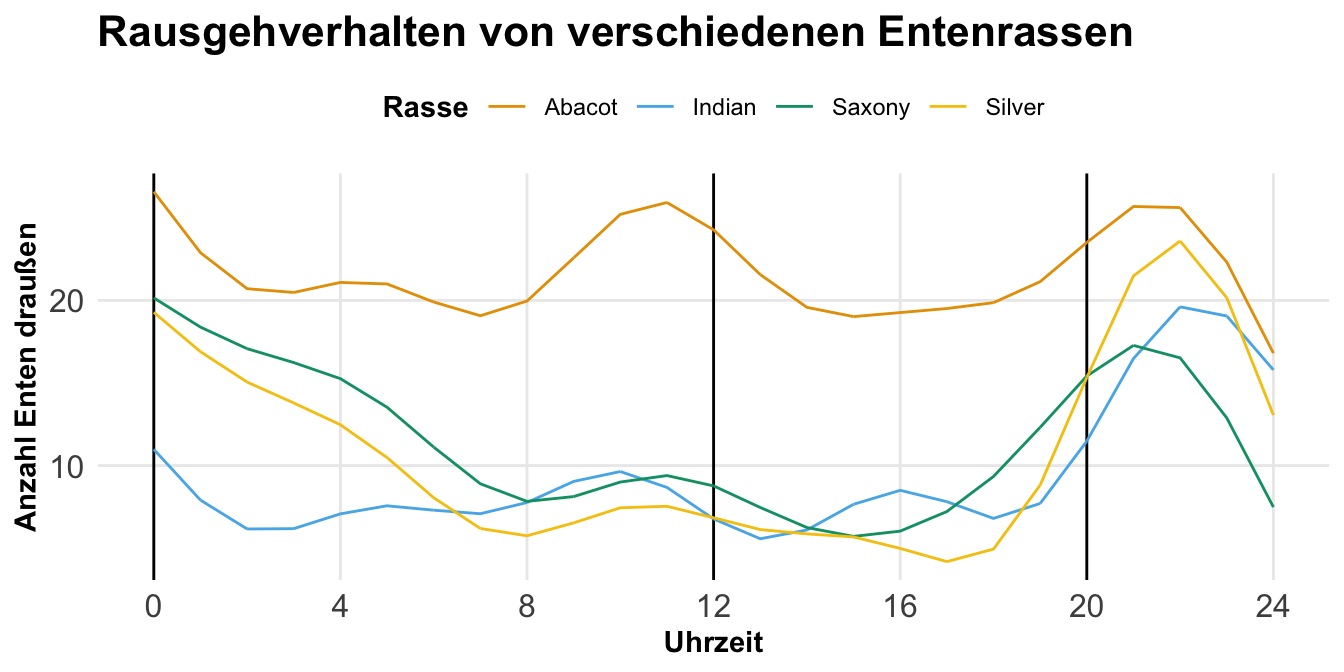

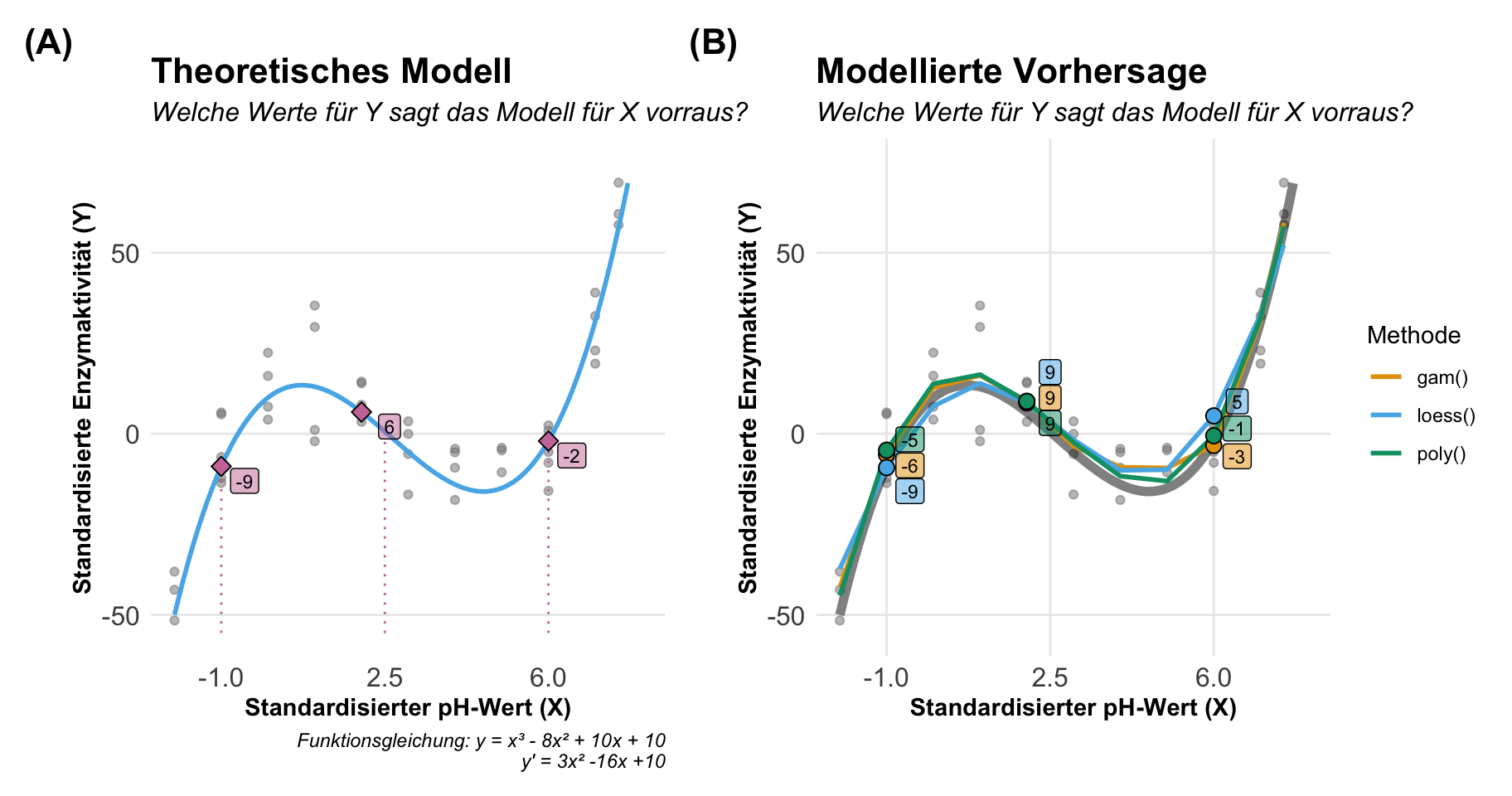

Wenn wir von Marginal effect models sprechen, dann können wir uns im Prinzip zwei Aspekte anschauen. Wir können über die Steigung einer Funktion einer Geraden sprechen oder aber über die vorhergesagten \(y\)-Werte auf der Geraden für beliebige \(x\)-Werte. Damit sind wir dann bei den beiden Aspekten Steigung und Vorhersage. Wenn wir uns in der Welt der linearen Modelle bewegen, dann ist die Steigung eigentlich kein Problem und die Vorhersage auch nicht so komplex. Spannender wird das Zusammenspiel eines nichtlinearen Modells und eben den Marginal effect models. Hier kommt dann die eigentliche Kraft der Marginal effect models zu trage. In den folgenden beiden Abbildungen habe ich dir einmal eine nichtlinere Funktion dargestellt. Wir schauen uns hier den Zusammenhang zwischen der standardisierten Enzymaktivität und dem standardisierten pH-Wert an. Wir haben die Enzymaktivität zu festen pH-Werten wiederholt gemessen. Auf der linken Seite betrachten wir die Steigung der Geraden an drei Punkten und auf der rechten Seite sehen wir einmal die Vorhersage für drei pH-Werte auf der Geraden. Die Gerade folgt der Funktion \(y = x^3 - 8x^2 + 10x + 10\) und ist mir somit für die Bestimmung der Steigung und der Vorhersage bekannt. Daher habe ich also die Möglichkeit die exakten Werte der Steigung und der Vorhersage zu bestimmen. Einen Luxus den wir selten mit echten Daten haben.

Betrachten wir also einmal die Antworten, die die Steigung und die Vorhersage liefert. Dabei haben wir hier in diesem Fall ein kontinuierliches \(X\) als Kovariate vorliegen und machen uns die Sachlage auch einfacher indem wir ein kontinuierliches \(Y\) mit der standardisierten Enzymektivität vorliegen haben.

- Welche Antwort liefert die Steigung?

-

Wenn sich \(X\) ändert, wie ändert sich dann \(Y\) an dem Wert von \(X\)? Hierbei muss sich \(X\) nicht um eine Einheit verändern, wie wir es gerne im linearen Zusammenhang sagen, sondern wir wollen die Steigung direkt im Punkt von \((X;Y)\) haben.

- Welche Antwort liefert die Vorhersage?

-

Welche Werte für \(Y\) sagt das Modell für \(X\) vorraus? Wir müssen hier die beobachteten Werte von \(Y\), die in unserem Beispiel für einen pH-Wert wiederholt vorkommen, von dem einen vorhergesagten \(Y\) Wert aus dem Modell für ein gegebenes \(X\) unterscheiden.

Dann können wir auch schon die Steigung und die Vorhersage einmal interpretieren. In dem linken Tab findest du einmal die Interpretation der Steigung sowie die Ausgabe der Funktion slopes() aus dem R Paket {marginaleffects}. In dem rechten Tab dann die Ergebnisse der Vorhersage und die Ausgabe der Funktion predictions(). Mehr zu den beiden Funktionen dann weiter unten in der Anwendung. Ich berechne hier die Steigung und bestimme die vorhergesagten Werte für drei ausgewählte pH-Werte.

Wir können einmal die Steigung \((dx/dy)\) aus der ersten Ableitung der quadratischen Geradenfunktion für unsere ausgewählten pH-Werte bestimmen und dann entsprechend interpretieren.

| pH | Steigung | Interpretation |

|---|---|---|

| -1 | 29 | Bei einem standardisierten pH-Wert von -1 steigt die Enzymaktivität um 29U an. |

| 2 | -10 | Bei einem standardisierten pH-Wert von 2 sinkt die Enzymaktivität um 10U. |

| 6 | 22 | Bei einem standardisierten pH-Wert von 6 steigt die Enzymaktivität um 22U an. |

Wir können uns dann die Steigung auch direkt mit der Funktion slopes() bestimmen lassen und erhalten dann die folgenden Informationen. Häufig haben wir ja nicht die Geradengleichung vorliegen. Hier haben wir dann auch die p-Werte sowie einen entsprechenden Fehler. Wir haben hier eine leichte Abweichung, da ich die obige Steigung durch die Ableitung der quadratischen Funktion erstellt habe und nicht aus einem Polynomialmodell entnommen habe.

ph Estimate Std. Error z Pr(>|z|) S 2.5 % 97.5 %

-1 28.3 2.44 11.57 <0.001 100.5 23.5 33.04

2 -10.3 1.14 -9.08 <0.001 63.0 -12.6 -8.11

6 21.4 1.63 13.16 <0.001 129.0 18.3 24.64

Term: ph

Type: response

Comparison: dY/dXAuch hier können wir direkt durch das Einsetzen der pH-Werte in unsere quadratische Geradenfunktion die vorgesagten Enzymaktivitäten für die ausgewählten pH-Werte bestimmen.

| pH | Vorhersage (y) | Interpretation |

|---|---|---|

| -1 | -9 | Für einen standardisierten pH-Wert von -1 sagt die Funktion eine Enzymaktivität von -9U vorher. |

| 2 | 6 | Für einen standardisierten pH-Wert von 2 sagt die Funktion eine Enzymaktivität von 6U vorher. |

| 6 | -2 | Für einen standardisierten pH-Wert von 6 sagt die Funktion eine Enzymaktivität von -2U vorher. |

Auch können wir die Steigung aus den Daten direkt mit der Funktion predictions() bestimmen. Häufig haben wir ja nicht die Geradengleichung vorliegen. Hier haben wir theoretisch noch eine riesige Auswahl an Funktionen in R, wir konzentrieren uns hier aber auf das R Paket {marginaleffects}. Wir haben auch hier eine leichte Abweichung, da ich die obigen Vorhersagen durch die quadratische Funktion bestimmt habe und nicht aus einem Polynomialmodell entnommen habe.

ph Estimate Std. Error z Pr(>|z|) S 2.5 % 97.5 %

-1 -4.545 2.48 -1.830 0.0673 3.9 -9.41 0.324

2 8.951 2.23 4.013 <0.001 14.0 4.58 13.323

6 -0.545 2.36 -0.231 0.8176 0.3 -5.18 4.089

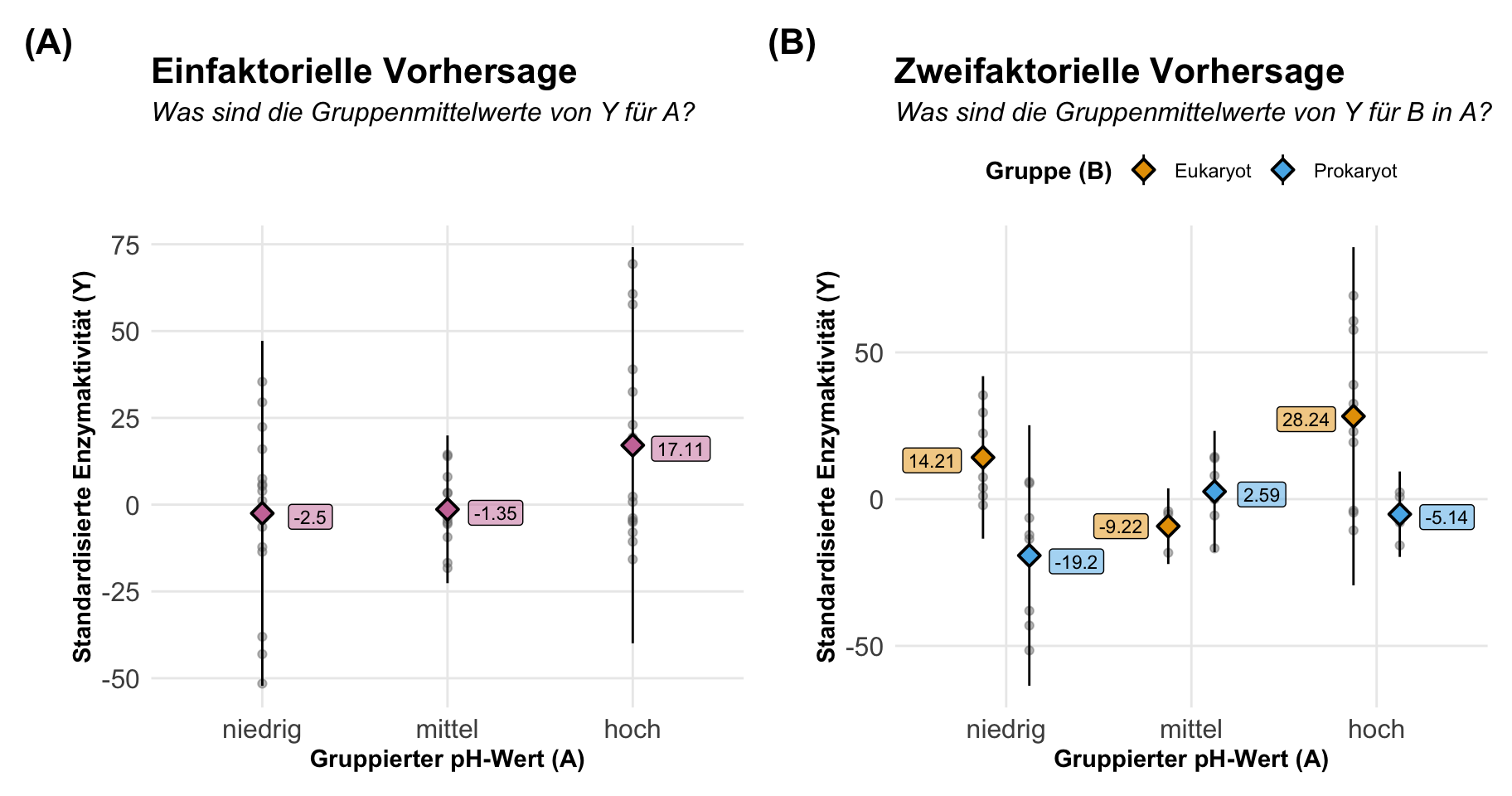

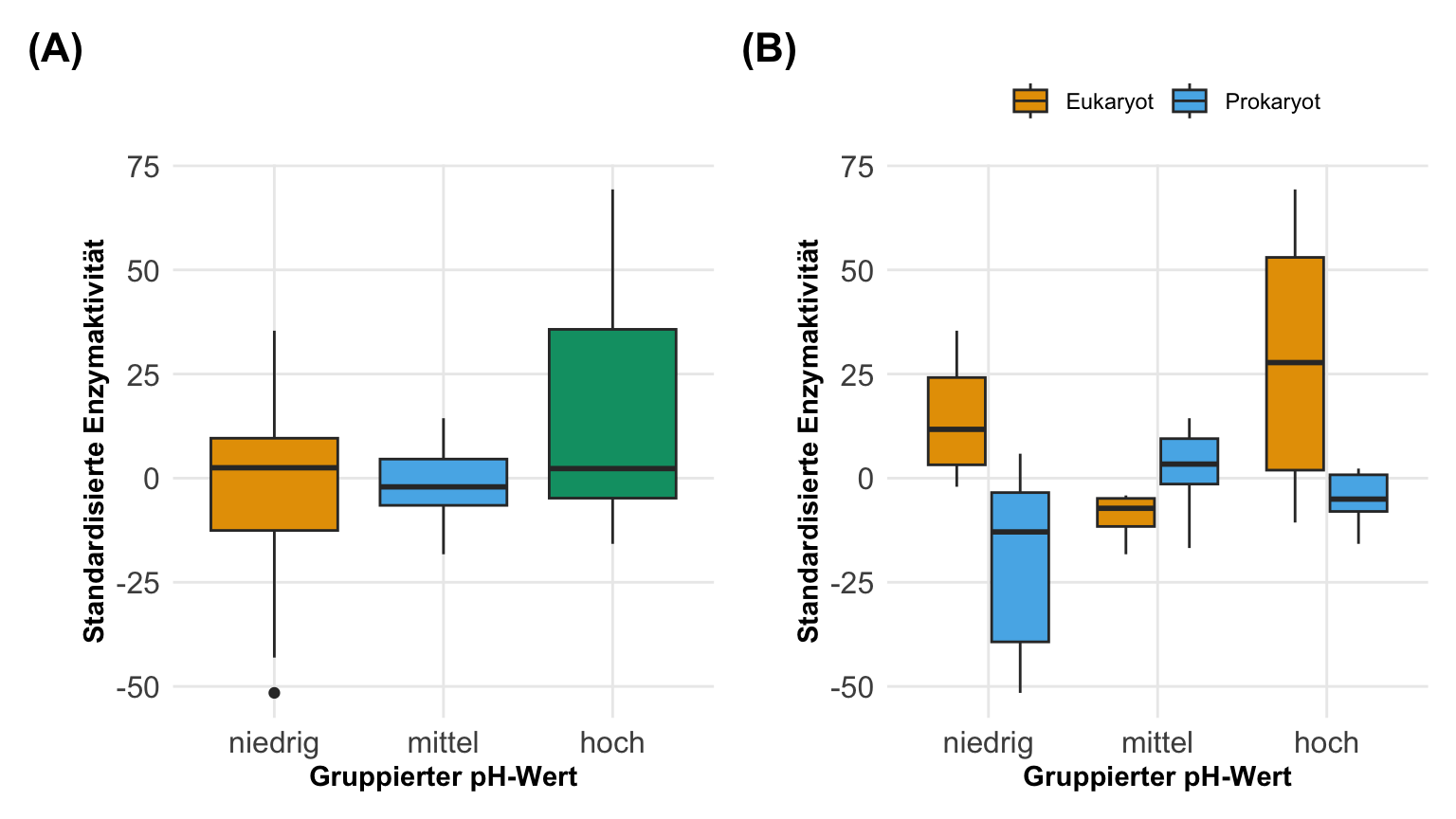

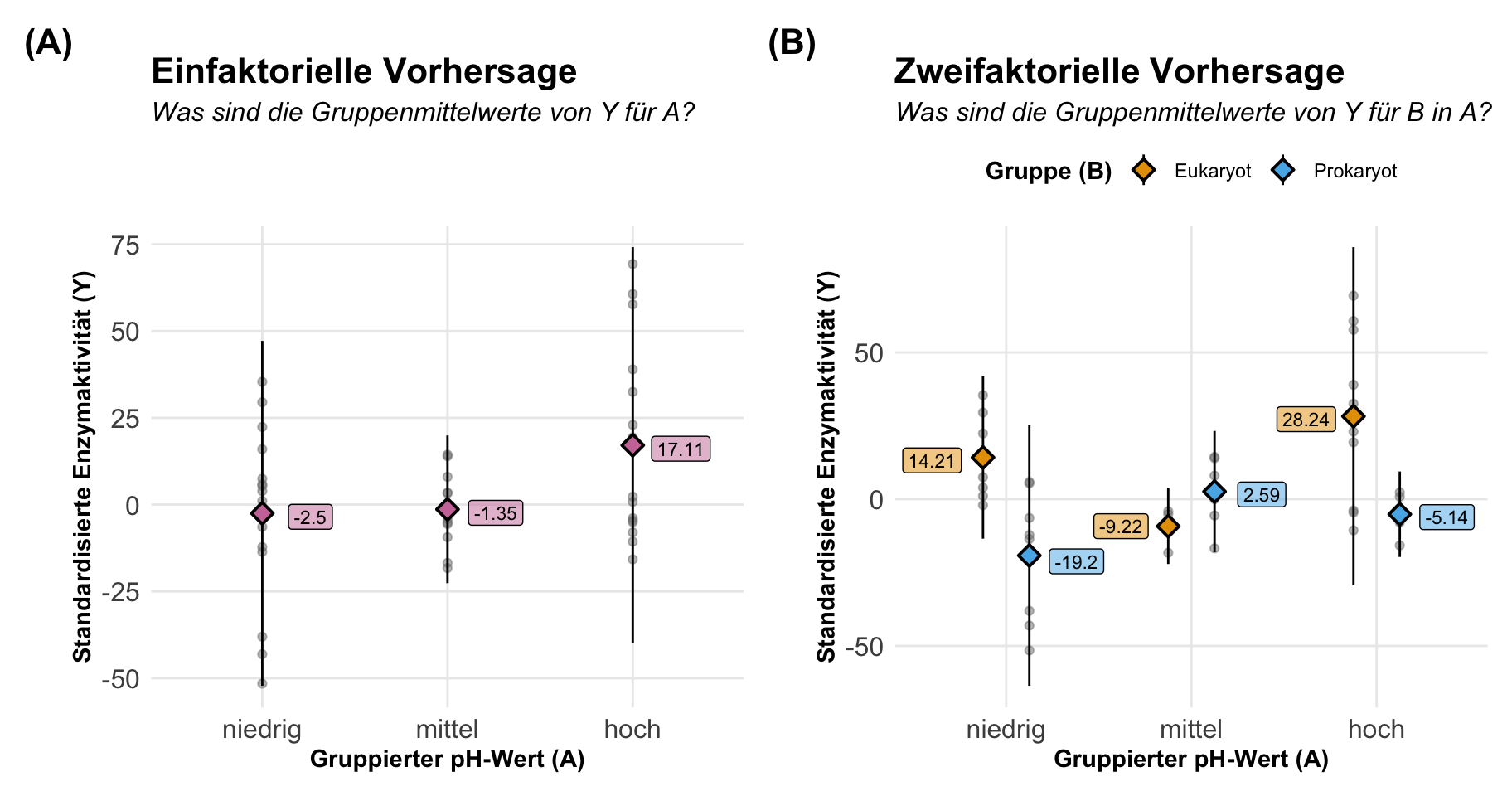

Type: responseWenn wir die Vorhersage betrachten dann können wir auch den Fall vorliegen haben, dass wir ein kategoriales \(X\) mit Gruppen gemessen haben. In R wäre es dann ein Faktor und daher dann auch der Begriff des faktoriellen Designs, wenn es um das experimentelle Design geht. Wir hatten bis jetzt ein kontinuierlichen pH-Wert vorliegen. Zwar hatten wir auch Messgruppen, aber wir konnten von einem konitnuierlichen pH-Wert im Sinne der Modellierung ausgehen. Jetzt wollen wir uns einmal den Fall anschauen, dass wir auf eben wirkliche pH-Wertgruppen mit niedrigen, mittleren und hohen pH-Wertgruppen für die Enzymaktivität vergleichen wollen. Ich schreibe hier schon gleiche von einem Vergleich, als erstes wollen wir aber die Mittelwerte pro Gruppe vorhersagen.

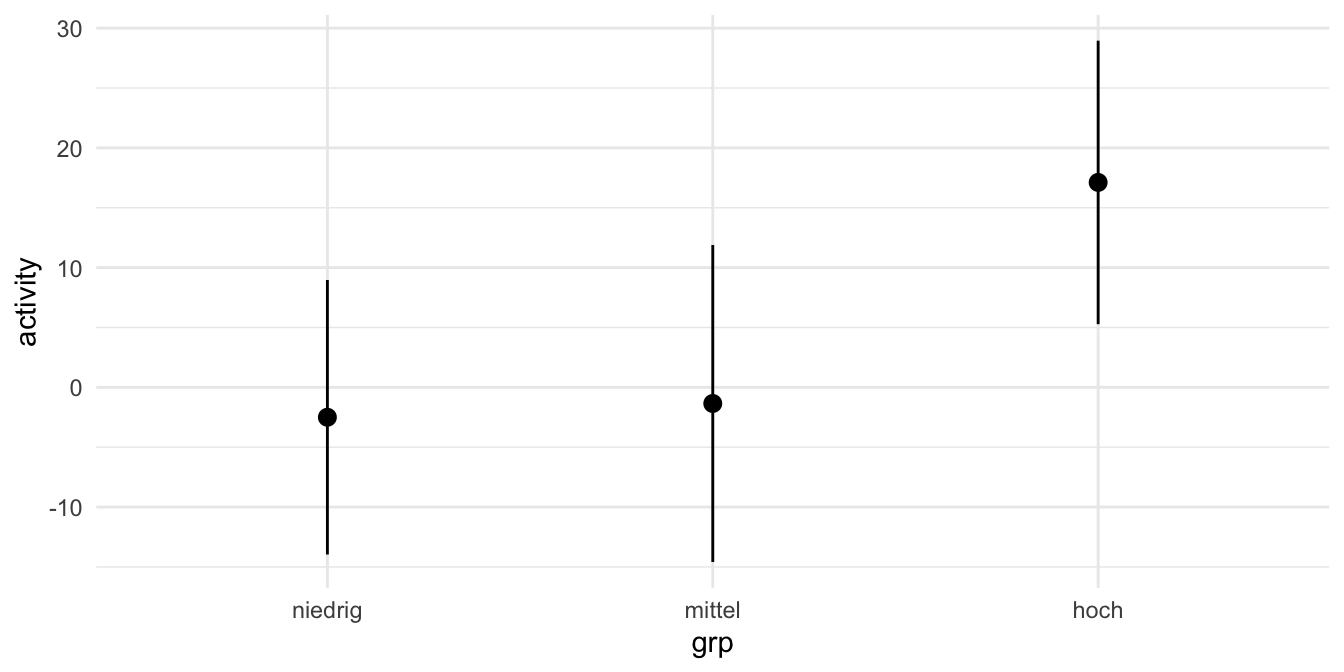

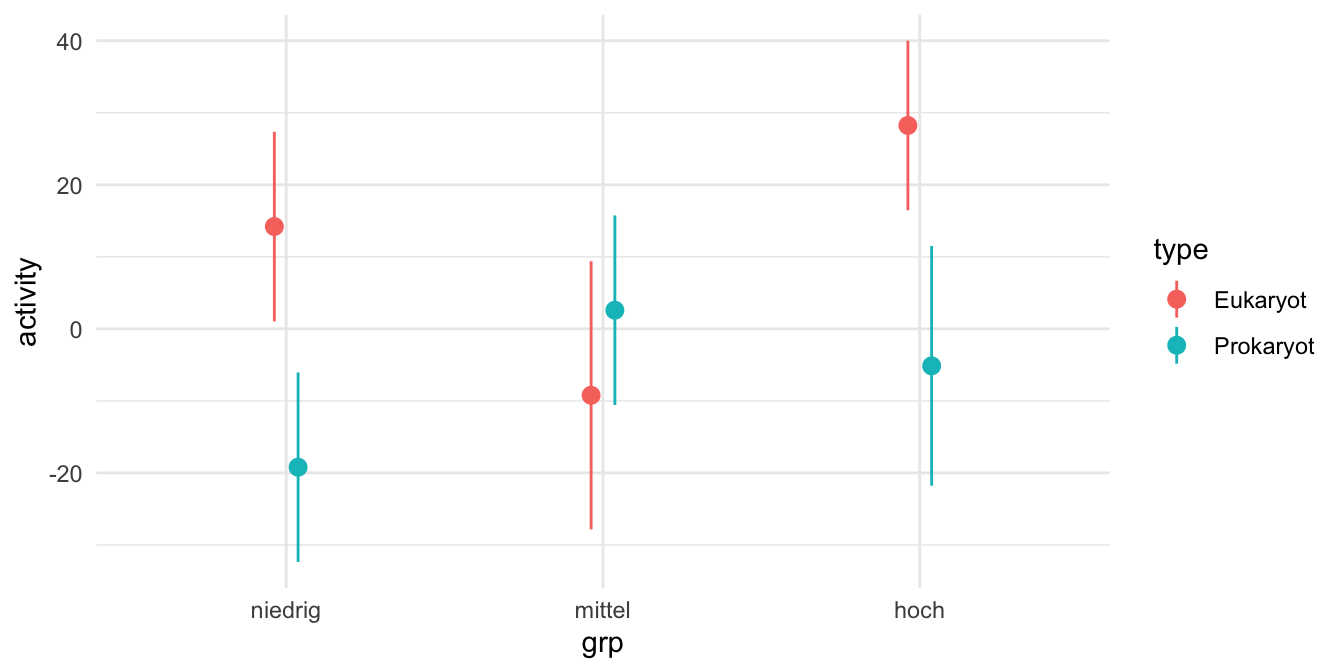

In der folgenden Abbildung siehst du auf der linken Seite einmal den einfaktoriellen Fall mit dem gruppierten pH-Wert als Gruppe. Auf der rechten Seite dann noch zusätzlich die beiden Gruppen der Prokaryoten sowie Eukaryoten. Wir sind jetzt an den Mittelwerten pro Gruppe interessiert und wir könnten diese Mittelwerte dann auch einfach berechnen. Dafür bräuchten wir dann erstmal kein Modell, wenn wir nur so ein simples Experiment vorliegen haben. Konkret bestimmen wir hier die marginal means aus einem Modell heraus.

Wir wollen jetzt für alle Gruppen die Mittelwerte vorhersagen. Nichts anderes macht dann auch die Funktion predictions(). Hier muss ich auch schon gleich einmal eine leichte Warnung aussprechen. So gut {marginaleffects} in der Bestimmung der Steigung und der Vorhersagen ist, um so viel besser ist das R Paket {emmeans} wenn es um die Auswertung von einem faktoriellen Design geht. Hier ist dann einfach {emmeans} besser in der Anwendung. Das hat auch Gründe im Algorithmus der beiden Pakete, dazu dann aber später mehr. Hier erstmal die Interpretation der beiden Vorhersagen für kategoriale \(x\)-Werte oder eben auch Faktoren in R genannt.

Wir haben hier also in unserem einfaktoriellen Modell einmal die gruppierten pH-Werte in den Gruppen niedrig, mittel und hoch vorliegen. Wir wollen dann den Mittelwert für jede der Gruppen bestimmen.

| pH | Mittelwert | Interpretation |

|---|---|---|

| niedrig | 3.2 | Für die Gruppe der niedrigen pH-Werte haben wir im Mittel eine Enzymaktivität von 3.2U vorliegen. |

| mittel | 2.59 | Für die Gruppe der mittleren pH-Werte haben wir im Durchschnitt eine Enzymaktivität von 2.59U vorliegen. |

| hoch | -5.6 | Für die Gruppe der hohen pH-Werte haben wir im Mittel eine Enzymaktivität von -5.9U vorliegen. |

Jetzt können wir uns auch mit der Funktion predictions() aus dem R Paket {marginaleffects} die Mittelwerte für die Gruppen vorhersagen lassen. Wir erhalten dann auch die entsprechenden Standardfehler und andere statistische Maßzahlen. Hier kriegen wir noch keinen Vergleich, hier wird nur getestet, ob der Mittelwert sich von der Null unterscheidet.

grp Estimate Std. Error z Pr(>|z|) S 2.5 % 97.5 %

niedrig -2.50 3.99 -0.626 0.531 0.9 -10.32 5.327

mittel -1.35 1.06 -1.276 0.202 2.3 -3.42 0.722

hoch 17.11 4.91 3.483 <0.001 11.0 7.48 26.745

Type: responseKommen wir nun zu der Vorhersage der Mittelwerte oder Marginal means in den gruppierten pH-Werten aufgeteilt nach den beiden Gruppen der Prokaryoten sowie Eukaryonten. Daher haben wir hier ein zweifaktorielles Design vorliegen. Wir wollen eben die Mittelwerte für alle Faktorkombinationen wissen.

| pH | Gruppe | Mittelwert | Interpretation |

|---|---|---|---|

| niedrig | Eukaryot | 14.21 | Für die Gruppe der niedrigen pH-Werte der Eukaryoten haben wir im Mittel eine Enzymaktivität von 14.21U vorliegen. |

| niedrig | Prokaryot | -19.2 | Für die Gruppe der niedrigen pH-Werte der Prokaryoten haben wir im Mittel eine Enzymaktivität von -19.2U vorliegen. |

| mittel | Eukaryot | -9.22 | Für die Gruppe der mittleren pH-Werte der Eukaryoten haben wir im Mittel eine Enzymaktivität von -9.22U vorliegen. |

| mittel | Prokaryot | 2.59 | Für die Gruppe der mittleren pH-Werte der Prokaryoten haben wir im Mittel eine Enzymaktivität von 2.59U vorliegen. |

| hoch | Eukaryot | 26.24 | Für die Gruppe der hohen pH-Werte der Eukaryoten haben wir im Mittel eine Enzymaktivität von 26.24U vorliegen. |

| hoch | Prokaryot | -5.14 | Für die Gruppe der hohen pH-Werte der Prokaryoten haben wir im Mittel eine Enzymaktivität von -5.14U vorliegen. |

Wenn wir dann die Funktion predictions() aus dem R Paket {marginaleffects} benutzen erhalten wir dann auch die Marginal means für alle Faktorkombinationen zurück. Hier sind die Werte die gleichen wir auch in der simplen Berechnung oben in der Abbildung, da unser Modell eben dann doch nur die beiden Faktoren enthält. Wir erhalten dann auch die Standardfehler und den p-Wert für den Test gegen einen Mittelwert von Null.

grp type Estimate Std. Error z Pr(>|z|) S 2.5 % 97.5 %

niedrig Eukaryot 14.21 0.5498 25.84 <0.001 486.6 13.129 15.28

niedrig Prokaryot -19.20 4.1190 -4.66 <0.001 18.3 -27.277 -11.13

mittel Eukaryot -9.22 0.0325 -283.79 <0.001 Inf -9.286 -9.16

mittel Prokaryot 2.59 1.2580 2.06 0.0396 4.7 0.123 5.05

hoch Eukaryot 28.24 13.4263 2.10 0.0354 4.8 1.924 54.55

hoch Prokaryot -5.14 0.5571 -9.22 <0.001 64.9 -6.228 -4.04

Type: responseSoviel dann einmal zu dem allgemeinen Hintergrund. Die Idee der Marginal effect models ist es also dir die Steigung einer Funktion oder die vorhergesagten Werte einer Funktion wiederzugeben. Hier kannst du dann Funktion auch mit Modell erstetzen. Für den linearen Fall auf einem normalverteilten Messwert ist die Anwendung und der Erkenntnisgewinn der Marginal effect models begrenzt. Da reichen dann auch die Ausgaben der Standardfunktionen. Aber auch dort werden wir dann noch in den entsprechenden Kapiteln sehen, dass wir hier noch was rausholen können. Die Marginal effect models entwicklen dann ihre Stärke für nicht normalverteilte Messwerte sowie eben nicht lineare Zusammenhänge.

Wir oben schon erwähnt, kann dieses Kapitel nicht alle Themen der Marginal effects models abarbeiten. Daher präsentiere ich hier eine Liste von Literatur und Links, die mich für dieses Kapitel hier inspiriert haben. Nicht alles habe ich genutzt, aber vielleicht ist für dich was dabei.

- Ohne den Blogpost Marginalia: A guide to figuring out what the heck marginal effects, marginal slopes, average marginal effects, marginal effects at the mean, and all these other marginal things are von Heiss (2022) wäre dieses Kapitel nicht möglich gewesen.

- Der Blogpost Marginal and conditional effects for GLMMs with

{marginaleffects}liefert nochmal Einblicke in die Möglichkeiten auch die Marginal effect models auf lineare gemischte Modelle anzuwenden. - Wie alles im Leben ist nichts ohne Kritik. Is least squares means (lsmeans) statistical nonsense? ist dann auch eine gute Frage. Ich bin der Meinung nein und auch andere sind es, aber hier kannst du dann nochmal eine andere Meinung lesen.

54.2 Theoretischer Hintergrund

“What he says?” — Asterix, Sieg über Caesar

Soweit so gut. Wenn du verstanden hast, was die Marginal effect models können, dann kannst du auch bei den Daten und deren Auswertung weitermachen. Hier geht es dann etwas tiefer und ich gehe nochmal auf einzelne Aspekte etwas ausführlicher ein. So wollen wir nochmal verstehen, was eigentlich die Steigung nochmal war und wie wir die Steigung berechnen. Dann müssen wir nochmal über simple und multiple Modelle sprechen. Dann gehen wir nochmal auf die Vorhersage ein und ich gebe nochmal einen kurzen Überblick, was wir da eigentlich alles vorhersagen oder genauer was wie heißt. Dann besprechen wir nochmal die Unterschiede zwischen den Paketen {marginaleffects} und {emmeans}. Wie immer kann man den Teil hier auch überspringen, wenn es nur um die Anwendung geht.

Was ist die Steigung?

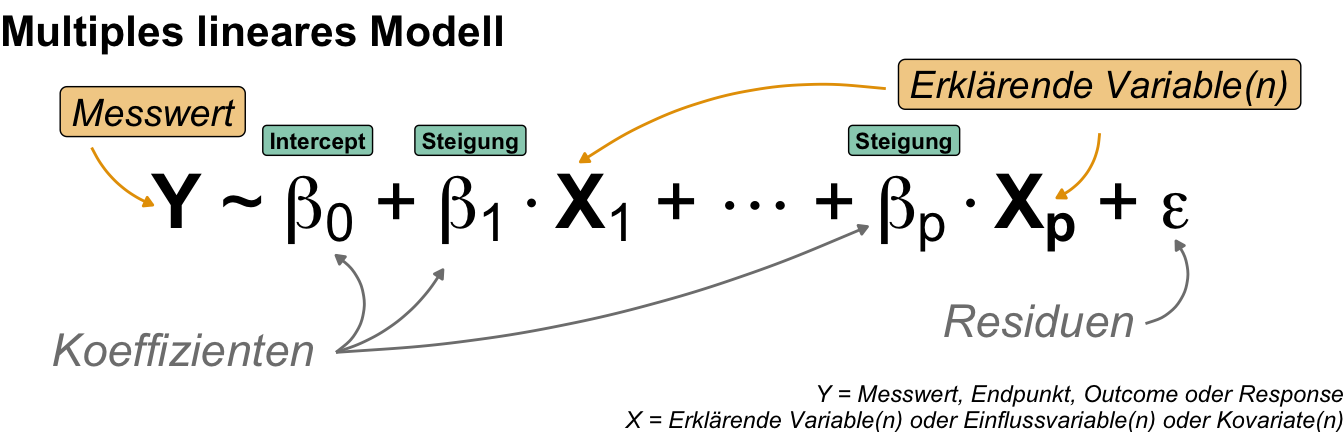

Wenn wir mit dem Verstehen und Zerforschen der Steigung vorankommen wollen, dann können wir Heiss (2022) und Arel-Bundock et al. (2024) mit der Veröffentlichung Model to meaning — How to Interpret Statistical Models With marginaleffects for R and Python nicht ignorieren. Ich nutze jetzt eine etwas allgemeinere Erklärung der Marginal effect models und konzentriere mich erstmal auf ein normalverteilte Kovariate \(c_1\) sowie ein normalverteiltes \(y\) in einem simplen Modell mit einem \(c_1\) und einem \(y\) in der folgenden Form.

\[ y \sim \beta_0 + \beta_1 c_1 \] mit

- \(\beta_0\), dem Koeffizienten des y-Achsenabschnitt oder Intercept der Geraden.

- \(\beta_1\), dem Koeffizienten der Steigung der Geraden

Daher haben wir hier in unserer Kovariate \(c_1\) keine Gruppen vorliegen sondern einen klassischen Scatterplot mit Punkten als Beobachtungen. Wir können die Marginal effect models auch auf beliebige Faktoren wie eben Behandlungsgruppen sowie jedes beliebige \(y\) anwenden, aber hier fangen wir einmal einfach an.

- Welche Frage wollen wir mit Marginal effect models beantworten?

-

Wenn sich die Kovariate \(c_1\) um einen Wert oder eine Einheit erhöht, um wieviele Einheiten verändert sich dann der Wert von \(y\)?

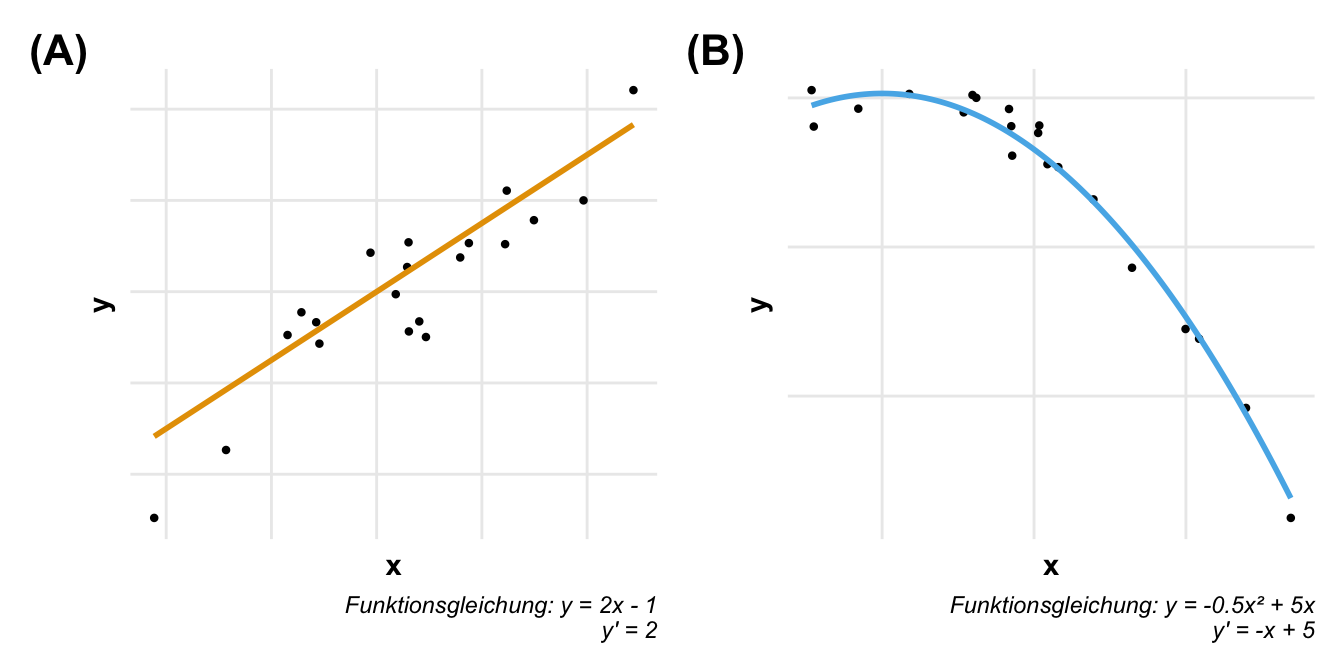

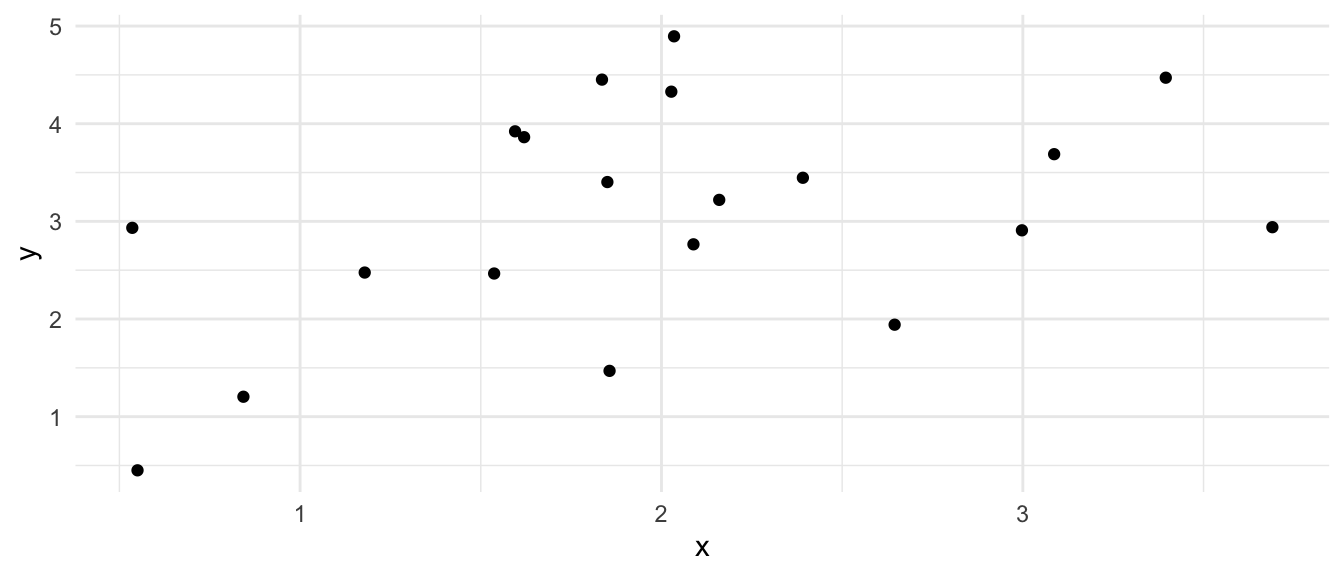

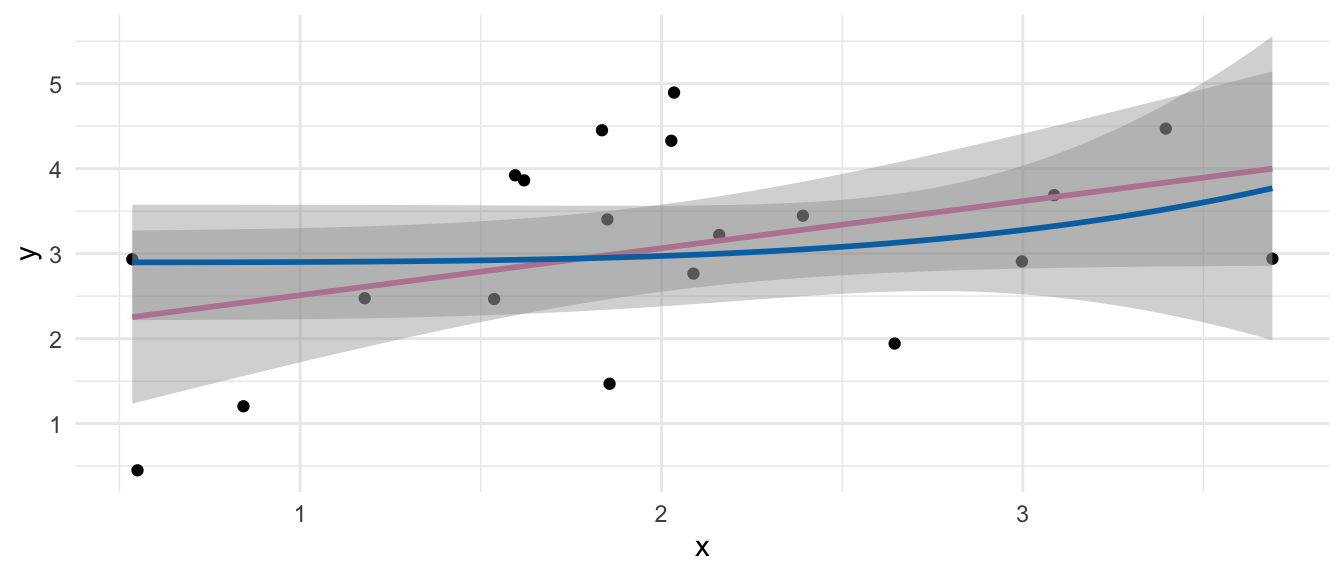

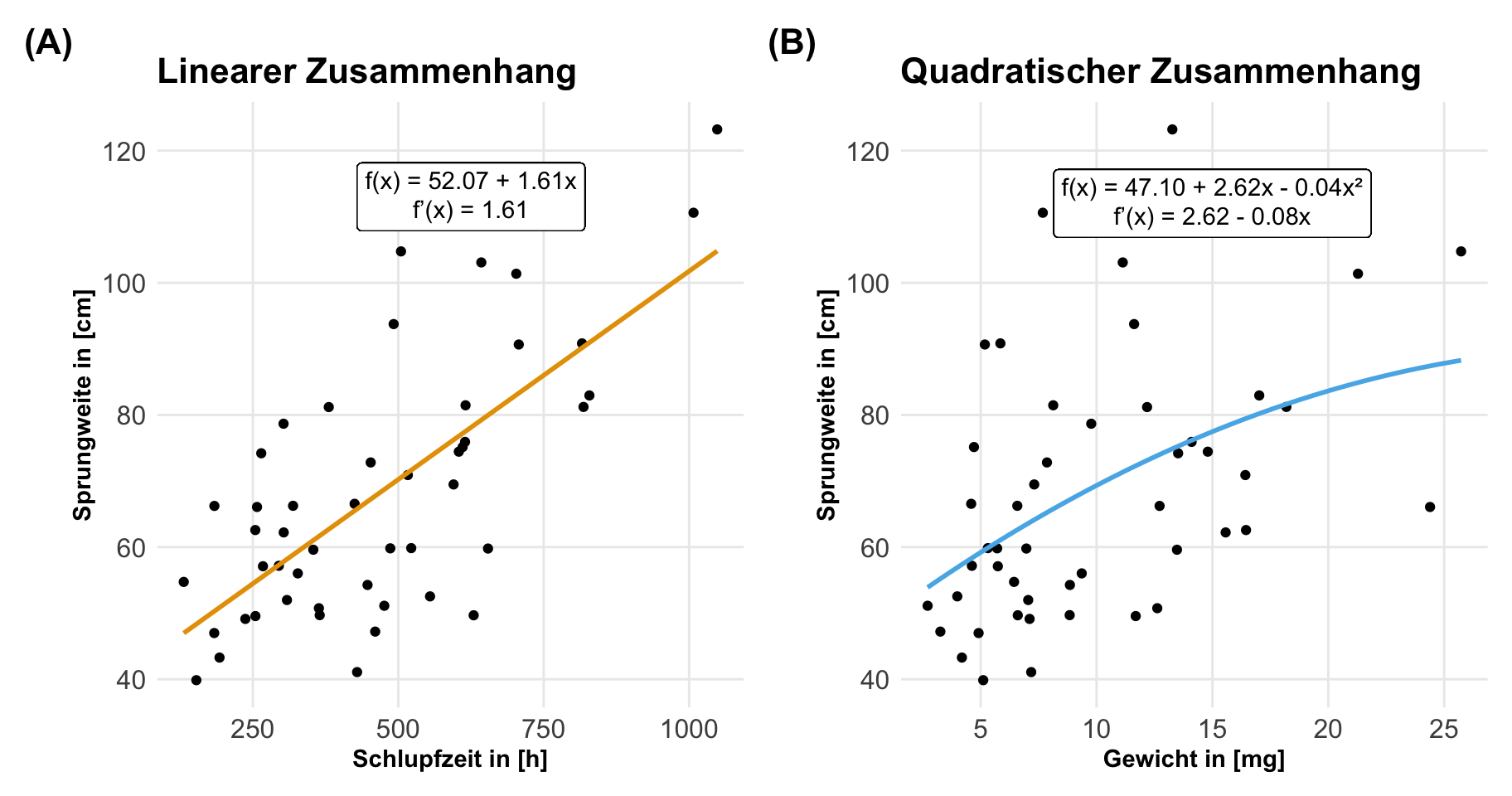

In der folgenden Abbildung siehst du einmal zwei Scatterplots. In dem linken Scatterplot haben wir einen linearen Zusammenhang zwischen unseren \(c_1\)-Werten der Kovariate und den \(y\)-Werten. Wir können sagen, dass wenn sich die Kovariate um einen Wert erhöht, dann erhöht sich auch \(y\) um einen konstanten Wert. Dieser konstante Wert um den sich die \(y\)-Werte mit ansteigenden \(c_1\) erhöhen, nennen wir auch die Steigung \(\beta_1\). In einem linearen Zusammenhang ist die Frage damit mit der Steigung der Geraden eigentlich beantwortet. Steigt die Kovariate um einen Wert, dann steigt \(y\) um den Wert der Steigung \(\beta_1\) der Geraden. Diesen konstanten Zusammenhang haben wir aber nicht bei einem quadratischen Zusammenhang wie in der rechten Abbildung. Wir können hier nicht sagen, dass wenn sich die Kovariate um einen Wert erhöht, sich auch \(y\) um einen konstanten Wert ändert. Hier hängt es von dem betrachteten \(c_1\)-Wert ab.

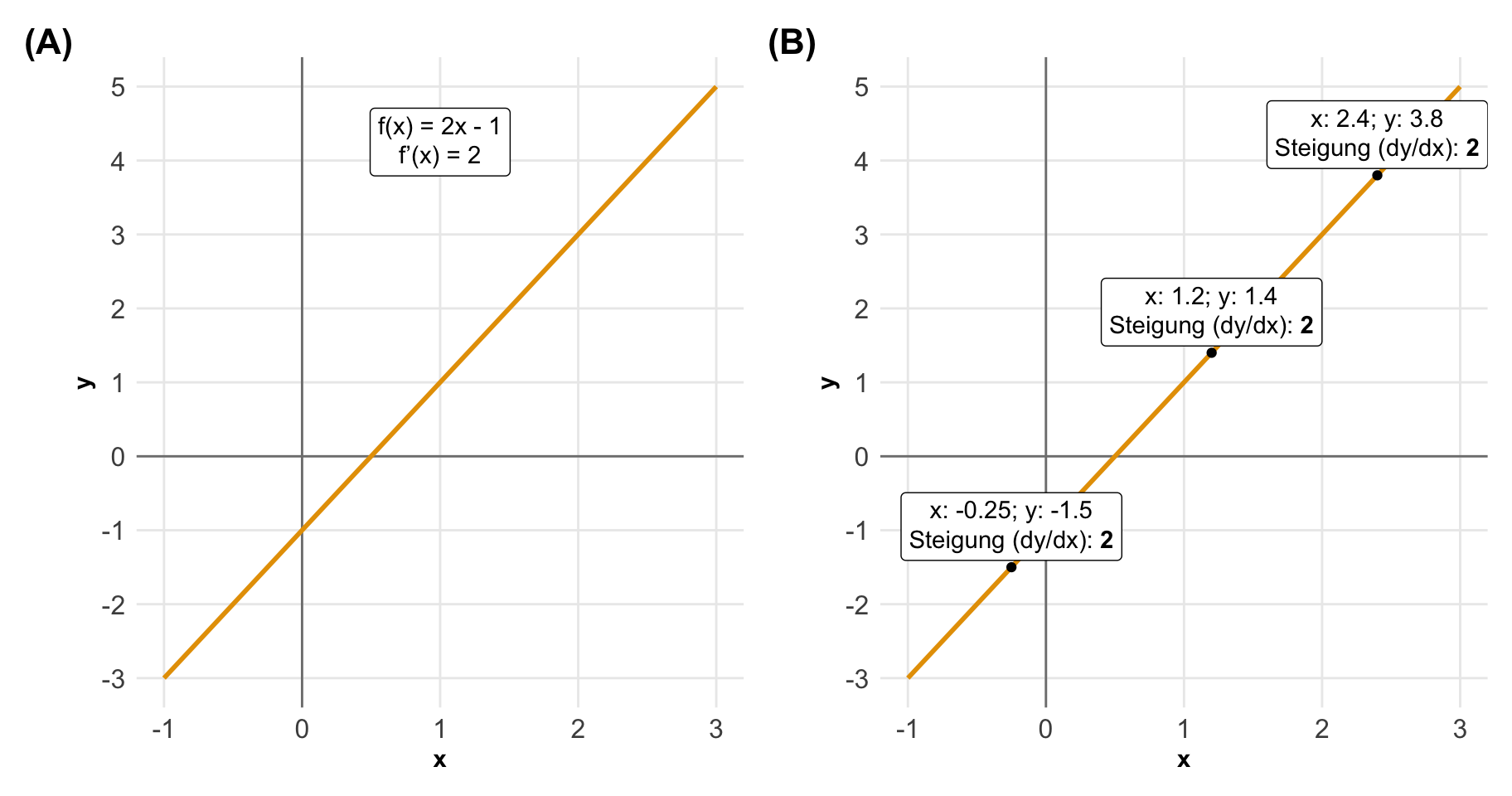

Schauen wir mal in ein Zahlenbeispiel und lassen die Beobachtungen weg. Beginnen wir einmal mit dem linearen Zusammenhang der Funktion \(f(x) = 2x-1\). Ich habe die Gerade einmal in der folgenden Abbildung eingezeichnet. Wenn uns jetzt die Steigung an jedem beliebigen Punkt von \(c_1\) interessiert, dann bilden wir die erste Abbleitung \(f'(x) = 2\). Erhöht sich also der Wert von der Kovariate um 1 dann steigt der Wert von \(y\) um 2 an. Wir sehen aber auch, dass für jedes beliebige Punktepaar wir eine Steigung von 2 vorliegen haben.

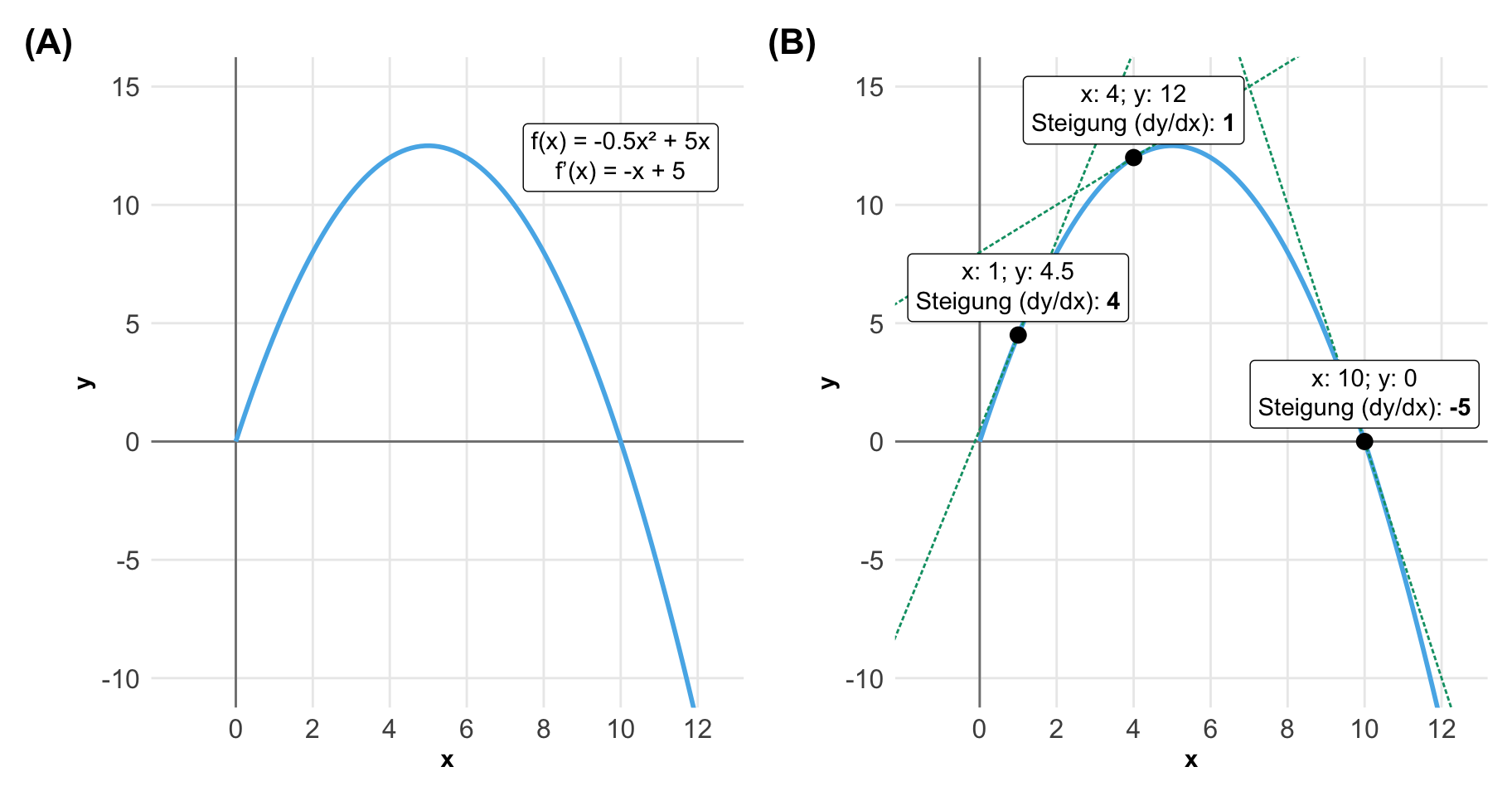

Spanndender wird die Sachlage in einem quadratischen Zusammenhang in der folgenden Abbildung. Oder allgemeiner gesprochen, wenn wir keinen linearen Zusammenhang vorliegen haben. Wir haben hier den Zusammenhgang \(f(x) = -0.5x^2+5x\) vorliegen. Damit haben wir dann eine erste Ableitung von \(f'(x) = x+5\). Wie du siehst, ändert sich auch die Steigung in Abhänigkeit von \(x\). Wenn wir die Werte der Kovariaten links betrachten, dann liegt hier eher eine positive Steigung vor. Wenn wir nach rechts laufen, dann sehen wir immer stärkere negative Steigungen. Und hier kommen dann die Marginal effect models ins Spiel. Wir können allgemein gesprochen uns mit den Marginal effect models für jeden Wert der Kovariate die Steigung wiedergeben lassen.

Aber Moment, denkst du jetzt, in dem linearen Zusammenhang ist es ja einfach mit der Steigung für jeden beliebigen Wert der Kovariate. Wir erhalten für jeden \(c_1\)-Wert genau die gleiche Steigung. Aber bei den nicht-linearen Zusammenhängen hat ja jeder Wert der Kovariate seine eigene Steigung. Wenn wir viele \(c_1\)-Werte gemessen haben, dann haben wir ja dutzende bis hunderte Steigungen durch ein Marginal effect model ermittelt. Das stimmt und damit kommen wir auch gleich zu dem nächsten Punkt, dem Aggregieren der Daten. Oder wie im folgenden Cartoon richtig dargestellt, müssen wir uns überlegen wie wir den den Durchschnitt der Steigungen berechnen.

Wir haben uns in dem obigen Beispiel nur ein simples Modell mit einer Kovariate angeschaut. Jetzt kann es aber auch sein, dass deine \(x\)-Werte keine kontinuierlichen Messwerte wie das Gewicht oder die Zeit sind, sondern eben ein Gruppen sind. Also du hast verschiedene Düngestufen oder Behandlungsgruppen auf der \(x\)-Achse als Faktoren aufgetragen. Auch dann können wir eine lineare Regression rechnen, eine Linie durch die Punkte legen und anschließend ein Marginal effect model rechnen. Was ist also der Unterschied zwischen einer kontinuierlichen und einem kategoriellen Einflussvariablen? Oder wie uterscheiden sich nochmal Kovariaten von Faktoren?

Unterschied zwischen kontinuierlichen und kategoriale \(x\)-Werte

Wir kennen verschiedene Namen für das Gleiche. So nennen wir dann ein kontinuierliches \(x\) dann auch gerne eine stetige Variable oder intervalskaliert. Nichts destotrotz, wir haben ein \(x\) was in kleinen, marignalen Schritten anwachsen kann. Hier kannst du eben an das Gewicht der Flöhe oder aber Zeiteinheiten sowie das Einkommen denken. Wir verändert sich das \(y\), wenn wir die \(x\)-Werte erhöhen? Wir benennen daher auch die kontinuierliche Einflussvariablen als Kovariaten \(c\).

Auf der anderen Seite haben wir dann kategoriale oder kategorielle \(x\)-Werte. Diese bezeichnen wir dann auch gerne diskret. Wenn wir die Werte von \(x\) ändern, dann springen wir in eine neue Gruppe und es liegt hier eigentlich kein kleiner Schritt vor. Hier haben wir dann eben Düngestufen oder aber Behandlungsgruppen vorliegen. Hier fragen wir uns, wie ändert sich der Wert von \(y\), wenn wir eine Gruppe in \(x\) weiterspringen? Wir benennen dann kategoriale Einflussvariablen als Faktoren \(f\).

In der folgenden Abbildung von Heiss (2022) siehst du nochmal schön den Unterschied dargestellt. Wir haben bei der einer kategorialen Variable einen Schalter. Entweder ist der Schalter an oder eben aus. Im simpelsten Fall haben wir männliche oder eben weibliche Flöhe vorliegen. Das Geschlecht ist somit kategorial. Die Sprungweite oder das Gewicht von Flöhen ist eine kontinuierliche Variable. Wir haben einen Schieberegeler den wir ziemlich fein einstellen können. Mehr dazu im Kapitel zu der simplen linearen Regression.

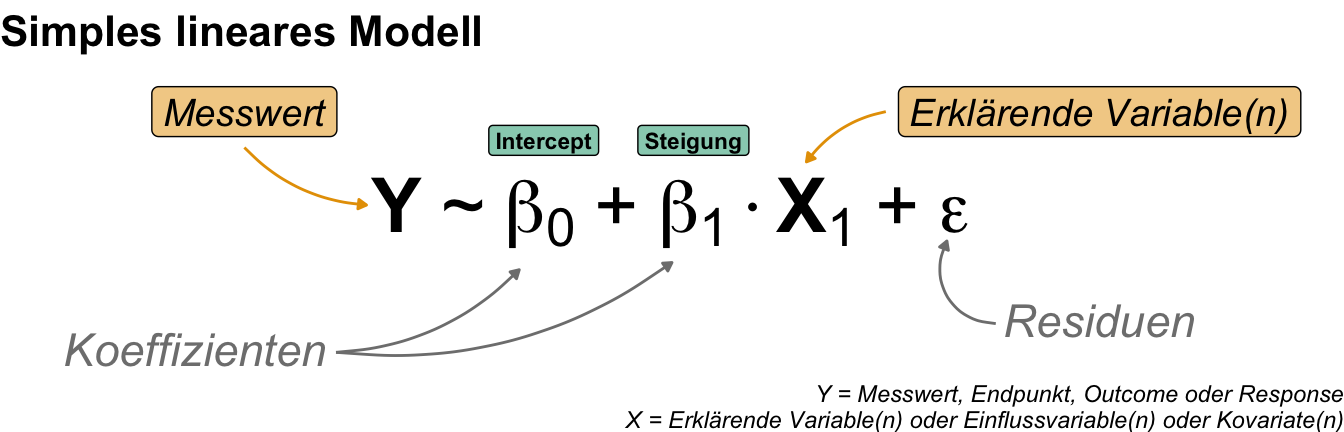

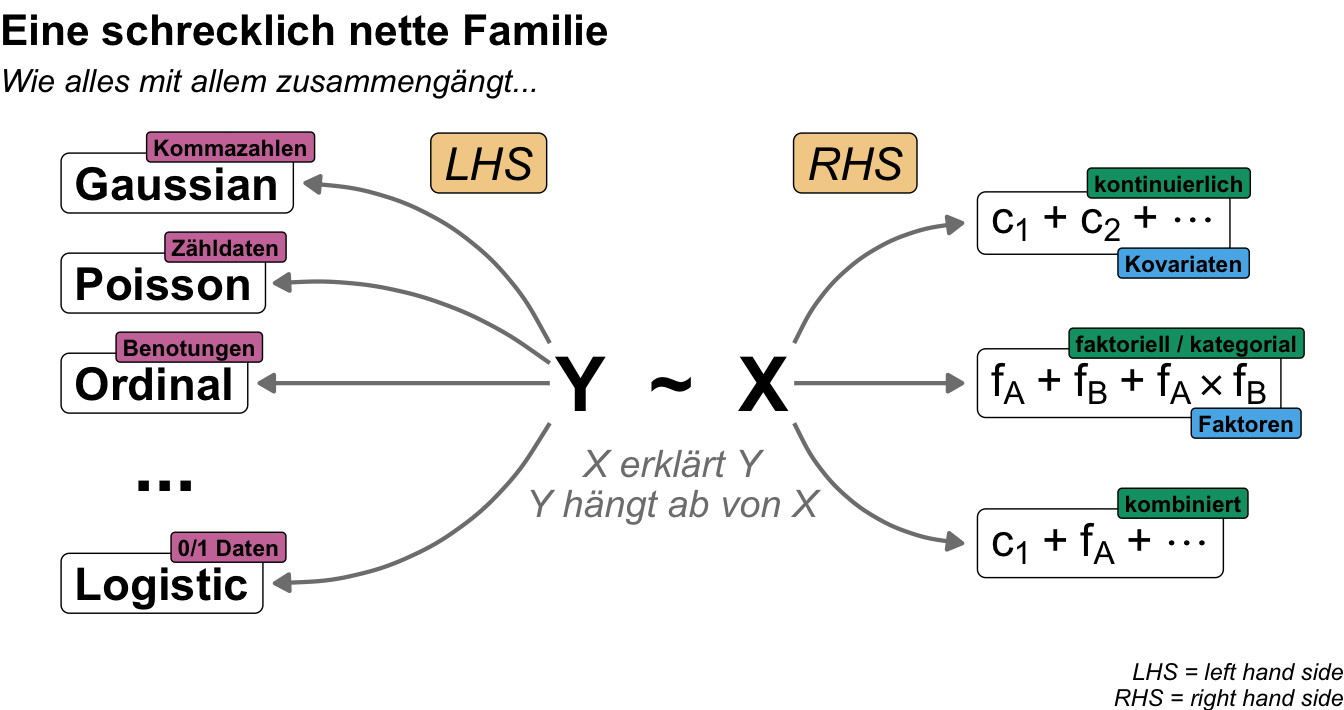

Wir können usn den Schieberegeler auch einmal mathematisch aufschreiben, Wir haben dann unseren Messwert auf der linken Seite und unsere erklärenden Variablen auf der rechten Seite. Unser \(X\) kann dann entweder eine Kovariate oder eben ein Faktor sein.

Als wäre das nicht kompliziert genug, schauen wir uns meistens dann nicht nur eine \(x\) Variable in einem Modell an, die wir dann ändern, sondern eben mehrere. Dann kombinieren wir noch gerne kontinuierliche und kategoriale \(x\)-Werte in einem Modell miteinander und erhalten ein Mischboard. Wir können einiges an Schiebereglern und Schaltern in einem Modell betätigen und erhalten entsprechende andere \(y\)-Werte. Hier helfen dann auch Marginal effect models um mehr Erkenntnisse aus einem Modell zu erhalten. Mehr dazu im Kapitel zu der multiplen linearen Regression.

Wenn wir uns dann eine multiple lineare Regression anschauen, dann haben wir immernoch einen Messwert vorliegen. Wir haben aber jetzt mehr erklärende Variablen, die eben nur Kovariaten oder Faktoren sein können oder eben auch eine Mischung aus beidem. Dann haben wir kombinierte Modelle aus Kovariaten und Faktoren vorliegen.

Somit kommen wir dann hier mal zu einer Definition, wie wir dann die beiden Arten der möglichen \(x\)-Werte als kontinuierliche und kategoriale Werte sprachlich unterscheiden. Wir immer, je nach wissenschaftlichen Hintergrund können sich dann die Namen ändern und anders sein. Das ist dann eben so in der Statistik.

- Marginal effect (deu. marginaler Effekt)

-

Ein marginaler Effekt beschreibt den statistischen Effekt für kontinuierliche erklärende Variablen damit auch die partielle Ableitung einer Variablen in einem Regressionsmodell oder eben den Effekt eines einzelnen Schiebereglers.

- Conditional effect (deu. bedingter Effekt) oder Gruppenkontrast (eng. group contrast)

-

Ein bedingter Effekt beschreibt den statistischen Effekt für kategoriale erklärende Variablen damit auch den Unterschied in den Mittelwerten, wenn eine Bedingung eingeschaltet ist und wenn sie ausgeschaltet ist. Der Effekt eines einzelnen Schalters.

Als wäre das nicht schon kompliziert genug, variieren nicht nur die Einflussvariablen in der Anzahl und dem Typ. Wir haben auch je nach Messwert auch noch andere Eigenschaften unserer linken Seite. Je nach Messwert haben wir eine andere Verteilungsfamilie vorliegen und damit auch eine andere Interpretation unserer Einflussvariablen. In der folgenden Abbildung habe ich dir mal einen Auszuga aus der schreckliche netten Familie der Verteilungsfamilien mitgebracht. Wir sehen hier die Variationsmöglichkeiten in den Einflussvariablen wie auch in den Messwerten.

Unterschied {marginaleffects} und {emmeans}

Wenn wir Marginal effect models rechnen wollen, dann können wir im Prinzip auf zwei große Pakete zurückgreifen. Einmal das R Paket {marginaleffects} sowie das R Paket {emmeans}. Das R Paket {modelbased} setzt sich im Prinzip auf die beiden Pakete drauf und ist mehr oder minder ein Wrapper mit anderen Funktionsnamen. Das ist eigentlich eine gute Idee und ich zeige dann auch nochmal, wie sich das R Paket {modelbased} verhält. Kommen wir erstmal zu dem hauptsächlichen Unterschied zwischen unseren beiden Elefanten.

- Wie unterscheiden sich

{emmeans}und{marginaleffects}? -

Das R Paket

{emmeans}erstellt Durchschnittswerte der Daten und fügt diese Durchschnittswerte dann in Modelle ein. Das R Paket{marginaleffects}fügt alle Werte der Daten in ein Modell ein und erstellt dann Durchschnittswerte aus der Ausgabe des Modells. Am Ende ist es vermutlich dann auch wieder ein nur kleiner Unterschied, der was ausmachen kann. Aber da kommt es dann auf die wissenschaftliche Fragestellung an.

Dabei gibt es noch einen weiteren bedeutenden Unterschied zwischen den beiden Paketen, die sich dann direkt aus der Aggregierung der Daten ableitet. Die Frage ist ja, erst den Mittelwert bilden und dann Modellieren oder umgekehrt. Das R Paket {emmeans} hat als philosophischen Hintergrund experimentelle Daten als Basis. Das R Paket {marginaleffects} hingegen nimmt beobachtete Daten an. Hier möchte ich dann einmal die Vingette des R Pakets {emmeans} zitieren.

“To start off with, we should emphasize that the underpinnings of estimated marginal means – and much of what the

{emmeans}package offers – relate more to experimental data than to observational data. In observational data, we sample from some population, and the goal of statistical analysis is to characterize that population in some way. In contrast, with experimental data, the experimenter controls the environment under which test runs are conducted, and in which responses are observed and recorded. Thus with experimentation, the population is an abstract entity consisting of potential outcomes of test runs made under conditions we enforce, rather than a physical entity that we observe without changing it.” — R Paket{emmeans}

Was will uns nun dieser Text sagen und was bedeutet der Unterschied zwischen experimentellen und beobachteten Daten?

- Wir nutzen

{emmeans}, wenn wir Gruppenvergleiche aus einem experimentellen, faktoriellen Design rechnen wollen. Solche faktorielle Designs sind in den Agrarwissenschaften sehr häufig. - Wir nutzen

{marginaleffects}, wenn wir beobachtete Daten vorliegen haben. Dies ist sehr häufig bei zeitlichen Verläufen der Fall. Wenn wir also wissen wollen, wie ändert sich den Messwert über die Zeit?

Am Ende nutze ich dann in den Gruppebvergleichen immer noch {emmeans}, da das Paket einfach besser zu dem faktoriellen Design passt. Wenn wir uns aber mit Modellen beschäftigen, dann bevorzuge ich das R Paket {marginaleffects}. Oder um es etwas klarer zu sagen, sobald ich eine Kovariate in meinem Modell habe, dann wechsel ich das Paket und rechne alles in {marginaleffecst}. Damit haben wir alles zusammen, um uns jetzt einmal mit der Anwendung der Marginal effect models zu beschäftigen.

54.3 Genutzte R Pakete

Wir wollen folgende R Pakete in diesem Kapitel nutzen.

R Code [zeigen / verbergen]

pacman::p_load(tidyverse, gtsummary, marginaleffects, emmeans, scales,

janitor, ggpmisc, conflicted)

conflicts_prefer(dplyr::mutate)

conflicts_prefer(dplyr::summarize)

conflicts_prefer(dplyr::filter)

conflicts_prefer(ggplot2::annotate)

cb_pal <- c("#000000", "#E69F00", "#56B4E9",

"#009E73", "#F0E442", "#F5C710",

"#0072B2", "#D55E00", "#CC79A7")

##

nice_number <- label_number(style_negative = "minus", accuracy = 0.01)

nice_p <- label_pvalue(prefix = c("p < ", "p = ", "p > "))

find_intercept <- function(x1, y1, slope) {

intercept <- slope * (-x1) + y1

return(intercept)

}An der Seite des Kapitels findest du den Link Quellcode anzeigen, über den du Zugang zum gesamten R-Code dieses Kapitels erhältst.

54.4 Daten

Wir brauchen auch hier nochmal Daten an denen wir uns die Prinzipien der Marginal effect models verstehen können. Ich nutze hier einmal einen simplen Datensatz zu der Enzymaktivität unter verschiedenen pH-Werten. Der Datensatz ist einfach und hat im Prinzip nur die Kovariate pH-Wert, die zwar auch als Faktor gesehen werden kann, aber wir machen es uns hier einfach. Anhand des Beispiels können wir gut die Grundlagen der Marginal effect models nachvollziehen. Als zweiten Datensatz habe ich nochmal die Modellierung von Flöhen mitgebracht. In dem Datensatz zu der Modellierung von Flöhen finden wir viele Kovariaten sowie Faktoren und verschiedene Messwerte, die von Interesse sind. Wir können uns also in dem Datensatz einiges anschauen.

Modellierung von Enzymen

Der Datensatz zu der Enzymaktivität ist ziemlich simple. Wir haben zu verschiedenen pH-Werten die Enzymaktivität gemessen. An jedem pH-Wert haben wir dann bis zu fünfmal wiederholt gemessen. Darüber hinaus haben wir noch drei pH-Wertgruppen gebildet und die Messungen in Prokaryoten sowie Eukaryonten durchgeführt. Die pH-Werte wurden abschließend nochmal standardisiert, so dass die Werte nicht nur im Intervall \({0,14}\) liegen. Mit dem Datensatz lassen sich nun die Steigung und die Vorhersage von der Enzymaktivität sehr gut in Marginal effect models veranschaulichen.

R Code [zeigen / verbergen]

enzyme_tbl <- read_excel("data/enzyme_kinetic.xlsx") |>

mutate(grp = factor(grp, levels = c("niedrig", "mittel", "hoch"))) In der folgenden Tabelle siehst du dann einmal die Daten mit den Messwiederholungen. Später werden wir dann die Enzymaktivität an den pH-Werten mitteln und die pH-Werte als eine Kovariate behandeln. Wenn wir einen Faktor betrachten wollen, dann nehmen wir die gruppierten pH-Werte. Wir werden für die Modellierung die Prokaryoten und Eukaryoten zusammen auswerten.

| ph | activity | grp | type |

|---|---|---|---|

| -2 | -38.05 | niedrig | Prokaryot |

| -2 | -43.07 | niedrig | Prokaryot |

| -2 | -51.55 | niedrig | Prokaryot |

| … | … | … | … |

| 7.5 | 57.68 | hoch | Eukaryot |

| 7.5 | 60.68 | hoch | Eukaryot |

| 7.5 | 69.32 | hoch | Eukaryot |

Dann sehen wir hier nochmal wie oft die Enzymaktivität dann jeweils wiederholt für einen standardisierten pH-Wert gemessen wurde. Wir haben hier keinen Unterschied zwischen den Prokaryoten und Eukaryoten gemacht. Für die Modellierung werden die Prokaryoten und Eukaryoten zusammen betrachtet. Das macht uns dann die Auswertung etwas einfacher.

| ph | n | percent |

|---|---|---|

| -2.0 | 3 | 7.0% |

| -1.0 | 5 | 11.6% |

| 0.0 | 4 | 9.3% |

| 1.0 | 4 | 9.3% |

| 2.0 | 4 | 9.3% |

| 3.0 | 4 | 9.3% |

| 4.0 | 4 | 9.3% |

| 5.0 | 3 | 7.0% |

| 6.0 | 5 | 11.6% |

| 7.0 | 4 | 9.3% |

| 7.5 | 3 | 7.0% |

Da wir hier theoretische Daten vorliegen haben, kennen wir auch die Funktion der Datengenerierung im Hintergrund. Wir haben folgende mathematische Funktion als Grundlage vorliegen. Daraus ergibt sich dann auch die entsprechende erste Ableitung für die Steigung der Tangente entlang der Funktion der Enzymaktivität.

Mit der folgenden Funktion der Enzymaktivität wurden die Daten generiert. Damit ist dann auch die wahre Funktion bekannt.

\[ f(x) = x^3 - 8x^2 + 10x + 10 \]

Mit der wahren Funktion der Enzymaktivität können wir dann auch einfach die erste Ableitung bilden und sind nicht auf eine Modellierung angewiesen.

\[ f'(x) = 3x^2 - 16x + 10 \]

Dann können wir uns auch schon einmal die Abbildungen unseres Datensatzes zu den Enzymaktivität anschauen. Dabei sehen wir sehr gut, wie die Grade durch die Punkte verläuft und dabei eine S-Kurve bildet. Wir haben hier klar keinen linearen Zusammenhang vorliegen und damit ist die Steigung entlang der Graden auch nicht konstant. Wir werden dann weiter unten einmal die Steigung entlang der Graden mit den Marginal effect models analysieren.

Neben der Steigung haben wir noch die Gruppen nach den Prokaryoten und Eukaryoten sowie den ph-Wertgruppen vorliegen. Auch hier können wir dann die Marginal effect models nutzen um mehr über die Unterschiede zwischen den Gruppen zu erfahren. Durch die S-Kurve sehen wir sehr schön, dass auch die Varianz in den pH-Wertgruppen unterschiedlich ist. Je nachdem wie viele ph-Werte zusammengefasst wurden, sind die Werte der Enzymaktivität stark unterschiedlich.

Modellierung von Flöhen

Kommen wir nun zu unserem zweiten komplexeren Datensatz. Wir schauen uns hier die Sprungweiten von Katzenflöhen unter verschiedenen Fütterungebedingungen an. Dabei haben die Katzenflöhe einmal Zuckerwasser, Ketchup sowie Blut als Nahrung erhalten. Als zweiten Faktor betrachten wir dann noch juvenile und adulte Flöhe. Neben diesen beiden Faktoren, haben wir dann noch die Kovariate des Gewichts der Flöhe erhoben. Als weitere Messwerte kommen dann die Schlupfzeiten, die Bonitur der Flöhe, die Anzahl der Haare an einem Flohbein sowie der Infektionsstatus mit Flohschnupfen in Betracht. Teilweise können wir dann die kontinuierlichen Messwerte auch als Kovariaten in unseren Modellen verwenden. Da sind wir ja nicht festgelegt. Wir laden dann die Daten einmal in R und müssen noch etwas die Faktoren anpassen.

R Code [zeigen / verbergen]

flea_model_tbl <- read_excel("data/fleas_model_data.xlsx") |>

mutate(feeding = as_factor(feeding),

stage = as_factor(stage),

bonitur = as.numeric(bonitur),

infected = factor(infected, labels = c("healthy", "infected"))) |>

select(feeding, stage, jump_length, weight, hatched, count_leg, bonitur, infected) Wir haben jetzt hier das Problem, dass die Schlupfzeit in Stunden gemessen wurde, was extrem ungünstig ist, da die Einheiten so große Werte einnimmt. Daher haben wir dann später das Problem, dass eine Stunde Änderung einen sehr kleinen Effekt auf die Sprungweiten hat. Daher habe ich hier einmal die Schlupfzeit auf Wochen umgerechnet, dass macht dann die Effekte auf die Sprungweite größer und besser zu interpretieren.

R Code [zeigen / verbergen]

flea_model_tbl <- flea_model_tbl |>

mutate(hatched = hatched/24/7)Dann können wir uns auch schon mal einen Auszug aus der Datentabelle zu den Sprungweiten der Katzenflöhe anschauen.

| feeding | stage | jump_length | weight | count_leg | hatched | bonitur | infected |

|---|---|---|---|---|---|---|---|

| sugar_water | adult | 77.2 | 16.42 | 63 | 516.41 | 4 | infected |

| sugar_water | adult | 56.25 | 12.62 | 55 | 363.5 | 1 | healthy |

| sugar_water | adult | 73.42 | 15.57 | 112 | 303.01 | 2 | healthy |

| … | … | … | … | … | … | … | … |

| ketchup | juvenile | 83.38 | 7.18 | 423 | 429.18 | 4 | infected |

| ketchup | juvenile | 104.48 | 6.6 | 548 | 629.58 | 5 | infected |

| ketchup | juvenile | 130.18 | 4.19 | 869 | 192.66 | 5 | healthy |

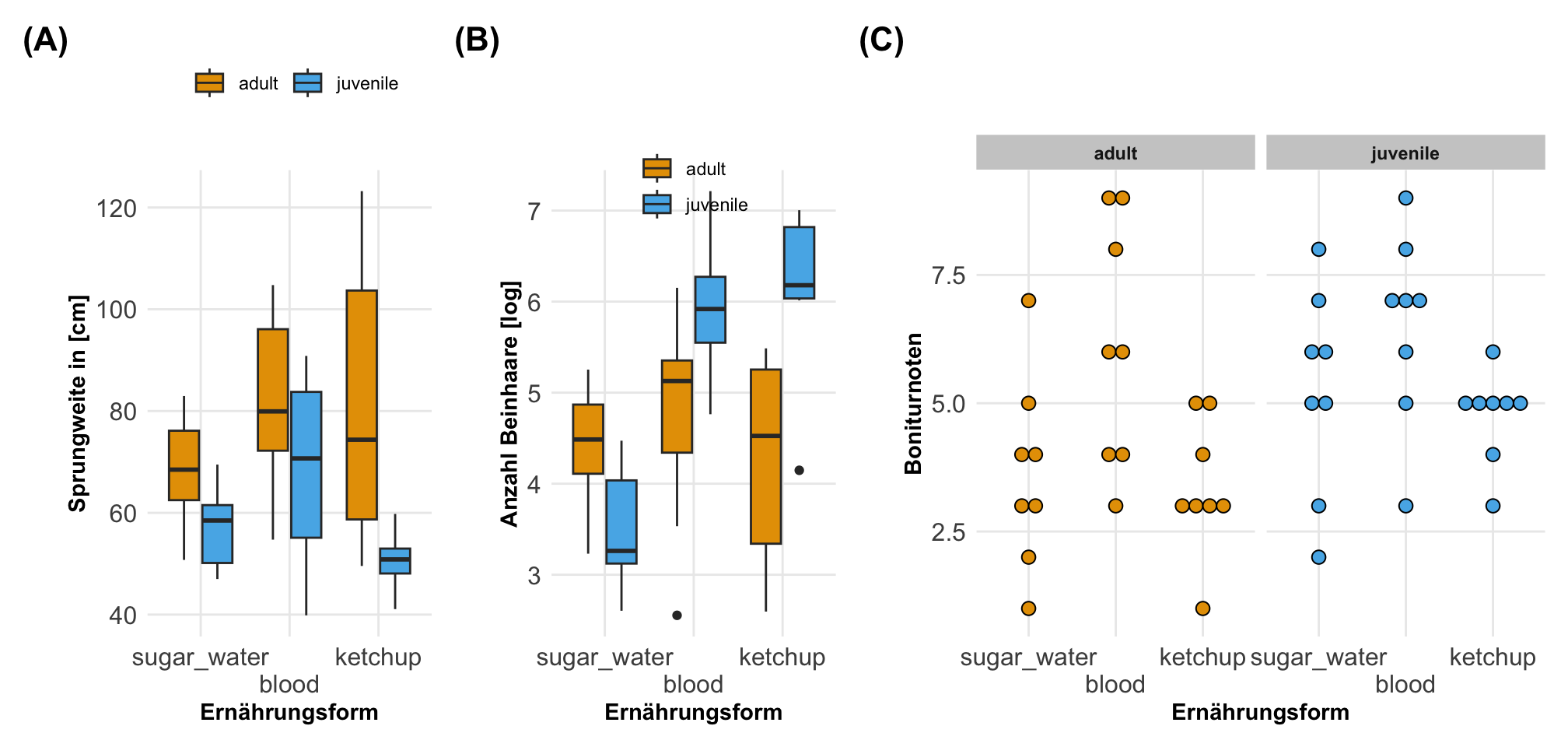

Dann können wir uns einmal ausgewählte Boxplots und Dotplots für die Flohdaten anschauen. Wir sehen hier sehr schön, dass sich die Sprungweiten über die Ernährungsformen und den Entwicklungsständen anscheinend unterschieden. Auch haben wir Effekte in der Anzahl an Beinhaaren. Die Boniturnoten sehen eher etwas gleichmäßiger aus. Die eigentlichen Effekte oder statistischen Tests wollen wir dann auszugsweise in den folgenden Abschnitten einmal rechnen.

Da wir natürlich binäre Messwerte wie den Infektionsstatus mit Flohschnupfen schlecht als eine Abbildung über zwei Faktoren darstellen können, habe ich hier nochmal die klassische Tabelle gewählt. Wir sehen hier einmal wie sich die Anteile an gesunden und kranken Flöhen über die beiden Faktoren verteilen. In beiden Faktoren meint man einen Unterschied zwischen den Infektionen zu erkennen.

| Characteristic | healthy N = 211 |

infected N = 271 |

|---|---|---|

| feeding | ||

| sugar_water | 9 / 21 (43%) | 7 / 27 (26%) |

| blood | 3 / 21 (14%) | 13 / 27 (48%) |

| ketchup | 9 / 21 (43%) | 7 / 27 (26%) |

| stage | ||

| adult | 14 / 21 (67%) | 10 / 27 (37%) |

| juvenile | 7 / 21 (33%) | 17 / 27 (63%) |

| 1 n / N (%) | ||

In den folgenden Abschnitten werden wir dann immer wieder Teile der Flohdaten nutzen um die Marginal effect models besser zu verstehen und anzuwenden. Ich werde nicht den ganzen Datensatz auswerten sondern immer wieder schauen, welcher Teilaspekte mehr von Interesse sind.

54.5 Visualisierung von Modellen

In dem folgenden Abschnitten wollen wir immer Modell in unsere Visualisierungen einzeichen. Nehmen wir einmal einen simplen Datensatz, den wir uns einfach selber bauen und dann wollen wir dort eine Linie durchzeichnen. Dafür nehmen wir einmal zwanzig x-Werte und bauen uns dann die y-Werte nach \(y = 1.5 + 0.75 \cdot x\) zusammen. Dann addieren wir noch einen Fehler aus einer Standardnormalverteilung hinzu. Wenn wir keinen Fehler hinzuaddieren würden, dann lägen die Punkte wie auf einer Perlenschnur aneinandergereit.

R Code [zeigen / verbergen]

set.seed(20250703)

modell_line_tbl <- tibble(x = rnorm(20, 2, 1),

y = 1.5 + 0.75 * x + rnorm(length(x), 0, 1))Jetzt können wir einmal das Modell anpassen und schauen, ob wir die Koeffizienten des Modells wiederfinden. Dann wollen wir natürlich auch sehen, ob unser Modell durch die Punkte läuft. Also erstmal das Modell mit lm() gebaut. Dann schauen wir uns noch die Koeffizienten einmal mit an. Bei nur so wenigen Beobachtungen werden die Koeffizienten aus dem Modell nicht mit den voreingestellten übereinstimmen.

R Code [zeigen / verbergen]

model_fit <- lm(y ~ x, modell_line_tbl)

model_fit

Call:

lm(formula = y ~ x, data = modell_line_tbl)

Coefficients:

(Intercept) x

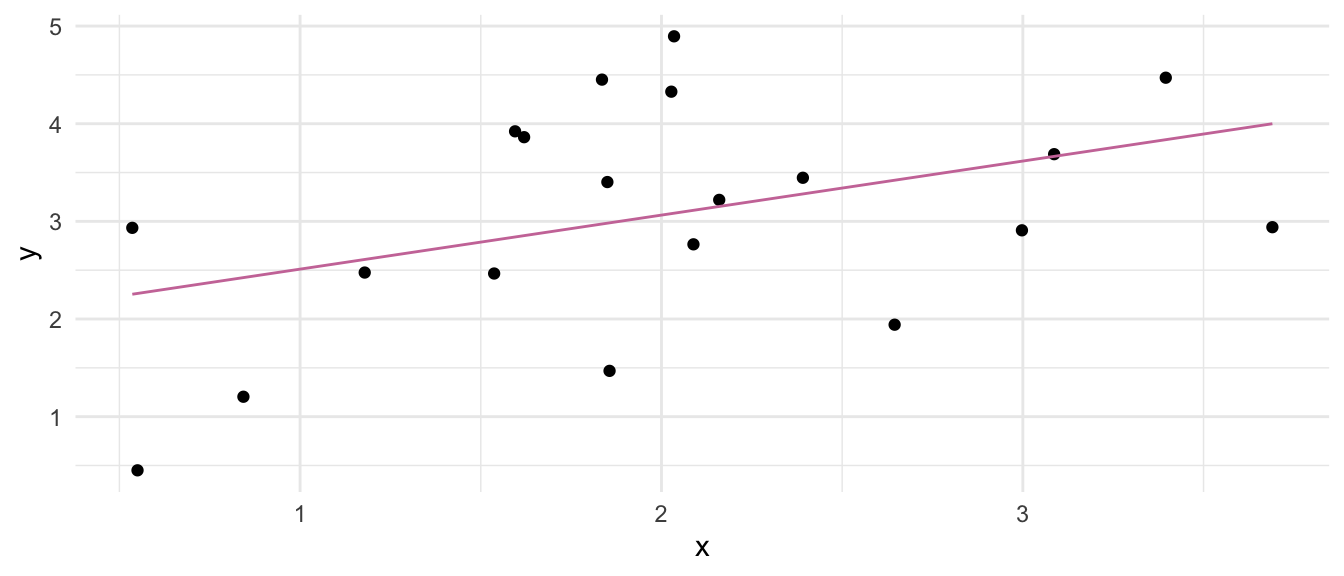

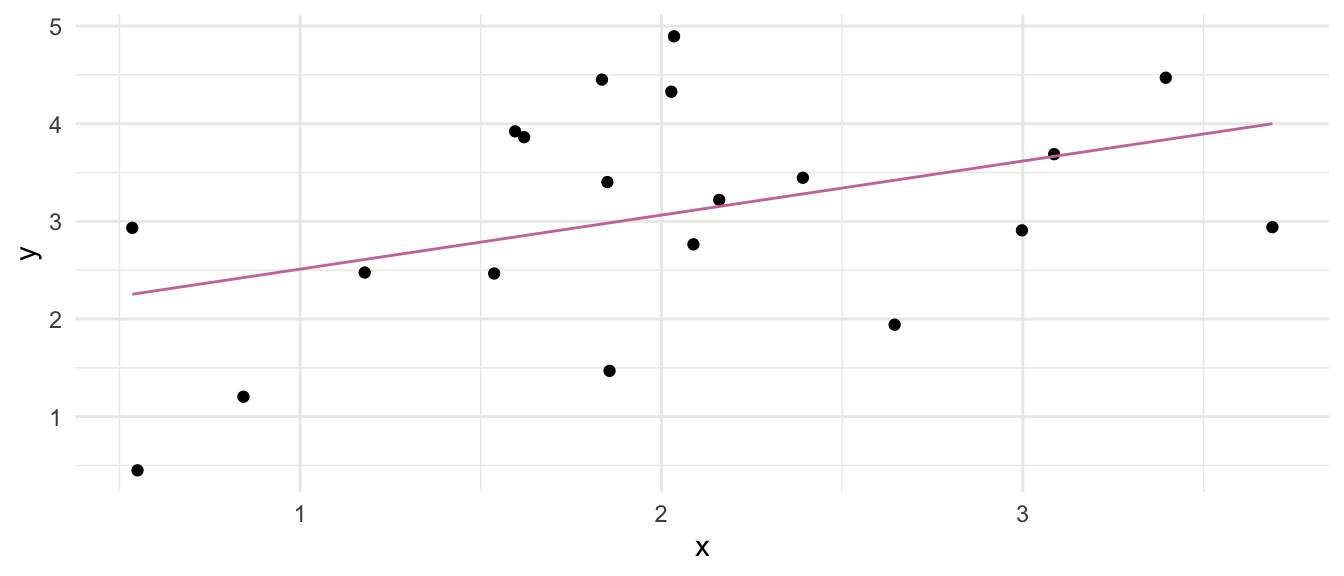

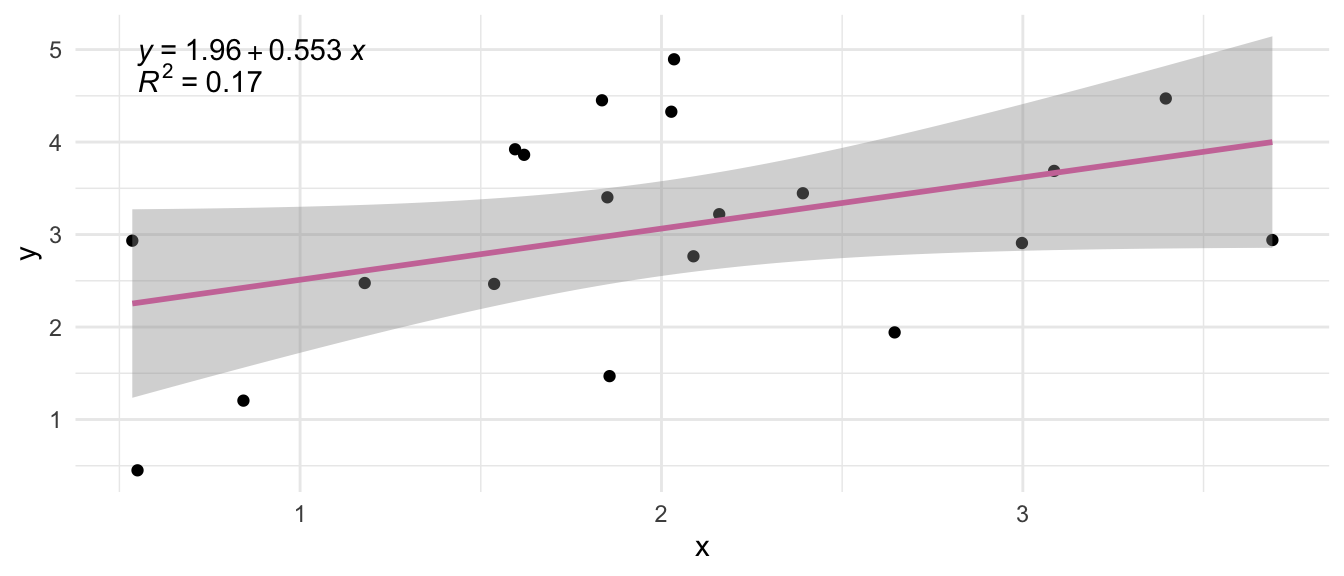

1.9574 0.5534 In der folgenden Abbildung siehst du dann einmal den Scatterplot von unseren x-Werten und y-Werten. Wir wollen jetzt die Gerade, die wir im Modell geschätzt haben einmal durch die Punkte legen um zu schauen, ob das Modell auch die Punkte beschreibt. Dabei soll die Gerade durch die Mitte der Punkte laufen und die Punkte sollten auf beiden Seiten der Geraden gleichmäßig verteilt sein.

Wir haben jetzt verschiedene Möglichkeiten die Koeffizienten und damit das Modell in den obigen Plot einzuzeichnen. Ich zeige dir hier einmal die häufigsten, die ich dann auch nutze. Erstmal die Anwendung direkt in {ggplot} und dann einmal noch in dem R Paket {ggpmisc}.

…mit {ggplot}

In der Funktion geom_function() müssen wir die Funktion angeben, die wir dann abbilden wollen. Wenn du verstehst, was die Koeffizienten in dem Modell bedeuten, dann kannst du natürlich die mathematische Funktion wie hier entsprechend ergänzen.

R Code [zeigen / verbergen]

ggplot(modell_line_tbl, aes(x, y)) +

theme_minimal() +

geom_point() +

geom_function(fun = \(x) 1.9574 + 0.5534 * x,

color = "#CC79A7")Manchmal ist das Modell zu komplex, dass wir die mathematische Funktion einfach aufschreiben könnten. In dem Fall hilft die Funktion geom_line() die wir dann die vorhergesagten y-Werte mit der Funktion predict() aus dem Modell übergeben. Das funktioniert auch sehr gut.

R Code [zeigen / verbergen]

ggplot(modell_line_tbl, aes(x, y)) +

theme_minimal() +

geom_point() +

geom_line(aes(y = predict(model_fit)),

color = "#CC79A7")Abschließend können wir auch einfach so eine Gerade durch die Punkte legen indem wir die Funktion geom_smooth() als eine Art der Glättung nutzen. Aber hier muss ich sagen, dass uns dann die Geradengleichung fehlt. So mal zum gucken ist das wunderbar. Du kannst über die Option formula auch eine Funktion übergeben. Darüber hinaus erhalten wir dann noch einen Fehlerbalken des Standardfehlers, was in manchen Fällen nützlich ist. Wenn du die Geradengleichung brauchst, dann schaue einmal in dem Paket {ggpmisc} rein.

R Code [zeigen / verbergen]

ggplot(modell_line_tbl, aes(x, y)) +

theme_minimal() +

geom_point() +

geom_smooth(method = "lm", color = "#CC79A7") +

geom_smooth(method = "lm", formula = y ~ I(x^4),

color = "#0072B2")…mit {ggpmisc}

Ich möchte hier nich zu sehr in die Tiefe von {ggpmisc} gehen, aber das Paket verbindet im Prinzip die Funktion geom_smooth() mit der Wiedergabe der Informationen zu den Regressionsgleichungen. Du findest bei StackOverflow einmal eine schöne Übersicht in Add regression line equation and R^2 on graph. Wenn du mehr willst, dann schaue dir einmal die Hilfeseite von {ggpmisc} mit Fitted-Model-Based Annotations näher an. Es geht echt eine Menge, von dem ich hier nur einmal den Klassiker zeige. Wir wollen einmal die Regressionsgleichung plus das Bestimmtheitsmaß einzeichnen. Das geht über drei Funktionen zusammen mit der Regressionsgeraden.

R Code [zeigen / verbergen]

ggplot(modell_line_tbl, aes(x, y)) +

theme_minimal() +

geom_point() +

stat_poly_line(color = "#CC79A7") +

stat_poly_eq(use_label("eq")) +

stat_poly_eq(label.y = 0.9) 54.6 Datenraster

Was ist ein Datenraster (eng. data grid) eigentlich? Wir brauchen die Idee des Datenrasters um überhaupt die Vorhersagen, die Steigung und die kontrafaktischen Vergleiche zu verstehen. Im Prinzip beinhaltet das Datenraster die Information zu welchen Beobachtungen wir eine Vorhersage machen oder die Steigung berechnen wollen. Wenn wir nochmal kurz zu dem Enyzmbeispiel kommen, zu welchen pH-Werten möchtest du dann eine Steigung oder aber eine Vorhersage der Enzymaktivität haben? Beginnen wir mit einem einfachen Beispiel um zu verstehen was die einzelnen Datenraster aussagen wollen. In Folgenden siehst du einmal einen kleinen Datensatz mit einer numerischen Variable, einer dichotomen Variable sowie einer Variable mit drei Kategorien. So ähnlich haben wir ja auch Datensätze in echt vorliegen.

R Code [zeigen / verbergen]

set.seed(20250709)

grid_tbl <- tibble(numerisch = rnorm(n = 8),

dichotom = rbinom(n = 8, size = 1, prob = 0.5),

kategorial = sample(c("niedrig", "mittel", "hoch"),

size = 8, replace = TRUE))Wir wollen uns nun einmal anhand des simplen Beispiels verschiedene Datenraster einmal anschauen und verstehen, was wir dann eigentlich damit machen. Im Prinzip kannst du dir ein Datenraster so vorstellen, dass wir fixe Werte für die Einflussvariablen definieren für die wir dann eine Aussage zu den Messwerten aus dem Modell haben wollen.

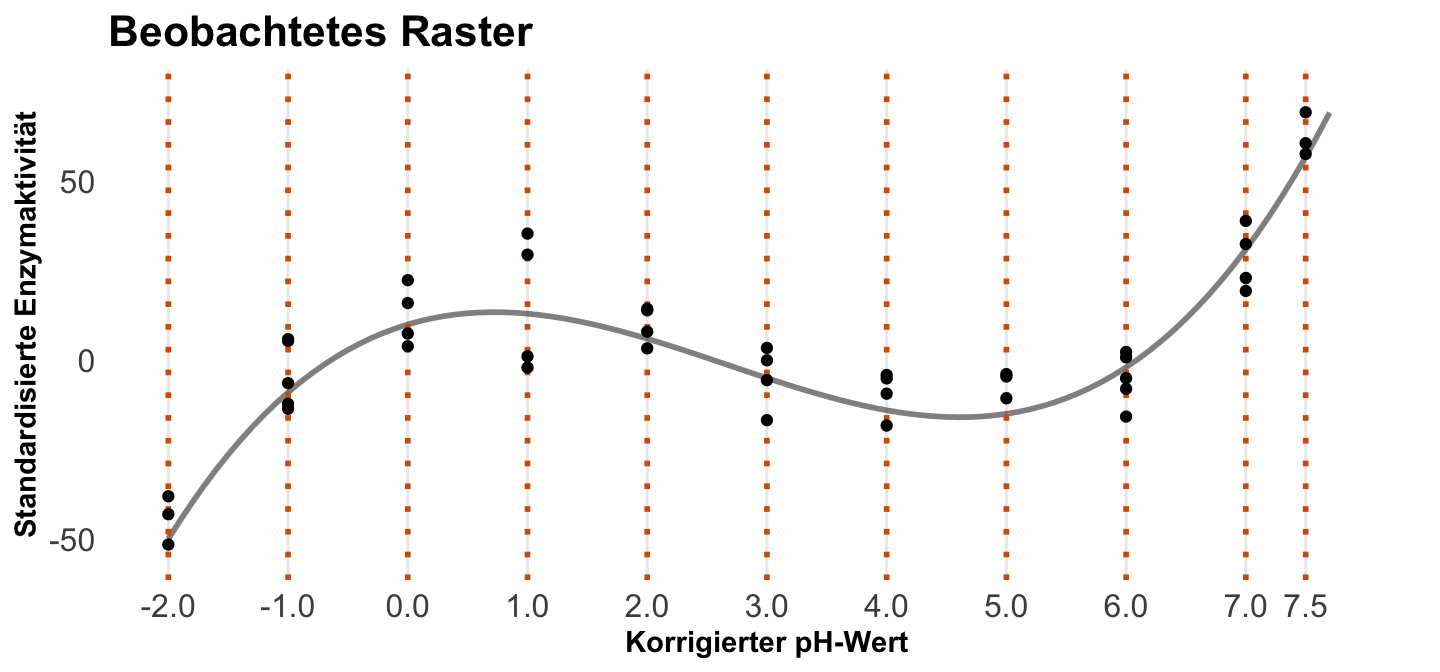

Beobachtetes Raster (eng. empirical grid)

Das beobachte Raster (eng. empirical grid) ist das einfachste Raster. Wir nehmen nämlich alle Beobachtungen, die wir im originalen Datensatz haben und berechnen dafür jeweils die Vorhersagen oder die Steigungen. Das heißt wir nutzen jede Einflussvariablenkombination, die wir dann in den Daten vorliegen haben. Im Sinne des Beispiels, ist es eben dann der Datensatz so wie er ist.

R Code [zeigen / verbergen]

grid_tbl |> tt()| numerisch | dichotom | kategorial |

|---|---|---|

| 0.32260788 | 1 | niedrig |

| 0.64136316 | 1 | hoch |

| -0.81802243 | 1 | mittel |

| -1.46551819 | 0 | mittel |

| -0.01230531 | 1 | mittel |

| -1.61493276 | 0 | mittel |

| -0.82683177 | 0 | mittel |

| 0.76328096 | 1 | hoch |

In der folgenden Beobachtung siehst du das beobachtete Raster nochmal für die Daten der Enzymaktivität. Wir wollen für die pH-Werte in den Daten zum Beispiel jeweils die Enzymaktivität vorhersagen. Also welche Werte liegen auf der modellierten Grade? Hier wählen wir keine pH-Werte aus, sondern nehmen einfach alle. Ob das so Sinn macht ist eine andere Frage, wir müssten auf jeden Fall irgendwie unsere statistischen Maßzahlen zusammenfassen, sonst erhalten wir sehr viele Zahlen zurück.

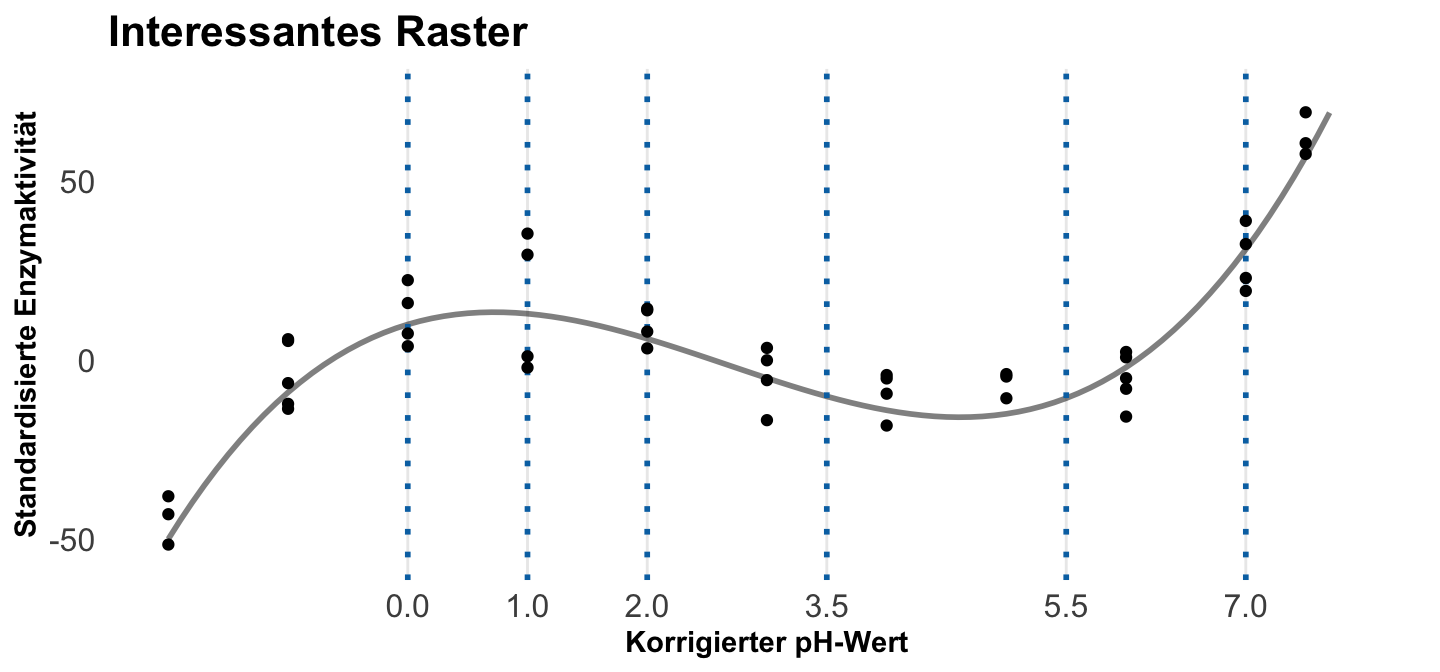

Interessantes Raster (eng. interesting grid)

Beim interessanten Raster (eng. interesting grid) nutzen wir nur die Werte einer oder mehrere Einflussvariablen, die uns dann wirklich interessieren. Dafür können wir dann das Datenraster so aufbauen, dass wir nur die für uns interessanten Werte mit ins Raster schreiben. Hier wollen wir die beiden Werte für die diochotome Variable einmal haben. Wenn wir nichts machen, dann erhalten wir dann die Mittelwerte für die numerische Variable und den Modus, also den häufigsten Wert, für die kategoriale Variable.

R Code [zeigen / verbergen]

datagrid(dichotom = c(0, 1), newdata = grid_tbl) |> tt()| numerisch | kategorial | dichotom | rowid |

|---|---|---|---|

| -0.3762948 | mittel | 0 | 1 |

| -0.3762948 | mittel | 1 | 2 |

Das ist natürlich etwas nervig, wenn wir nicht so genau wissen, was eigentlich mit den anderen Variablen passiert. Deshalb ist es hilfreich für die anderen Variablen auch mal anzugeben, was wir eigentlich wollen. Hier nochmal etwas wirrer der Mittelwert der dichotomen Variable und die Reichweite und die einzelnen Werte der kategorialen Variable in einem Raster. Der eigentlich Witz ist hier, dass eben die Funktion datagrid() auch andere Funktionen akzeptiert solange die Funktionen einen Vektor an Zahlen wiedergeben.

R Code [zeigen / verbergen]

datagrid(numerisch = range,

dichotom = mean,

kategorial = unique,

newdata = grid_tbl) |> tt()| numerisch | dichotom | kategorial | rowid |

|---|---|---|---|

| -1.614933 | 0.625 | niedrig | 1 |

| -1.614933 | 0.625 | hoch | 2 |

| -1.614933 | 0.625 | mittel | 3 |

| 0.763281 | 0.625 | niedrig | 4 |

| 0.763281 | 0.625 | hoch | 5 |

| 0.763281 | 0.625 | mittel | 6 |

Das können wir uns in der folgenden Abbildung auch einmal beispielhaft für die Flohdaten anschauen. Wir wollen hier nur die Vorhersage oder die Steigung an bestimmten pH-Werten und nicht über alle pH-Werte hinweg.

Repräsentatives Raster (eng. representative grid)

Das repräsentative Raster (eng. representative grid) dient eigentlich nur einer schnellen Übersicht. Wir erhalten hier eben die Werte an dem Median oder dem Mittelwert. Das ist von Interesse, wenn wir über komplexe Modelle mitteln wollen oder aber eben einen Wert haben wollen ohne ein Raster definieren zu müssen.

R Code [zeigen / verbergen]

datagrid(grid_type = "mean_or_mode", newdata = grid_tbl) |> tt()| numerisch | dichotom | kategorial | rowid |

|---|---|---|---|

| -0.3762948 | 1 | mittel | 1 |

In der folgenden Abbildung siehst du einmal das repräsentative Raster mit dem Mittelwert der pH-Werte als einzigen Wert. Für diesen Wert würden wir dann die Steigung oder aber die Vorhersagen berechnen. Je nachdem wie unser Modell aussieht, ist dass eine mehr oder minder gut Idee.

Balanciertes Raster (eng. balanced grid)

Manchmal brauchen wir auch ein balanciertes Raster in dem Sinne, dass wir jede Faktorkombination einmal vorhanden haben sowie die Mittelwerte der numerischen Einflussvariablen. Wie du im Folgenden siehst ist jede Kombination der dichotomen und kategorialen Variablen vorhanden und wir haben den Mittelwert der numerischen Variable.

R Code [zeigen / verbergen]

datagrid(grid_type = "balanced", newdata = grid_tbl) |> tt()| numerisch | dichotom | kategorial | rowid |

|---|---|---|---|

| -0.3762948 | 0 | hoch | 1 |

| -0.3762948 | 0 | mittel | 2 |

| -0.3762948 | 0 | niedrig | 3 |

| -0.3762948 | 1 | hoch | 4 |

| -0.3762948 | 1 | mittel | 5 |

| -0.3762948 | 1 | niedrig | 6 |

Wozu brauchen wir ein balanciertes Raster? Wir wollen manchmal eben eine Aussage über alle Faktorkombinationen treffen ohne den Modus der Kategorien zu verwenden. Dann macht eben ein balanciertes Raster schon Sinn. Ich habe es hier in den Beispielen nicht gebraucht, aber es ist gut zu wissen, dass wir sowas vorliegen haben.

Kontrafaktisches Raster (eng. counterfactual grid)

Das kontrafaktische Raster (eng. counterfactual grid) ist etwas schwerer zu verstehen. Wir fangen erstmal mit einem kleineren Datensatz an und nehmen uns die ersten fünf Zeilen unseres Spieldatensatzes. Wir sehen diese Daten dann einmal in dem folgenden linken Tab. In dem rechten Tab baue ich dann einmal das kontrafaktische Raster. Das kontrafaktische Raster baut für die Ausprägungen einer Variable alle Kombinationen in einem Raster nach. Wir wollen das hier einmal für unsere dichotome Variable machen.

Zuerst aber einmal unsere beobachteten Daten mit nur fünf Beobachtungen. Das ist hier einmal wichtig, da wir gleich unseren Datensatz durch das kontrafaktische Raster stark vergrößern werden.

R Code [zeigen / verbergen]

cf_tbl <- grid_tbl[1:5,]Wir haben hier also unsere fünf Beobachtungen vorliegen, die alle eine numerische Variable sowie eine kategoriale Variable vorliegen haben. Von Interesse ist gleich die dichotome Variable für die wir das kontrafaktische Raster bauen wollen.

R Code [zeigen / verbergen]

cf_tbl |> tt()| numerisch | dichotom | kategorial |

|---|---|---|

| 0.32260788 | 1 | niedrig |

| 0.64136316 | 1 | hoch |

| -0.81802243 | 1 | mittel |

| -1.46551819 | 0 | mittel |

| -0.01230531 | 1 | mittel |

Wir brauchen einmal die Option grid_type = "counterfactual" um uns ein kontrafaktische Raster zu bauen. Dazu kommt dann noch ein Datensatz und die Variable über die das kontrafaktische Raster gebaut werden soll. Wie wir gleich sehen, hat unser Raster doppelt so viele Beobachtungen wie unser ursprünglicher beobachteter Datensatz.

R Code [zeigen / verbergen]

cf_grid <- datagrid(

dichotom = c(0, 1),

grid_type = "counterfactual",

newdata = cf_tbl)

nrow(cf_grid )[1] 10Schauen wir uns einmal das kontrafaktische Raster genauer an. Wir sehen, dass wir für jede Ausprägung der dichotomen Variable alle Werte der restlichen Variablen einmal gesetzt haben. Wir bauen uns im Prinzip ein Raster bei dem wir so tun, als ob alle Beobachtungen einmal den Wert 0 bei der dichotomen Variable sowie den Wert 1 haben. Daher können wir berechnen, wie die Steigung oder die Vorhersagen sich ändern würden, wenn sich die dichotome Variable von Null auf Eins ändert.

R Code [zeigen / verbergen]

cf_grid |> tt()| rowidcf | numerisch | kategorial | dichotom |

|---|---|---|---|

| 1 | 0.32260788 | niedrig | 0 |

| 2 | 0.64136316 | hoch | 0 |

| 3 | -0.81802243 | mittel | 0 |

| 4 | -1.46551819 | mittel | 0 |

| 5 | -0.01230531 | mittel | 0 |

| 1 | 0.32260788 | niedrig | 1 |

| 2 | 0.64136316 | hoch | 1 |

| 3 | -0.81802243 | mittel | 1 |

| 4 | -1.46551819 | mittel | 1 |

| 5 | -0.01230531 | mittel | 1 |

Das kontrafaktische Raster ist schwerer zu verstehen, wenn wir es nicht in der Anwendung sehen. Dazu dann aber mehr in einem Abschnitt weiter unten. Dort gehe ich dann nochmal auf die direkte Anwendung ein. Hier soll es dann erstmal genug sein mit den Datenrastern. Stell dir einfach die Datenraster als einen zusärtzlichen Datensatz vor, der die Werte der Einflussvariablen beinhaltet, die dich im Bezug auf den Messwert interessieren.

54.7 Steigung (eng. slopes)

“Let us introduce another concept that is likely to get very popular in the near future within the world of regressions. Derivatives.” —

{modelbased}

Beginnen wir einmal mit der Steigung. Das heißt, wir haben hier zumindest ein einkovariates Modell vorliegen. Wir haben auf der x-Achse die Kovariate und dann kann es noch sein, dass wir zusätzlich einen Faktor als gruppierende Variable vorliegen haben. Wenn du mehr als einen Faktor vorliegen hast, dann wird die Sache schon sehr kompliziert. Die Idee ist ja, wie sich die Werte des Messwerts in Abhängigkeit der Kovariate ändern. Darüber hinaus macht die Betrachtung der Steigung erst so richtig Sinn, wenn wir uns mit nicht lineare Modellen beschäftigen. Ansonsten ist die Steigung ja über den ganzen Zahlenraum der Kovariate konstant. Mag auch von Interesse sein, aber die Stärke der Marginal effect models liegt dann doch eher in der Beschreibung der Steigung von nicht linearen Modellen. Fangen wir aber einmal mit den Grundlagen in einem einkovariaten Modell an.

54.7.1 Einkovariates Modell

Im Folgenden schauen wir usn einmal die Modellierung der Flöhe an. Dort betrachten wir dann wie sich die Sprungweiten in Abhängigkeit von der Schlupfdauer verändert. Wir sidn hier wiedrum an der Steigung einer Tangente zu den Zeitpunkten der Schlupfzeiten interessiert. Hier sprechen wir dann auch von der Ableitung (eng. derivative). Die erste Ableitugn liefert uns ja die Steigung der Tangente an dem entsprechenden Punkt. Da wir hier nur ein einkovariates Modell vorliegen haben, müssen wir uns hier noch nicht mit komplexeren Abhängigkeiten rumschlagen.

Modellierung von Flöhen

In der folgenden Abbildung siehst du einmal die Zusammenhänge von der Schlupfzeit und der Sprungweite. In der linken Abbildung ist einmal der lineare Zusammenhang dargestellt. Da wir hier eine Grade zeichnen, haben wir natürlich nur eine Steigung. Die Steigung ist immer \(+10.5\) und damit nimmt die Sprungweite für jede Steigerung der Einheit in den Schlupfzeiten um \(+10.5cm\) zu. Das ist etwas langweilig und in einem linearen Modell benötigen wir auch prinzipiell keine Marginal effect models. Wir können trotzdem eines rechnen und dann von den statistischen Maßzahlen eines Marginal effect models profitieren, aber die Stärke liegt dann eben in dem nicht linearen Modell auf der rechten Seite. Wir haben hier eine S-Kurve und damit auch verschiedene Steigungen entlang der Graden. Das sehen wir dann auch an der ersten Ableitung, die wiederum noch die Kovariate enthält und somit ist die Steigung abhängig von dem Wert der Kovariate der Schlupfzeit.

Schauen wir uns dann nochmal die Mathematik hinter den beiden Modellierungen an. Wir haben ja einmal den linearen Zusammenhang modelliert und eine Gradengleichung erhalten. Dann haben wir das Ganze auch einmal für den quadratischen Zusammenhang gemacht. Wir wollen jetzt einmal das Modell rechnen und dann noch die erste Ableitung bilden.

Beginnen wir mit dem linearen Zusammenhang. In der folgenden Modellierung rechnen wir einmal ein lineares Modell und erhalten dann den Intercept sowie die Steigung für die Schlupfzeiten. Wir haben hier eine Steigung von \(+10.5\) vorliegen. Für jede Woche mehr Schlupfzeit steigt die Sprungweite um \(10.5cm\) an.

R Code [zeigen / verbergen]

model_ln <- lm(jump_length ~ hatched, data = flea_model_tbl)

tidy(model_ln)# A tibble: 2 × 5

term estimate std.error statistic p.value

<chr> <dbl> <dbl> <dbl> <dbl>

1 (Intercept) 64.2 10.8 5.97 0.000000326

2 hatched 10.5 3.52 2.97 0.00468 Wir können dann den Zusammenhang auch nochmal mathematisch aufschrieben. Wir wolle einmal die Ableitung für die Kovariate bilden. Die erste Ableitung bildet sich dann wie folgt.

\[ \begin{aligned} \operatorname{E}[y \mid x] &= \beta_0 + \beta_1 x \\[4pt] \frac{\partial \operatorname{E}[y \mid x]}{\partial x} &= \beta_1 \end{aligned} \]

Dann können wir das Ganze auch einmal durchführen. Wir haben ja die Zahlen für die Koeffizienten aus dem obigen Modell. Wir setzen also die Zahlen für den Intercept \(\beta_0\) und die Steigung \(\beta_1\) einmal ein und dann leiten wir nach der Schlupfzeit ab. Wir erhalten dann die Steigung von \(+10.5cm\) wieder.

\[ \begin{aligned} \operatorname{E}[\text{Sprungweite} \mid \text{Schlupfzeit}] &= 64.2 + 10.5 \times \text{Schlupfzeit} \\[6pt] \frac{\partial \operatorname{E}[\text{Sprungweite} \mid \text{Schlupfzeit}]}{\partial\ \text{Schlupfzeit}} &= 10.5 \end{aligned} \]

Das war jetzt kein großer Akt, aber wir sehen hier nochmal, wie die Idee ist. Wir hätten hier auch einfach die Koeffizienten aus dem Modell nehmen können, wie wir das auch ganz normal in der Interpretation eines linearen Modells machen. Spannender wird es in dem folgenden Tab, wenn wir eben keinen linearen Zuammenhang haben.

Wenn wir eine quadratische Gleichung in R bauen, dann nutzen wir den Term I() um klar zu machen, dass wir jetzt einen quadratischen Term modellieren wollen. Prinzipiell könnten wir auch hier effizeinter die Funktion poly() nutzen, aber dann sehen wir nicht so gut die Koeffizienten und wir können auch nicht die Gradengleichung so einfach nachbauen. Mehr dazu dann im Kapitel zur nicht linearen Regression. Erstellen wir also einmal unser quadratisches Modell mit drei quadratischen Termen von \(x^1\) bis \(x^3\). Dann können wir die Koeffizienten einmal in unsere mathematische Formel einsetzen.

R Code [zeigen / verbergen]

model_sq <- lm(jump_length ~ hatched + I(hatched^2) + I(hatched^3),

data = flea_model_tbl)

tidy(model_sq)# A tibble: 4 × 5

term estimate std.error statistic p.value

<chr> <dbl> <dbl> <dbl> <dbl>

1 (Intercept) 125. 44.7 2.80 0.00760

2 hatched -53.8 49.0 -1.10 0.278

3 I(hatched^2) 18.9 15.8 1.20 0.238

4 I(hatched^3) -1.61 1.51 -1.07 0.292 Auch hier ist die mathematische Formel etwas länger und wir erhalten dann auch eine quadratische erste Ableitung für die Steigung an verschiedenen Werten der Schlupfzeiten.

\[ \begin{aligned} \operatorname{E}[y \mid x] &= \beta_0 + \beta_1 x + \beta_2 x^2 + \beta_3 x^3\\[4pt] \frac{\partial \operatorname{E}[y \mid x]}{\partial x} &= \beta_1 + 2 \beta_2 x + 3 \beta_3 x^2 \end{aligned} \]

Dann können wir die Koeffizienten aus dem Modell einmal in die Formel einsetzen und die erste Ableitung dann bilden. Hier sehen wir dann sehr schön, dass wir dann für verschiedende Schlupfzeiten immer andere Steigungen erhalten würden.

\[ \begin{aligned} \operatorname{E}[\text{Sprungweite} \mid \text{Schlupfzeit}] = 125 &+ (-53.8 \times \text{Schlupfzeit})\\ &+ (18.9 \times \text{Schlupfzeit}^2)\\ &+ (-1.6 \times \text{Schlupfzeit}^3) \end{aligned} \]

\[ \begin{aligned} \frac{\partial \operatorname{E}[\text{Sprungweite} \mid \text{Schlupfzeit}]}{\partial\ \text{Schlupfzeit}} = -53.8 &+ (2\times 18.9 \times \text{Schlupfzeit})\\ &+ (3 \times -1.6 \times \text{Schlupfzeit}^2) \end{aligned} \]

Wenn wir jetzt für jede Schlupfzeit dann immer die Steigung berechnen müssten, dann wäre das sehr aufwendig. Wir müssten ja erstmal das Modell rechnen, dann die mathematische Formel aufstellen. Danach könnten wir dann ja die erste Ableitung bilden. Je komplexer das Modell, desto aufwendiger wird es. Da kommen jetzt die Marginal effect models ins Spiel, die uns für sehr viele verschiedene Modelle die Steigungen wiedergeben können.

Betrachten wir nochmal die erste Ableitung der quadratischen Funktion für die Sprungweiten aus den Schlupfzeiten. Ich habe hier einmal die Funktion aufgeschrieben und dann einmal drei Werte für die Schlupfzeiten gewählt. Wir erhalten dann die Steigungen an den drei Schlupfzeiten durch die Funktion wiedergegeben. Für das erste ist es etwas ungewohnt, aber wir schauen uns die Steigung gleich einmal an.

R Code [zeigen / verbergen]

jump_hatched_slope <- function(x) -53.8 + (2 * 18.9 * x) + (3 * -1.6 * x^2)

jump_hatched_slope(c(1.25, 3.5, 5.75))[1] -14.05 19.70 4.85In der folgenden Abbildung habe ich dir dan einmal für die drei Schlupfzeiten die Steigung mit der Tangente an den jeweiligen Punkten visualisiert. Wie du siehst haben die drei Punkte jeweils eine andere Steigung. Damit ist die Aussage auf die Sprungweite auch jeweils eine Andere, wenn wir uns verschiedene Schlupfzeiten anschauen. So haben wir zu geringen Schlupfzeiten eher einen Abfall der Sprungweiten und zu höhren Schlupzeiten eine Steigerung der Sprungweiten vorliegen.

Jetzt ist es natürlich nicht immer möglich für jedes Modell die Gradengleichung zu erhalten. Auch wenn wir da mit WolframAlpha gute Möglichkeiten haben, Gleichungen abzuleiten oder aber zu bestimmen. Dennoch ist es für manche Modelle gar nicht so einfach möglich eien geschlossene ableitbare Gleichung zu erstellen. Oder es ist so komplex, dass es nicht erstrebenswert ist. Daher haben wir ja das R Paket {marginaleffects} welches uns für ein beliebiges Datenraster einmal die Steigung bestimmen lässt. Hier also einmal die Steigung für die drei Schlupzeiten.

R Code [zeigen / verbergen]

model_sq |>

slopes(newdata = datagrid(hatched = c(1.25, 3.5, 5.75)),

hypothesis = 0)

hatched Estimate Std. Error z Pr(>|z|) S 2.5 % 97.5 %

1.25 -14.2 17.52 -0.809 0.418 1.3 -48.50 20.2

3.50 19.1 7.85 2.433 0.015 6.1 3.71 34.5

5.75 3.4 20.83 0.163 0.870 0.2 -37.42 44.2

Term: hatched

Type: response

Comparison: dY/dXDas Ganze geht super einfach und wir erhalten auch noch die jeweiligen Fehler sowie einen statistischen Test wiedergegeben, ob sich die Steigung von Null unterscheidet. Wir können hier auch die Option hypothesis = ändern und auf einen anderen Grenzwert testen. Das ist sehr praktisch dazu dann noch die 95% Konfidenzintervalle.

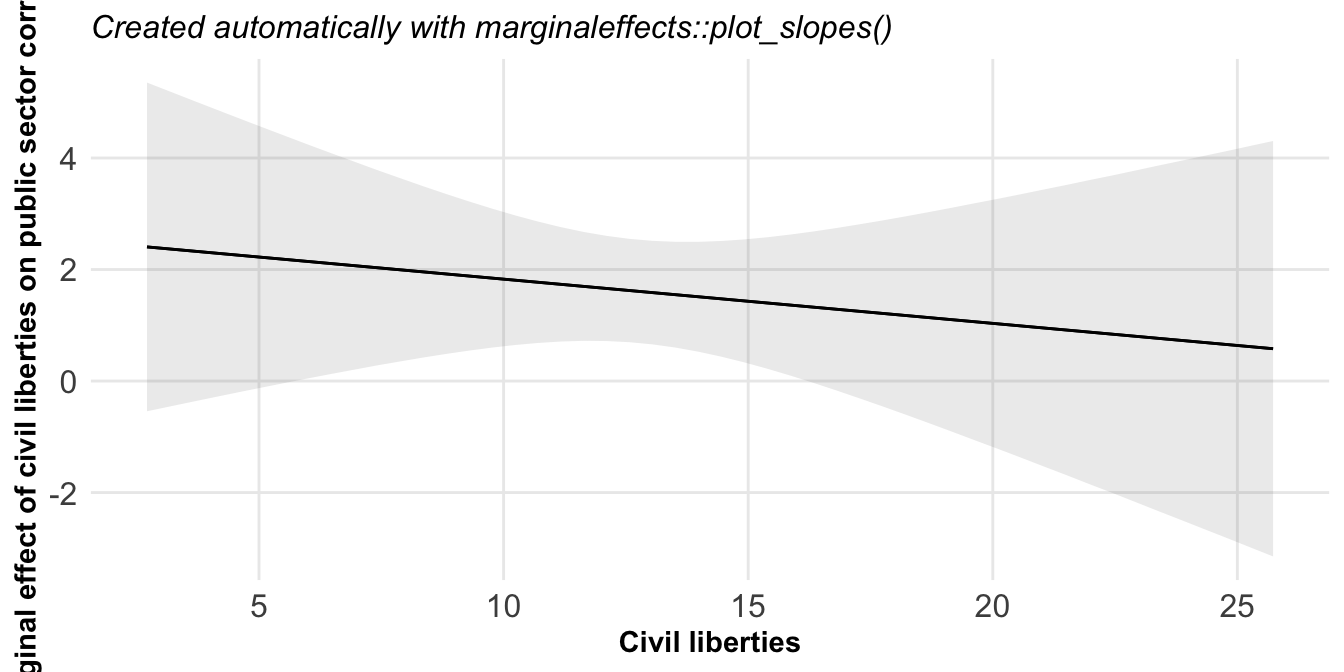

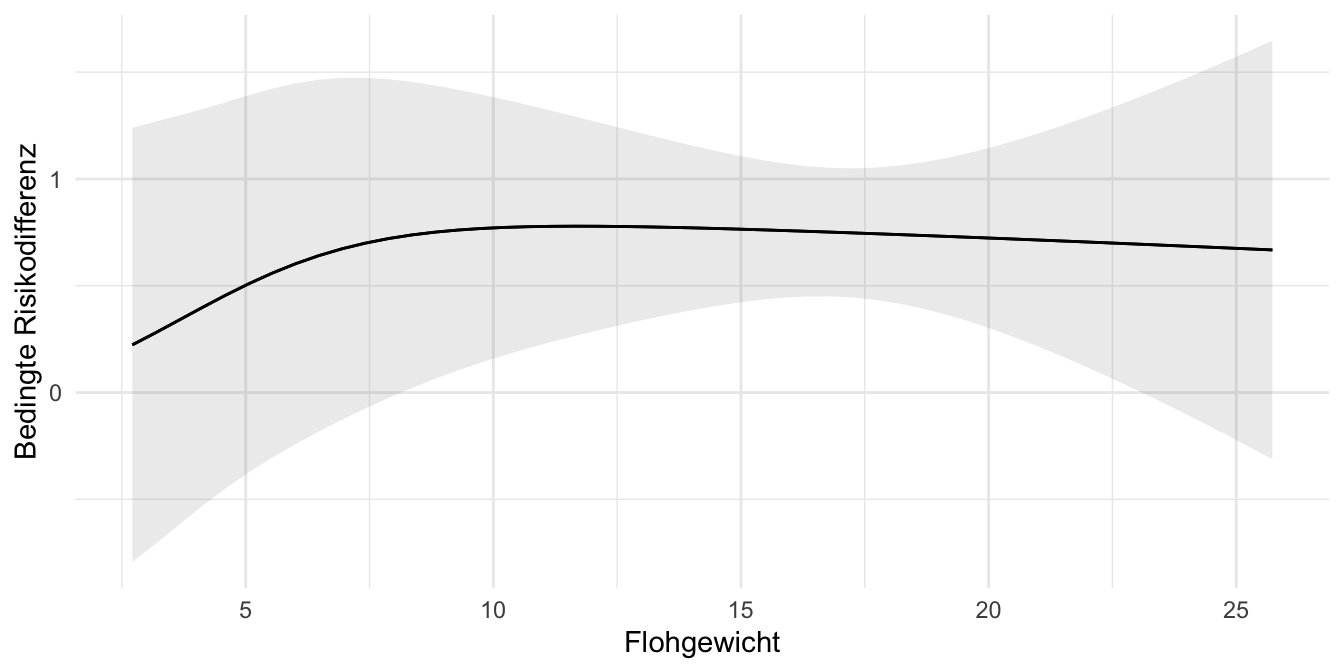

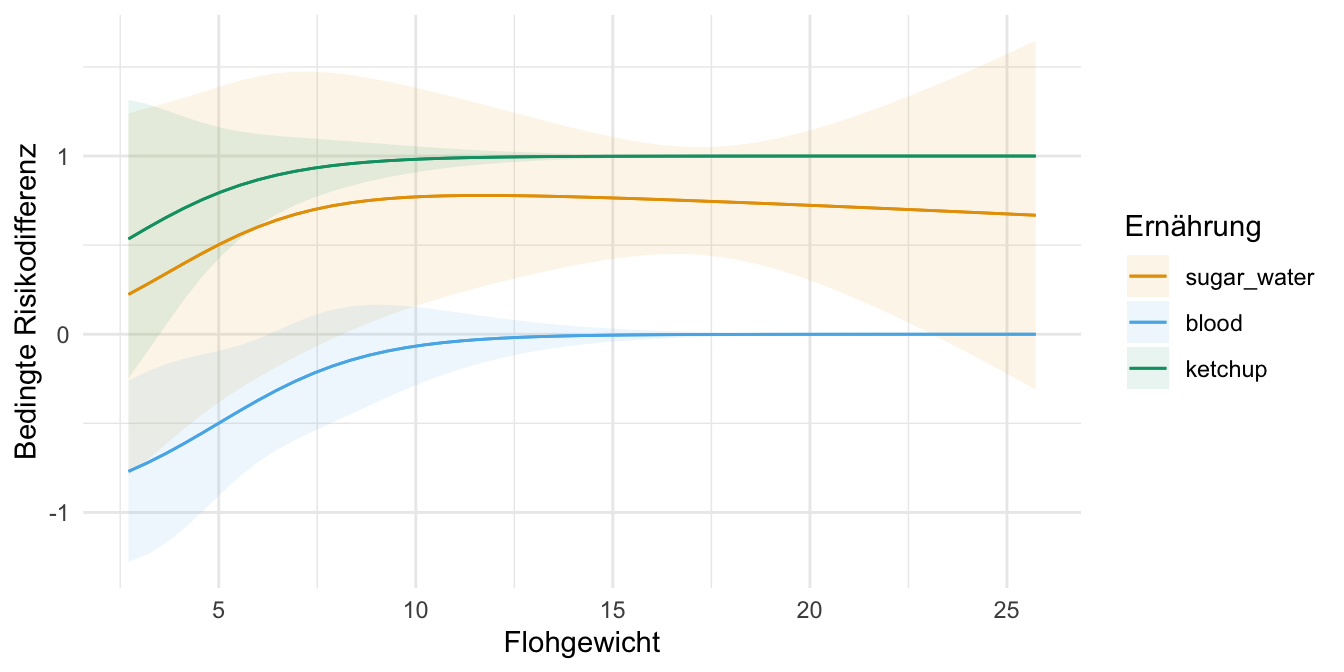

Abschließend mag es ganz interessant sein, wie sich die Steigung über die ganze Kovariate verhält. Also in unserem Fall wie ändert sich die Steigung über die Schlupfzeit? Dafür haben wir dann die Funktion plot_slopes(), die uns dann mit einem Fehlerterm einmal angibt, wie sich die Steigung ändert. Das ist natürlich sehr angenehm, wenn wir ein komplexes Modell haben, was wir uns nicht so einfach darstellen können.

Modellierung von Enzymen

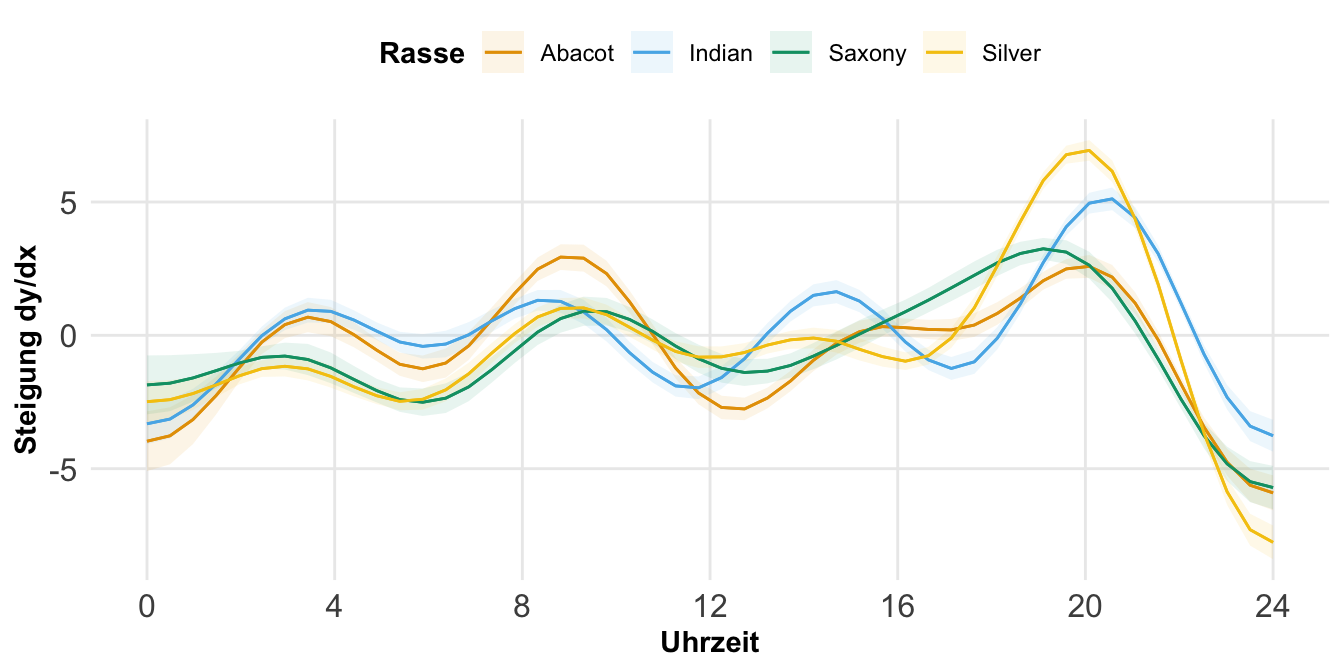

Nachdem wir uns einmal konzeptionell mit der Steigung und damit der Ableitung beschäftigt haben, kommen wir einmal zu einem etwas komplexeren beispiel mit unseren Enzym. Wir haben ja hier eine klare S-Kurve in der Enzymaktivität vorliegen. Da wir ja das theoretische Modell kennen, können wir auch hier einfach die Ableitung bilden. In der Praxis kennen wir aber das theoretsiche Modell nicht sondern müssen eben die Grade mit einem Algorithmus anpassen. In den folgenden Tabs zeige ich dir dann einmal die Anpassung mit verschiedenen Algorithmen. Dazu habe ich dann auch immer mit dem R Paket {marginaleffects} an drei augewählten Werten des pH-Wertes die Steigung berechnet. Die Koeffizienten aller drei Modelle lassen sich nicht direkt einfach interpretieren. Die Steigung jedoch schon.

Die beste Möglichkeit eine Modellierung zu rechnen ist die Nutzung von Generalized additive model (abk. GAM), die sehr effizient komplexe Verläufe mit einer Graden versehen können. Der größte Nacvhteil ist, dass wir eigentlich mit der Ausgabe der Koeffizienten eines Generalized additive model wenig anfangen können. Jedenfalls was die direkte Interpretation angeht. Hier helfen dann die Steigungen an vordefinierten Punkten natürlich super weiter. oder aber wir berechnen die mittlere Steigung. Hier erstmal das Generalized additive model geschätzt. Wir müssen nur sagen, welche Variable mit s() nicht linear modelliert werden soll.

R Code [zeigen / verbergen]

gam_fit <- gam(activity ~ s(ph), data = enzyme_tbl)Dann können wir uns auch für drei standardisierte pH-Werte die Steigung wiedergeben lassen. Wir müssen hier also nicht schauen, wie das Modell aussieht oder aber was die Gradengleichung wäre. Alles macht dann die Funktion slope() für uns.

R Code [zeigen / verbergen]

slopes(gam_fit, newdata = datagrid(ph = c(-1, 2, 6)))

ph Estimate Std. Error z Pr(>|z|) S 2.5 % 97.5 %

-1 28.7 3.95 7.27 < 0.001 41.4 20.99 36.47

2 -11.4 4.12 -2.77 0.00552 7.5 -19.49 -3.35

6 18.1 4.50 4.02 < 0.001 14.1 9.28 26.92

Term: ph

Type: response

Comparison: dY/dXManchmal wollen wir auch die durchschnittliche Steigung über alle Kovariatenwerte haben, dann können wir die Funktion avg_slopes() nutzen. Wenn wir eine sehr stark kurvige Grade haben, dann müssen wir überlegen, ob der Durchschnitt viel aussagt.

R Code [zeigen / verbergen]

avg_slopes(gam_fit)

Estimate Std. Error z Pr(>|z|) S 2.5 % 97.5 %

15.3 1.17 13.1 <0.001 127.3 13 17.6

Term: ph

Type: response

Comparison: dY/dXAm Ende können wir uns dann einmal die beiden Modelle mit den jeweiligen Steigungen anschauen. Auf der linken Seite findest du das theoretische Modell mit dem die Daten generiert wurden und damit auch die wahren Steigungen an den pH-Werten. In der rechten Abbildung siehst du dann die Abweichung durch das Generalized additive model. So weit liegen die Werte aber gar nicht auseinander.

Die polynomiale Regression bietet sich an, wenn wir eine effiziente Variante der I() Form haben wollen. Wir müssen ja sonst immer sehr lange Terme schreiben, da wir alle Hochzahlen in Form von I() ausformulieren müssen. Die Variante mit poly() erlaubt uns die Kovariate zu benennen die mit quadratischen Termen modelliert werden soll. Wir müssen nur angeben, wie viele Exponenten wir haben wollen. In diesem Fall wähle ich drei Exponenten aus und damit modellieren wir eben \(x^1 + x^2 + x^3\) in dem Modell. Darüber hinaus ist die Funktion poly() auch sehr effizient.

R Code [zeigen / verbergen]

poly_fit <- lm(activity ~ poly(ph, 3), data = enzyme_tbl)Dann können wir uns auch für drei standardisierte pH-Werte die Steigung wiedergeben lassen. Wir müssen hier also nicht schauen, wie das Modell aussieht oder aber was die Gradengleichung wäre. Alles macht dann die Funktion slope() für uns.

R Code [zeigen / verbergen]

slopes(poly_fit, newdata = datagrid(ph = c(-1, 2, 6)))

ph Estimate Std. Error z Pr(>|z|) S 2.5 % 97.5 %

-1 28.3 2.44 11.57 <0.001 100.5 23.5 33.04

2 -10.3 1.14 -9.08 <0.001 63.0 -12.6 -8.11

6 21.4 1.63 13.16 <0.001 129.0 18.3 24.64

Term: ph

Type: response

Comparison: dY/dXManchmal wollen wir auch die durchschnittliche Steigung über alle Kovariatenwerte haben, dann können wir die Funktion avg_slopes() nutzen. Wenn wir eine sehr stark kurvige Grade haben, dann müssen wir überlegen, ob der Durchschnitt viel aussagt.

R Code [zeigen / verbergen]

avg_slopes(poly_fit)

Estimate Std. Error z Pr(>|z|) S 2.5 % 97.5 %

15.9 0.973 16.4 <0.001 197.3 14 17.8

Term: ph

Type: response

Comparison: dY/dXAm Ende können wir uns dann einmal die beiden Modelle mit den jeweiligen Steigungen anschauen. Auf der linken Seite findest du das theoretische Modell mit dem die Daten generiert wurden und damit auch die wahren Steigungen an den pH-Werten. In der rechten Abbildung siehst du dann die Abweichung durch polynomiale Regression. So weit liegen die Werte aber gar nicht auseinander.

Eine etwas ältere Alternative zu dem Generalized additive model ist die lokale lineare Kernregression (eng. locally estimated scatterplot smoothing, abk. loess) oder einfach Loessregression. Hier müssen wir gar nichts weiter angeben, sondern können einfach die Funktion aufrufen. Wir erhalten hier aber keine Informationen über die Streuung der Punkte um die Loessgrade, so dass wir gleich nicht alles mit {marginaleffects} machen können, was in den beiden anderen Modellierungen geht.

R Code [zeigen / verbergen]

loess_fit <- loess(activity ~ ph, data = enzyme_tbl)Dann können wir uns auch für drei standardisierte pH-Werte die Steigung wiedergeben lassen. Wir müssen hier also nicht schauen, wie das Modell aussieht oder aber was die Gradengleichung wäre. Alles macht dann die Funktion slope() für uns.

R Code [zeigen / verbergen]

slopes(loess_fit, newdata = datagrid(ph = c(-1, 2, 6)))

ph Estimate

-1 22.37

2 -4.74

6 21.85

Term: ph

Type: response

Comparison: dY/dXManchmal wollen wir auch die durchschnittliche Steigung über alle Kovariatenwerte haben. Da wir hier ein Problem mit der Varianzmatrix haben, müssen wir uns den Durchschnitt einmal händisch berechnen. Das geht aber auch sehr fix und wir erhalten faktisch die gleichen Werte nur eben ohne Standardfehler und andere statistische Maßzahlen.

R Code [zeigen / verbergen]

slopes(loess_fit) |>

summarise(avg_slope = mean(estimate)) avg_slope

1 10.9319Am Ende können wir uns dann einmal die beiden Modelle mit den jeweiligen Steigungen anschauen. Auf der linken Seite findest du das theoretische Modell mit dem die Daten generiert wurden und damit auch die wahren Steigungen an den pH-Werten. In der rechten Abbildung siehst du dann die Abweichung durch Loessregression. So weit liegen die Werte aber gar nicht auseinander. Ich würde hier aber nur die Loesregression nutzen, wenn es unbedingt sein muss. Die Generalized additive models sind mittlerweile einfach die bessere Alternative.

Damit haben wir den einfachen Fall mit einem einkovariaten Modell einmal bearbeitet. Häufig haben wir aber mehrere Kovariaten im Modell oder aber eine Kombination von einer Kovariate und einem grupppierenden Faktor. Dann können wir uns dennoch die Steigung berechnen lassen. Hier ist es vermutlich die Stärke von {marginaleffects}, dass wir hier dann einfach weiter machen können.

54.7.2 Mehrkovariates Modell

Wir können natürlich auch den Fall vorliegen haben, dass wir dann zwei oder mehr Kovariaten in einem Modell haben. Ich habe hier einmal das lineare Modell mit zwei Kovariaten der Schlupfzeit und dem Gewicht der Flöhe angepasst. Wir haben jetzt gleich verschiedene Möglichkeiten uns die Steigung einmal wiedergeben zu lassen.

R Code [zeigen / verbergen]

model_ln <- lm(jump_length ~ hatched + weight, data = flea_model_tbl)

tidy(model_ln)# A tibble: 3 × 5

term estimate std.error statistic p.value

<chr> <dbl> <dbl> <dbl> <dbl>

1 (Intercept) 65.4 13.1 5.01 0.00000903

2 hatched 10.5 3.59 2.94 0.00517

3 weight -0.141 0.850 -0.165 0.869 Hier können wir uns auch die gemittelte Steigung an den für die Schlupfzeiten und die Flohgewichte wiedergeben lassen. Hier kommt es dann darauf an, was du wissen willst. Die lineare Regression liefert ja faktisch die Steigung und so erhalten wir hier auch die gleichen Werte wieder.

R Code [zeigen / verbergen]

model_ln |>

avg_slopes()

Term Estimate Std. Error z Pr(>|z|) S 2.5 % 97.5 %

hatched 10.539 3.59 2.940 0.00329 8.2 3.51 17.57

weight -0.141 0.85 -0.165 0.86871 0.2 -1.81 1.53

Type: response

Comparison: dY/dXSpannender wird es dann bei nicht linearen Modellen, wo wir dann natürlich nicht die gleiche Steigung an jeder Kombination vorliegen haben. Auch hier muss ich dich nochmal auf die Vingette zu den Steigungen (eng. slopes) des R Paketes {marginaleffects} für mehr verweisen. Meistens haben wir dann nicht ein mehrkovariates Modell vorliegen sondern wollen dann eine Kovariate nach einem Faktor gruppieren. Dazu kommen wir dann im nächsten Abschnitt.

54.7.3 Kombiniertes Modell

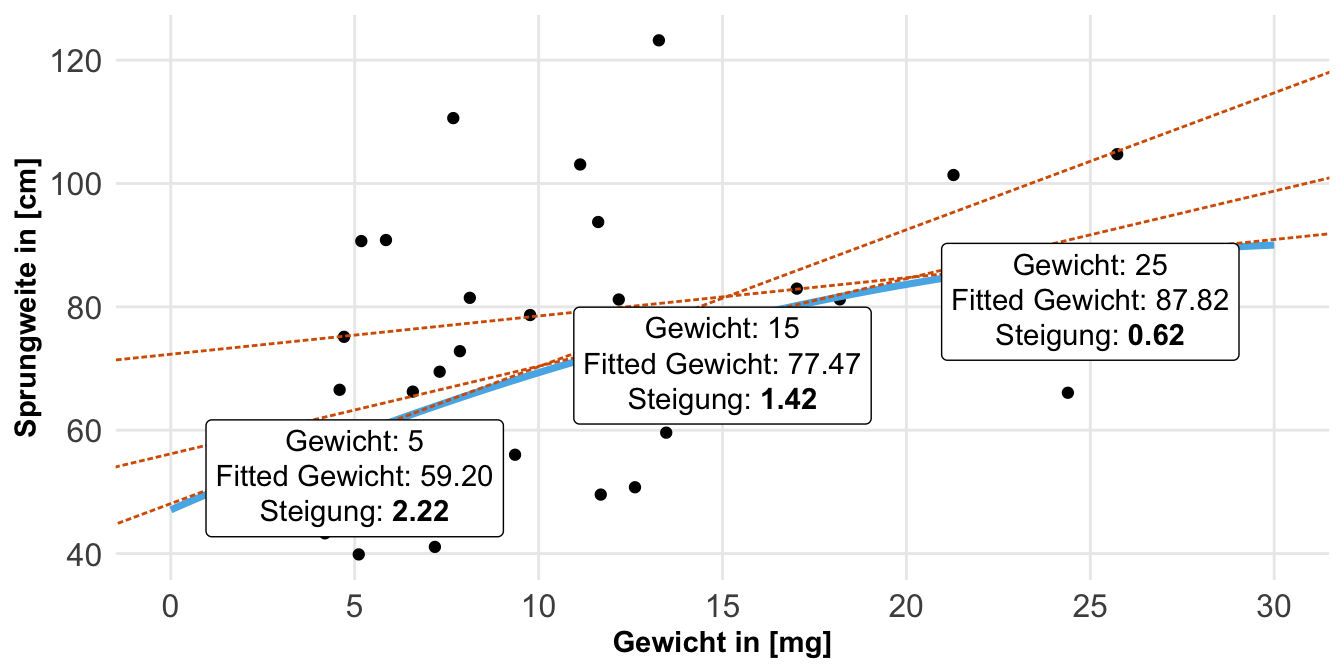

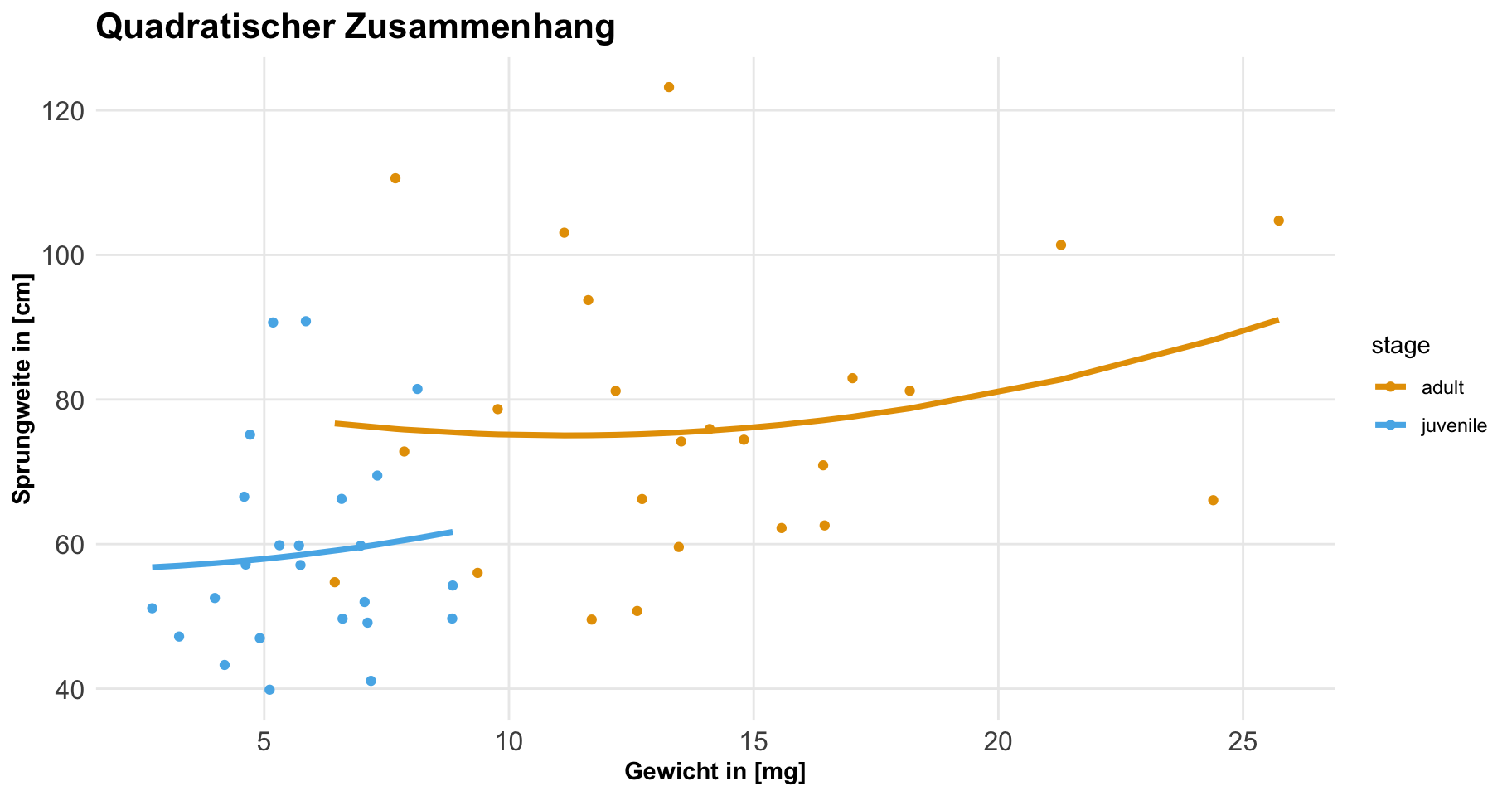

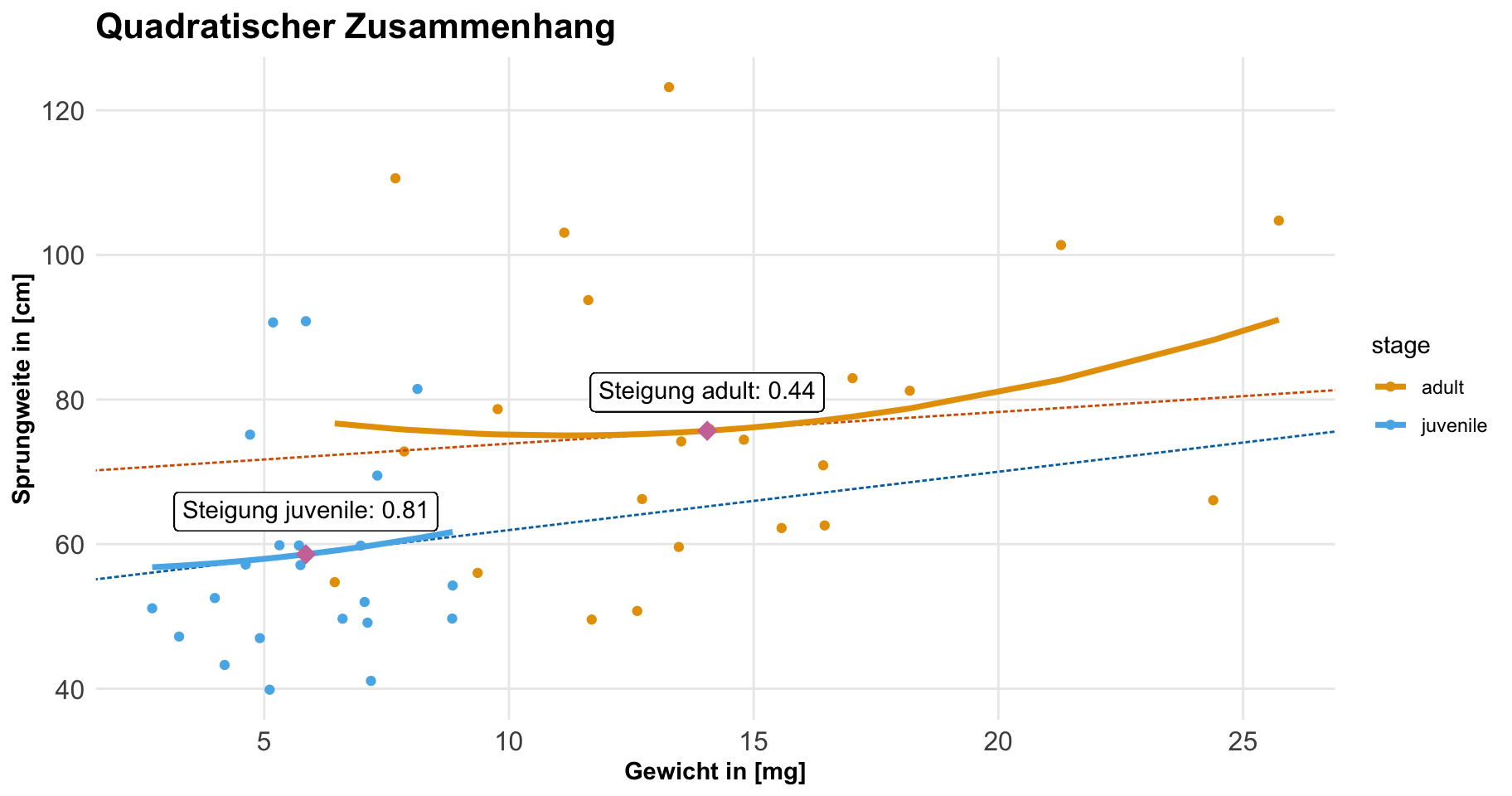

Jetzt wollen wir ein kombiniertes Modell rechnen. Wir haben hier eigentlich das klassische Design einer ANCOVA vorliegen. Wir kombinieren eine Kovariate mit einem Faktor. Bei der ANCOVA lesen wir das meist andersherum, aber hier geht es ja primär darum, wie sich die Kovariate ändert. Wenn wir dann noch einen gruppierenden Faktor mit ins Modell nehmen, dann geht es darum, wie sich die Kovariate in den Gruppen des Faktors ändert. Dann können wir natürlich noch Werte für die Kovariate festlegen, die uns dann besonders interessieren. Wenn wir das Modell bauen, dann ist die Anordnung der Einflussvariablen wichtig. Erst kommt die gruppierende Variable, dann der Rest. Hier haben wir also das Modell der Sprungweite und die beiden Einflussvariablen des Entwicklungsstandes sowie dem Gewicht. Dabei wollen wir das Gewicht dann quadratisch modellieren, was hier schon der große Unterschied zur ANCOVA ist. In der ANCOVA ist alles linear.

R Code [zeigen / verbergen]

model_grp_sq <- lm(jump_length ~ stage * weight + I(weight^2),

data = flea_model_tbl)

tidy(model_grp_sq)# A tibble: 5 × 5

term estimate std.error statistic p.value

<chr> <dbl> <dbl> <dbl> <dbl>

1 (Intercept) 130. 56.7 2.29 0.0267

2 stagejuvenile -73.1 56.2 -1.30 0.200

3 weight -6.17 7.50 -0.823 0.415

4 I(weight^2) 0.213 0.231 0.920 0.363

5 stagejuvenile:weight 11.5 6.45 1.78 0.0816Wie immer ist komplexeres Modell schwierig an den Koeffizienten zu interpretieren. Deshalb schauen wir uns einmal in der folgenden Abbildung die Graden an. Wie wir sehen, ist der Zusammenhang zwischen dem Gewicht und der Sprungweite bei den juvenilen Flöhen eher linear, bei den adulten Flöhen dann eher quadratisch. Damit würden wir dann pro Gruppe auch eine andere Steigung über die Kovariate des Gewichts erwarten.

In den beiden folgenden Tabs zeige ich dir einmal wie du die Steigung in den beiden Gruppen für da Gewicht mit dem R Paket {marginaleffects} und slopes() berechnest. Dann habe ich das auch nochmal Schritt für Schritt gemacht, damit du nochmal nachvollziehen kannst, wie sich die Steigungen in den Gruppen ergeben.

Wir können uns die Steigung für die Kovariate weight einmal berechnen lassen. Wir wollen die Steigung aber über den Faktor stage mitteln. Wir mitteln hier immer, da wir eben nicht für jeden Wert des Gewichts und der Gruppe einen Wert erhalten.

R Code [zeigen / verbergen]

model_grp_sq |>

slopes(variables = "weight",

by = "stage")

stage Estimate Std. Error z Pr(>|z|) S 2.5 % 97.5 %

adult -0.192 1.68 -0.114 0.909 0.1 -3.486 3.1

juvenile 7.826 4.27 1.832 0.067 3.9 -0.549 16.2

Term: weight

Type: response

Comparison: dY/dXWir wir sehen, ist die mittlere Steigung bei den juvenilen Flöhe sehr hoch, bei den adulten Flöhen eher niedrig. Hier müssen wir dann gleich nochmal in die Abbildung rein, da wir ja bei den adulten Flöhen eher einen quadratischen Zusammenhang vorliegen haben. Somit könnten sich auch Steigungen raus kürzen, wenn es erst runter und dann wieder rauf geht.

Wir können die Steigungen auch erst für die Variable weight berechnen und dann erhalten wir alle Werte wiedergeben.

R Code [zeigen / verbergen]

mfx_grp_sq <- model_grp_sq |>

slopes(variables = "weight")

head(mfx_grp_sq)

Estimate Std. Error z Pr(>|z|) S 2.5 % 97.5 %

0.815 1.46 0.5574 0.577 0.8 -2.05 3.68

-0.801 2.10 -0.3818 0.703 0.5 -4.91 3.31

0.454 1.45 0.3123 0.755 0.4 -2.39 3.30

4.205 4.17 1.0073 0.314 1.7 -3.98 12.39

0.828 1.46 0.5653 0.572 0.8 -2.04 3.70

0.126 1.53 0.0822 0.934 0.1 -2.88 3.13

Term: weight

Type: response

Comparison: dY/dXDanach können wir dann die Steigungen nach dem Entwicklungsstand gruppieren und mitteln.

R Code [zeigen / verbergen]

mfx_grp_sq |>

group_by(stage) |>

summarize(stage_ame = mean(estimate))# A tibble: 2 × 2

stage stage_ame

<fct> <dbl>

1 adult -0.192

2 juvenile 7.83 Wir erhalten dann die gleichen Werte wie auch mit der Funktion slopes() aus dem vorherigen Tab nur eben ohne weitere statistische Maßzahlen.

Dann ergänzen wir einmal die Steigungen in der folgenden Abbildung. Wir sehen hier sehr schön die Steigung bei den juvenilen Flöhen. Nehmen die juvenilen Flöhe zu, dann nimmt auch die Sprungweite sehr schnell an Wert zu. Anders sieht es bei den adulten Flöhen aus. Hier haben wir dann einen Abfall der Leistung mit einer Steigerung am Ende des Spektrums des Gewichts. Daher bietet sich hier insbesondere an, sich für repräsentative Werte einmal die Steigung wiedergeben zu lassen.

Wenn wir uns jetzt an verschiedenen Flohgewichten die Steigung anschauen wollen, dann müssen wir auch definieren, welchen Entwicklungsstand wir betrachten wollen. Da wir jetzt mal über beide Stadien uns die Steigung anschauen wollen, sage ich hier einmal, dass ich über jedes Level des Entwicklungsstadium haben will. Hier kann ich dann unique nutzen, damit ich nicht alle Level eintippen muss.